In diesem Blog werden wir die unten bereitgestellten Inhalte behandeln:

- Wie kann ich die Textgenerierung anpassen, indem ich ein Modell mit der „Pipeline“-Funktion von Transformers lade?

- Wie verwende ich ein transformatorbasiertes Modell zum Generieren von Text in PyTorch?

- Wie verwende ich ein transformatorbasiertes Modell zum Generieren von Text in TensorFlow?

Wie kann ich die Textgenerierung anpassen, indem ich das Modell mit der „Pipeline“-Funktion von Transformers lade?

Der ' Pipeline Die Funktion „Wird verwendet, um das vorab trainierte KI-Modell entsprechend den Anforderungen des Benutzers automatisch herunterzuladen. Um diese spezielle Funktion nutzen zu können, müssen Benutzer das „ Transformer ' Pakete. Dieses Paket bietet Zugriff auf hochmoderne Transformer-basierte Modelle, die neben einer Stimmungsanalyse auch viele andere durchführen können Verarbeitung natürlicher Sprache (NLP) Aufgaben.

Um die praktische Demonstration des oben beschriebenen Szenarios zu sehen, fahren Sie mit den unten angegebenen Schritten fort!

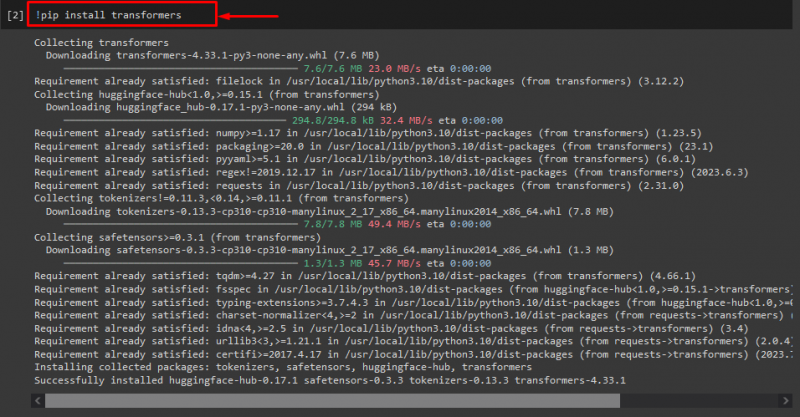

Schritt 1: „Transformers“-Pakete installieren

Führen Sie zunächst den Befehl „!“ aus. Pip' Befehl zum Installieren der Transformer-Pakete:

! Pip-Transformatoren installieren

Wie Sie sehen, wurde das angegebene Paket erfolgreich installiert:

Schritt 2: Transformer-basiertes Modell importieren

Anschließend importieren Sie das erforderliche transformatorbasierte Modell. Importieren Sie dazu zunächst das „ Pipeline ” Funktion von „ Transformer “. Als nächstes verwenden Sie die importierte Funktion und übergeben das „ Textgenerierung ” als Argument dazu zusammen mit dem erforderlichen Modellnamen „ gpt2 “. Als nächstes übergeben Sie sie an „ generieren ” Variable:

aus Transformer importieren Pipeline

generieren = Pipeline ( 'Textgenerierung' , Modell = 'gpt2' )

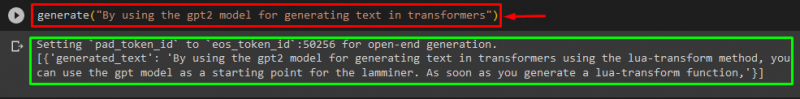

Schritt 3: Generieren Sie einen benutzerdefinierten Text

Übergeben Sie nun den gewünschten Text als Argument an „ generieren “. Wie nachfolgend dargestellt:

generieren ( „Durch die Verwendung des gpt2-Modells zur Textgenerierung in Transformatoren“ )Laut der bereitgestellten Ausgabe ist das heruntergeladene vorab trainierte „ gpt3 „Modell wurde erfolgreich generierter Text:

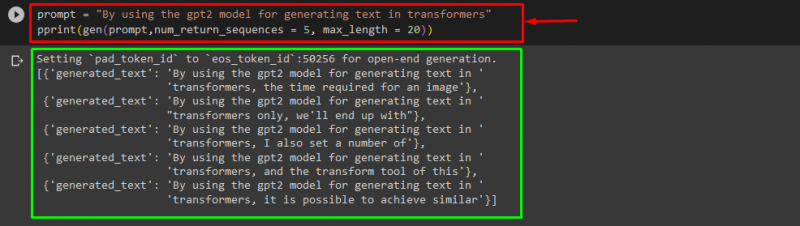

Sie können auch die anderen Argumente verwenden, wie zum Beispiel:

prompt = „Durch die Verwendung des gpt2-Modells zur Textgenerierung in Transformatoren“drucken ( Gen ( prompt , num_return_sequences = 5 , maximale Länge = zwanzig ) )

Hier:

- „ prompt „wird als Argument verwendet, das Eingaben zurückhält.

- „ num_return_sequence Das Argument „wird verwendet, um die Anzahl der Sequenzen des bereitgestellten Textes zu generieren.

- „ maximale Länge Das Argument „“ wird verwendet, um die Länge des generierten Textes anzugeben. In unserem Fall beschränkt es sich auf „ 30 „Tokens (Wörter oder Satzzeichen):

Notiz: Der angepasste Text ist eine Fortsetzung der angegebenen Eingabeaufforderung, die auf den Trainingsdaten des Modells basiert.

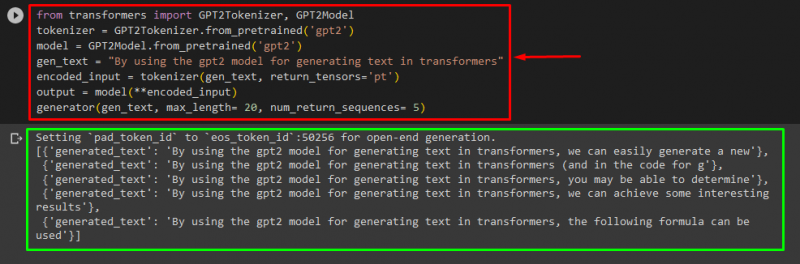

Wie verwende ich ein transformatorbasiertes Modell zum Generieren von Text in PyTorch?

Benutzer können den Text auch in „ PyTorch ” Das ist das „ Fackel ”basiertes Framework für maschinelles Lernen. Es wird für verschiedene Anwendungen wie NLP und Computer Vision verwendet. Um das transformatorbasierte Modell zum Anpassen des Texts in PyTorch zu verwenden, importieren Sie zunächst „ GPT2Tokenizer ' Und ' GPT2Modell „Funktionen aus dem“ Transformer ”:

aus Transformer importieren GPT2Tokenizer , GPT2ModellVerwenden Sie dann die „ GPT2Tokenizer „Tokenizer gemäß unserem gewünschten vorab trainierten Modell mit dem Namen „ gpt2 ”:

Tokenizer = GPT2Tokenizer. from_pretrained ( 'gpt2' )Anschließend werden die Gewichte aus einem vorab trainierten Modell instanziiert:

Modell = GPT2Modell. from_pretrained ( 'gpt2' )Als nächstes deklarieren Sie ein „ gen_text ”-Variable, die den Text enthält, den wir anpassen möchten:

gen_text = „Durch die Verwendung des gpt2-Modells zur Textgenerierung in Transformatoren“Übergeben Sie nun das „ gen_text ' Und ' return_tensors=‘pt’ ” als Argument, das den Text in PyTorch generiert und den generierten Wert im „ encoded_input ” Variable:

encoded_input = Tokenizer ( gen_text , return_tensors = 'pt' )Übergeben Sie abschließend das „ encoded_input ”-Variable, die den benutzerdefinierten Text für die „ Modell ” als Parameter und erhalten Sie die resultierende Ausgabe mit dem Befehl „ maximale Länge ”-Argument, das auf „ zwanzig ” was darauf hinweist, dass der generierte Text auf die bereitgestellten Token beschränkt ist, das „ num_return_sequences ” das auf „ eingestellt ist 5 Das zeigt, dass der generierte Text auf fünf Textsequenzen basiert:

Ausgabe = Modell ( **encoded_input )Generator ( gen_text , maximale Länge = zwanzig , num_return_sequences = 5 )

Ausgabe

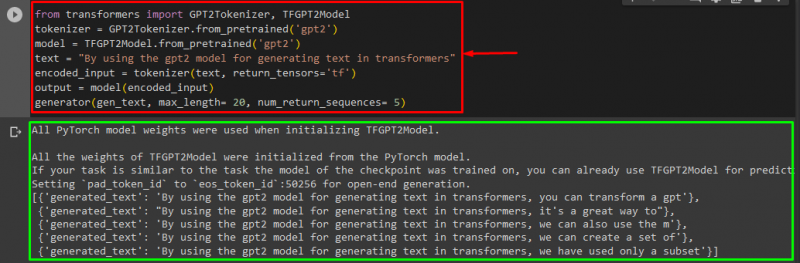

Wie verwende ich ein transformatorbasiertes Modell zum Generieren von Text in TensorFlow?

Zum Generieren des Textes in Transformers wird das „ TensorFlow Es kommen auch basierte Machine-Learning-Frameworks zum Einsatz. Importieren Sie dazu zunächst die benötigten Funktionen, wie zum Beispiel „ GPT2Tokenizer ' Und ' TFGPT2Modell ' von dem ' Transformer “. Der Rest des Codes ist derselbe wie oben, nur verwenden wir das „ TFGPT2Modell ”-Funktion anstelle der „ GPT2Modell ” Funktion. Wie folgt:

aus Transformer importieren GPT2Tokenizer , TFGPT2ModellTokenizer = GPT2Tokenizer. from_pretrained ( 'gpt2' )

Modell = TFGPT2Modell. from_pretrained ( 'gpt2' )

Text = „Durch die Verwendung des gpt2-Modells zur Textgenerierung in Transformatoren“

encoded_input = Tokenizer ( Text , return_tensors = 'tf' )

Ausgabe = Modell ( encoded_input )

Generator ( gen_text , maximale Länge = zwanzig , num_return_sequences = 5 )

Wie Sie sehen, wurde der benutzerdefinierte Text erfolgreich generiert:

Das ist es! Wir haben die Anpassung der Textgenerierung in Transformers näher erläutert.

Abschluss

Um die Textgenerierung in Transformers anzupassen, gibt es verschiedene Möglichkeiten, z. B. das Laden des Modells mit der Pipeline-Funktion oder die Verwendung des transformatorbasierten Modells in „ PyTorch ' Und ' TensorFlow “, die auf Frameworks für maschinelles Lernen basieren. In diesem Leitfaden haben wir kurze Informationen sowie eine praktische Demonstration zum Anpassen der Textgenerierung in Transformers bereitgestellt.