In diesem Blog konzentrieren wir uns auf die Möglichkeiten, wie Sie die GPU-Auslastung in PyTorch steigern können.

Wie kann die GPU-Auslastung in PyTorch erhöht werden?

Es gibt verschiedene Techniken, die eingesetzt werden können, um die GPU-Auslastung zu erhöhen und sicherzustellen, dass die besten Hardwareressourcen für die Verarbeitung komplexer Modelle für maschinelles Lernen genutzt werden. Diese Taktiken umfassen das Bearbeiten des Codes und die Nutzung von PyTorch-Funktionen. Nachfolgend sind einige wichtige Tipps und Tricks aufgeführt:

- Laden von Daten und Stapelgrößen

- Weniger speicherabhängige Modelle

- PyTorch Lightning

- Passen Sie die Laufzeiteinstellungen in Google Colab an

- Cache zur Optimierung leeren

Laden von Daten und Stapelgrößen

Der ' Datenlader ” wird in PyTorch verwendet, um die Spezifikationen der Daten zu definieren, die bei jedem Vorwärtsdurchlauf des Deep-Learning-Modells in den Prozessor geladen werden sollen. Ein grösseres ' Chargengröße ” an Daten erfordern mehr Rechenleistung und erhöhen die Auslastung der verfügbaren GPU.

Die Syntax zum Zuweisen eines Dataloaders mit einer bestimmten Batchgröße in PyTorch zu einer benutzerdefinierten Variablen ist unten angegeben:

Improve_GPU_Utilization = DataLoader ( Batch_Größe = 32 )

Weniger speicherabhängige Modelle

Jede Modellarchitektur erfordert ein anderes Volumen an „ Erinnerung ” um auf optimalem Niveau zu arbeiten. Modelle, die effizient weniger Speicher pro Zeiteinheit verbrauchen, können mit Batchgrößen arbeiten, die weitaus größer sind als die anderer.

PyTorch Lightning

PyTorch hat eine verkleinerte Version, die „ PyTorch Lightning “. Es ist auf blitzschnelle Leistung optimiert, wie der Name schon sagt. Lightning verwendet standardmäßig GPUs und bietet eine viel schnellere Verarbeitung für Modelle für maschinelles Lernen. Ein großer Vorteil von Lightning besteht darin, dass kein Boilerplate-Code erforderlich ist, der die Verarbeitung behindern kann.

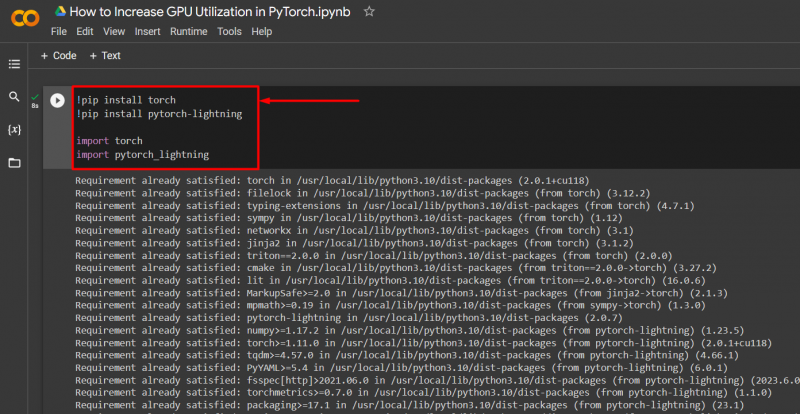

Importieren Sie die erforderlichen Bibliotheken mit der unten angegebenen Syntax in ein PyTorch-Projekt:

! Pip-Brenner installieren

! Pip Pytorch installieren - Blitz

importieren Fackel

importieren pytorch_lightning

Passen Sie die Laufzeiteinstellungen in Google Colab an

Das Google Colaboratory ist eine Cloud-IDE, die ihren Benutzern kostenlosen GPU-Zugriff für die Entwicklung von PyTorch-Modellen bietet. Standardmäßig werden die Colab-Projekte auf der CPU ausgeführt, die Einstellungen können jedoch geändert werden.

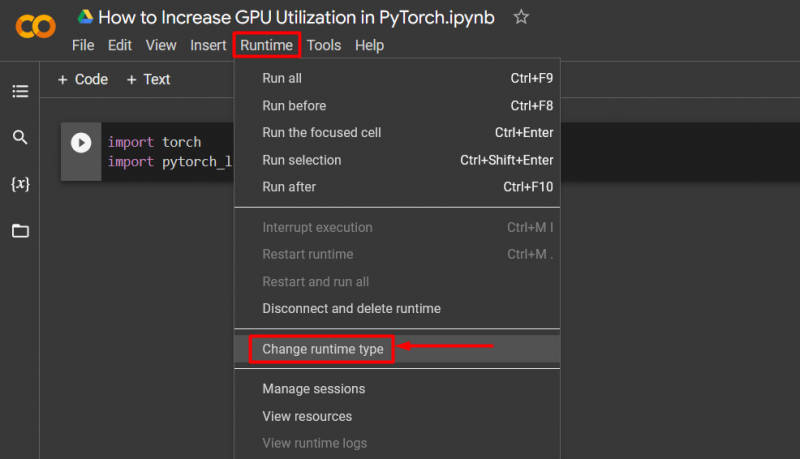

Öffnen Sie das Colab-Notizbuch und gehen Sie zu „ Laufzeit ”-Option in der Menüleiste und scrollen Sie nach unten zu „ Laufzeiteinstellungen ändern ”:

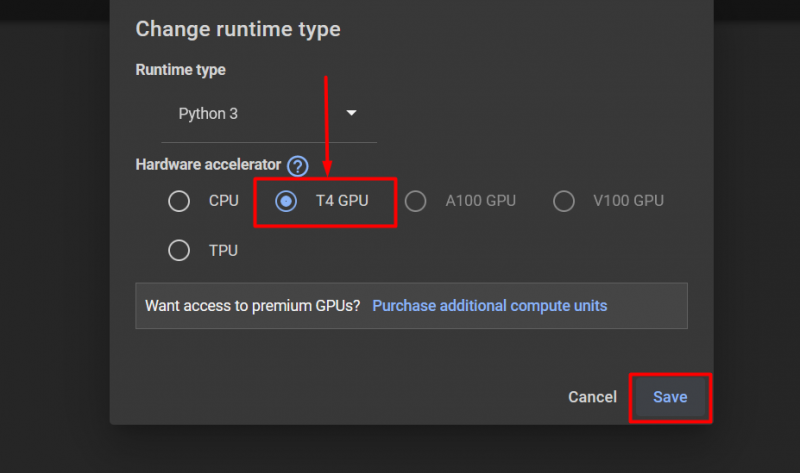

Wählen Sie dann die aus „T4-GPU“ Option und klicken Sie auf „ Speichern ” um die Änderungen zur Nutzung der GPU anzuwenden:

Cache zur Optimierung leeren

PyTorch ermöglicht seinen Benutzern, den Speichercache zu leeren, um Platz für die Ausführung neuer Prozesse freizugeben. Der ' Zwischenspeicher ” speichert Daten und Informationen über die ausgeführten Modelle, sodass Zeit gespart werden kann, die für das Neuladen dieser Modelle aufgewendet wird. Durch das Leeren des Caches erhalten Benutzer mehr Platz zum Ausführen neuer Modelle.

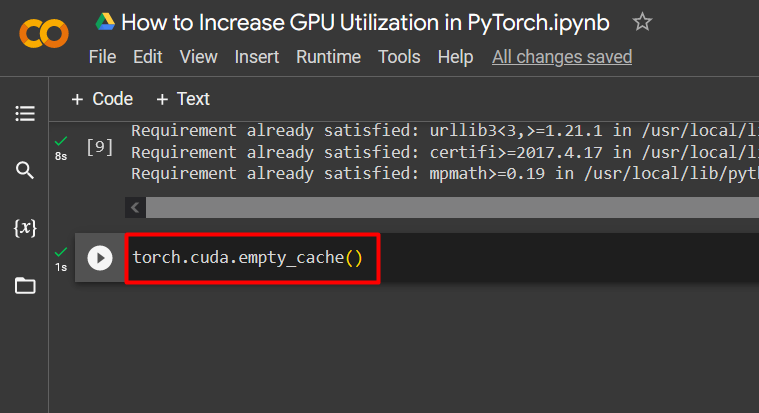

Der Befehl zum Löschen des GPU-Cache ist unten angegeben:

Fackel. anders . empty_cache ( )

Diese Tipps werden verwendet, um die Ausführung von Modellen für maschinelles Lernen mit GPUs in PyTorch zu optimieren.

Profi-Tipp

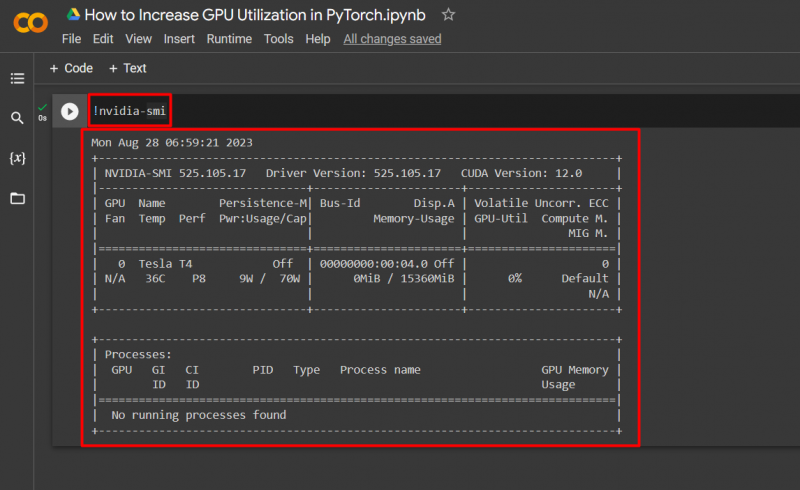

Google Colab ermöglicht seinen Nutzern den Zugriff auf Details zur GPU-Nutzung durch „ NVIDIA ” um Informationen darüber zu erhalten, wo die Hardwareressourcen genutzt werden. Der Befehl zum Anzeigen der GPU-Auslastungsdetails ist unten angegeben:

! NVIDIA - lächle

Erfolg! Wir haben gerade einige Möglichkeiten gezeigt, die GPU-Auslastung in PyTorch zu erhöhen.

Abschluss

Erhöhen Sie die GPU-Auslastung in PyTorch, indem Sie den Cache löschen, PyTorch Lightning verwenden, Laufzeiteinstellungen anpassen, effiziente Modelle und optimale Stapelgrößen verwenden. Diese Techniken tragen wesentlich dazu bei, dass die Deep-Learning-Modelle ihre beste Leistung erbringen und aus den verfügbaren Daten gültige Schlussfolgerungen und Schlussfolgerungen ziehen können. Wir haben die Techniken zur Steigerung der GPU-Auslastung demonstriert.