Dieser Leitfaden veranschaulicht den Prozess der Verwendung des Entity-Speichers in LangChain.

Wie verwende ich den Entitätsspeicher in LangChain?

Die Entität wird verwendet, um die Schlüsselfakten im Speicher zu speichern und zu extrahieren, wenn sie vom Menschen mithilfe der Abfragen/Eingabeaufforderungen gefragt werden. Um den Prozess der Verwendung des Entity-Speichers in LangChain zu erfahren, besuchen Sie einfach die folgende Anleitung:

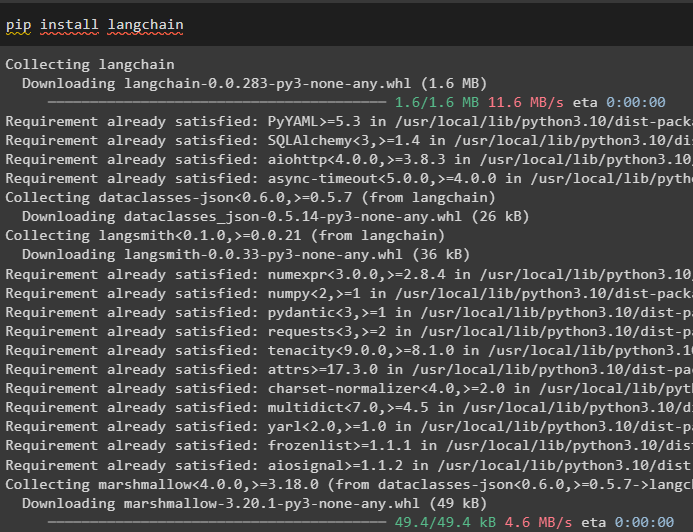

Schritt 1: Module installieren

Installieren Sie zunächst das LangChain-Modul mit dem Befehl pip, um seine Abhängigkeiten abzurufen:

pip langchain installieren

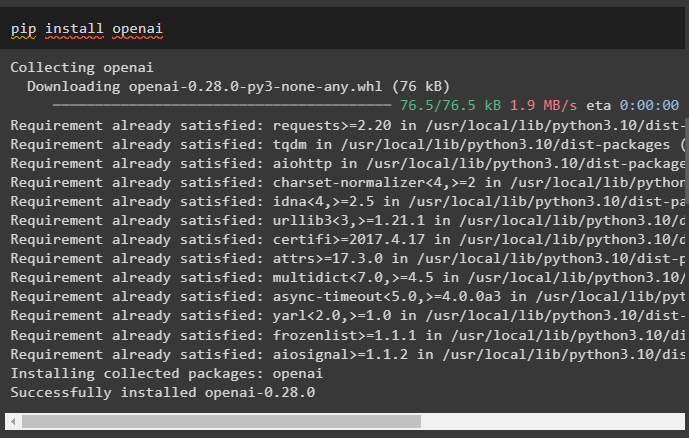

Installieren Sie anschließend das OpenAI-Modul, um seine Bibliotheken zum Erstellen von LLMs und Chat-Modellen zu erhalten:

pip openai installieren

Richten Sie die OpenAI-Umgebung ein Verwenden des API-Schlüssels, der aus dem OpenAI-Konto extrahiert werden kann:

importieren Du

importieren getpass

Du . etwa [ „OPENAI_API_KEY“ ] = getpass . getpass ( „OpenAI-API-Schlüssel:“ )

Schritt 2: Entitätsspeicher verwenden

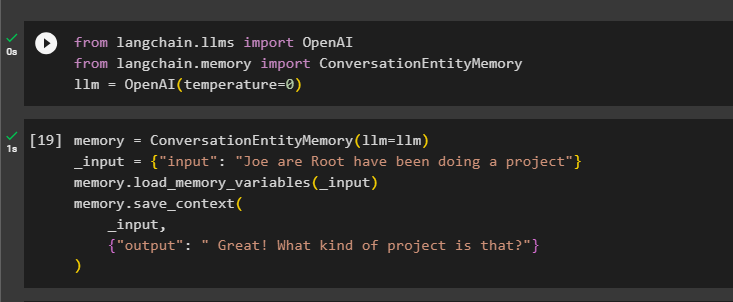

Um den Entitätsspeicher zu verwenden, importieren Sie die erforderlichen Bibliotheken zum Erstellen des LLM mithilfe der OpenAI()-Methode:

aus langchain. lms importieren OpenAIaus langchain. Erinnerung importieren ConversationEntityMemory

llm = OpenAI ( Temperatur = 0 )

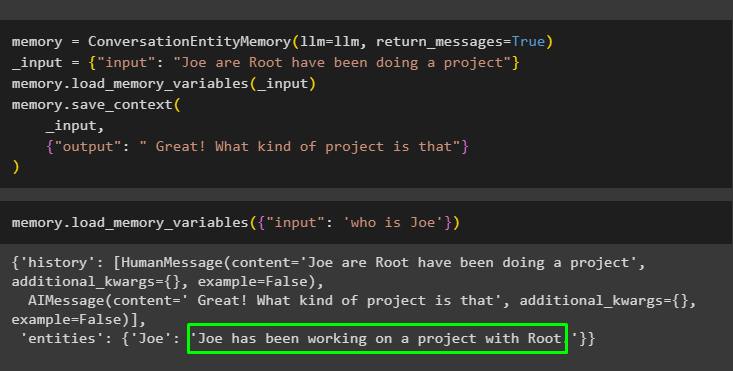

Danach definieren Sie die Erinnerung Variable mithilfe der ConversationEntityMemory()-Methode, um das Modell mithilfe der Eingabe- und Ausgabevariablen zu trainieren:

Erinnerung = ConversationEntityMemory ( llm = llm )_Eingang = { 'Eingang' : „Joe are Root hat ein Projekt gemacht“ }

Erinnerung. Load_memory_variables ( _Eingang )

Erinnerung. save_context (

_Eingang ,

{ 'Ausgabe' : „Großartig! Was ist das denn für ein Projekt?“ }

)

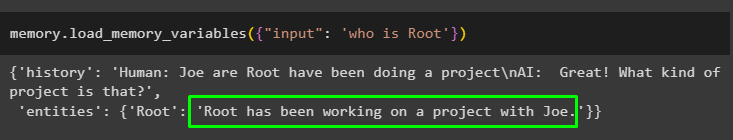

Testen Sie nun den Speicher mithilfe der Abfrage/Eingabeaufforderung im Eingang Variable durch Aufrufen der Methode „load_memory_variables()“:

Erinnerung. Load_memory_variables ( { 'Eingang' : „Wer ist Root?“ } )

Geben Sie nun einige weitere Informationen an, damit das Modell dem Speicher einige weitere Entitäten hinzufügen kann:

Erinnerung = ConversationEntityMemory ( llm = llm , return_messages = WAHR )_Eingang = { 'Eingang' : „Joe are Root hat ein Projekt gemacht“ }

Erinnerung. Load_memory_variables ( _Eingang )

Erinnerung. save_context (

_Eingang ,

{ 'Ausgabe' : „Super! Was ist das denn für ein Projekt?“ }

)

Führen Sie den folgenden Code aus, um die Ausgabe mithilfe der im Speicher gespeicherten Entitäten zu erhalten. Es ist möglich durch die Eingang enthält die Eingabeaufforderung:

Erinnerung. Load_memory_variables ( { 'Eingang' : „Wer ist Joe?“ } )

Schritt 3: Entity Memory in einer Kette verwenden

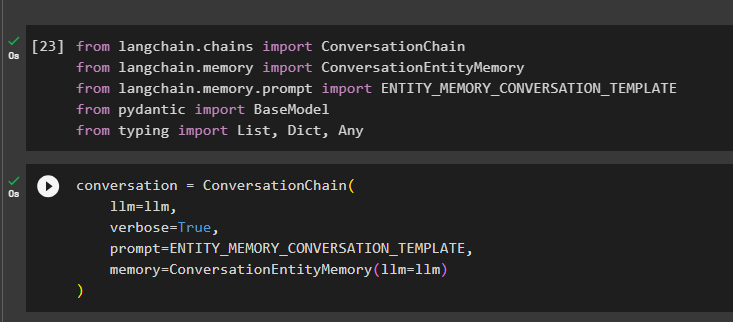

Um den Entity-Speicher nach dem Aufbau einer Kette zu nutzen, importieren Sie einfach die erforderlichen Bibliotheken mit dem folgenden Codeblock:

aus langchain. Ketten importieren Konversationsketteaus langchain. Erinnerung importieren ConversationEntityMemory

aus langchain. Erinnerung . prompt importieren ENTITY_MEMORY_CONVERSATION_TEMPLATE

aus pydantisch importieren Basismodell

aus Tippen importieren Aufführen , Diktat , Beliebig

Erstellen Sie das Konversationsmodell mit der ConversationChain()-Methode und verwenden Sie Argumente wie llm:

Gespräch = Konversationskette (llm = llm ,

ausführlich = WAHR ,

prompt = ENTITY_MEMORY_CONVERSATION_TEMPLATE ,

Erinnerung = ConversationEntityMemory ( llm = llm )

)

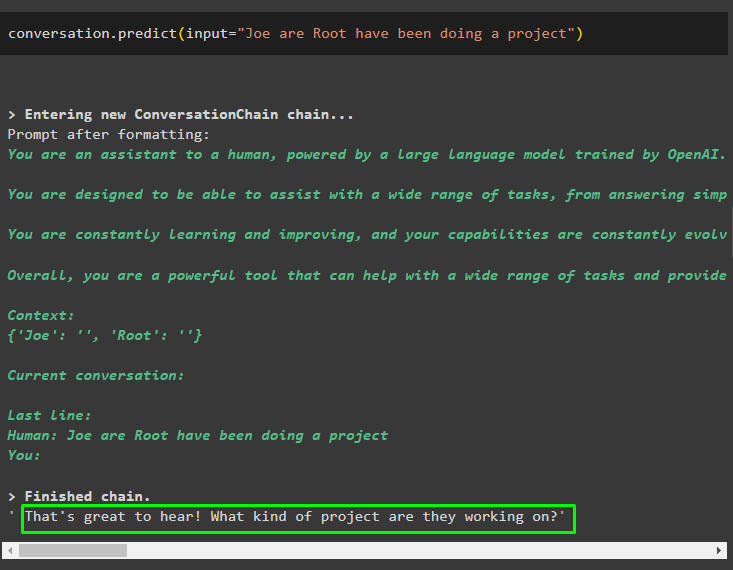

Rufen Sie die Methode „conversation.predict()“ mit der Eingabe auf, die mit der Eingabeaufforderung oder Abfrage initialisiert wurde:

Gespräch. vorhersagen ( Eingang = „Joe are Root hat ein Projekt gemacht“ )

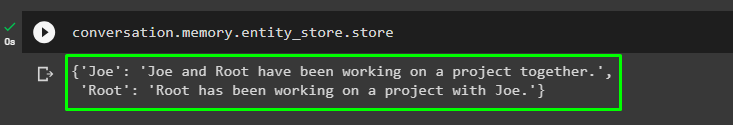

Rufen Sie nun die separate Ausgabe für jede Entität ab, die die Informationen darüber beschreibt:

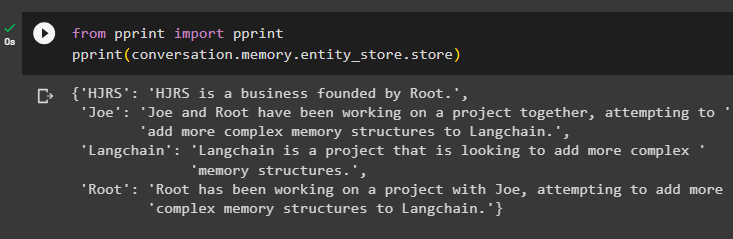

Gespräch. Erinnerung . Entity_Store . speichern

Verwenden Sie die Ausgabe des Modells als Eingabe, damit das Modell weitere Informationen zu diesen Entitäten speichern kann:

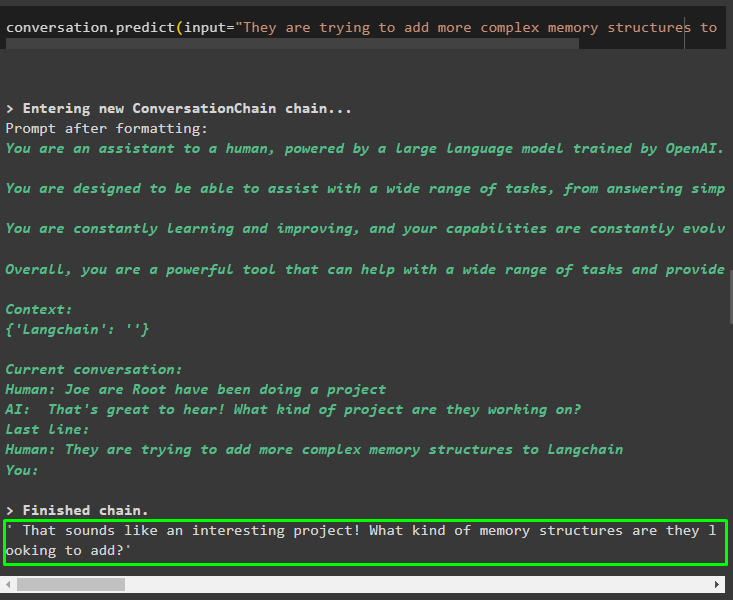

Gespräch. vorhersagen ( Eingang = „Sie versuchen, Langchain komplexere Speicherstrukturen hinzuzufügen“ )

Nachdem Sie die im Speicher gespeicherten Informationen angegeben haben, stellen Sie einfach die Frage, um die spezifischen Informationen über Entitäten zu extrahieren:

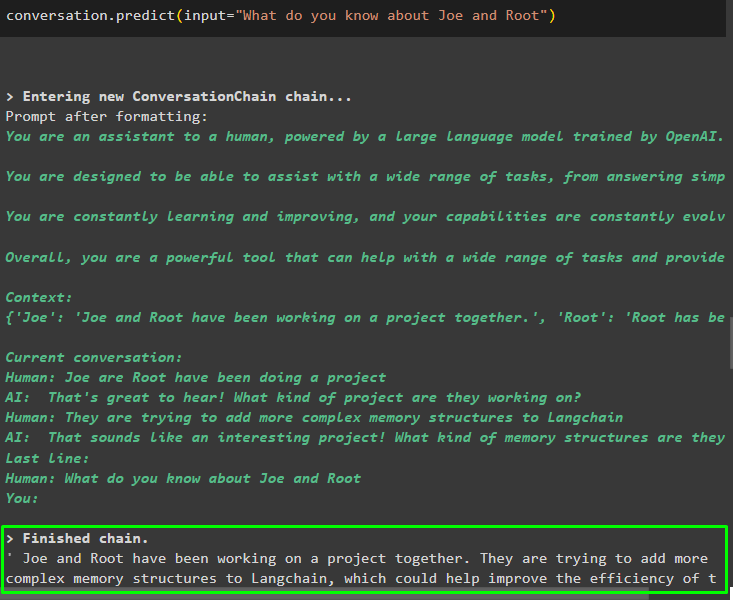

Gespräch. vorhersagen ( Eingang = „Was wissen Sie über Joe und Root?“ )

Schritt 4: Testen des Speichers

Mit dem folgenden Code kann der Benutzer die Speicher direkt überprüfen, um die darin gespeicherten Informationen abzurufen:

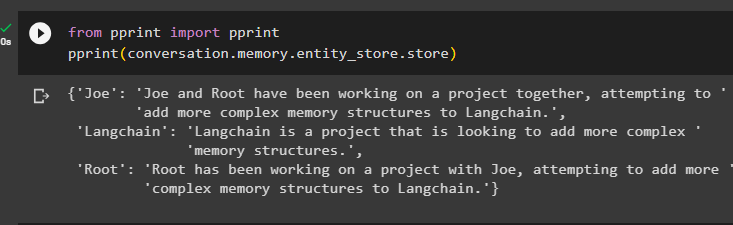

aus drucken importieren druckendrucken ( Gespräch. Erinnerung . Entity_Store . speichern )

Stellen Sie mehr Informationen zur Verfügung, die im Speicher gespeichert werden sollen, da mehr Informationen zu genaueren Ergebnissen führen:

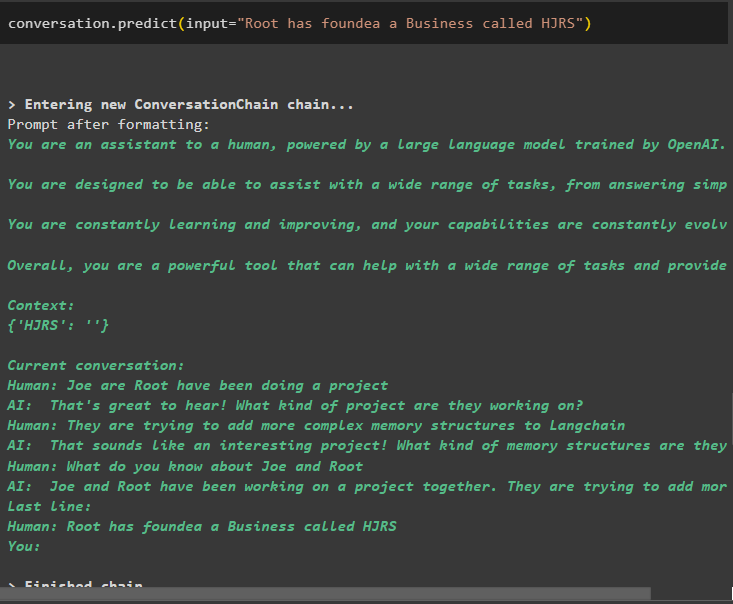

Gespräch. vorhersagen ( Eingang = „Root hat ein Unternehmen namens HJRS gegründet“ )

Extrahieren Sie Informationen aus dem Speicher, nachdem Sie weitere Informationen zu den Entitäten hinzugefügt haben:

aus drucken importieren druckendrucken ( Gespräch. Erinnerung . Entity_Store . speichern )

Der Speicher enthält Informationen über mehrere Entitäten wie HJRS, Joe, LangChain und Root:

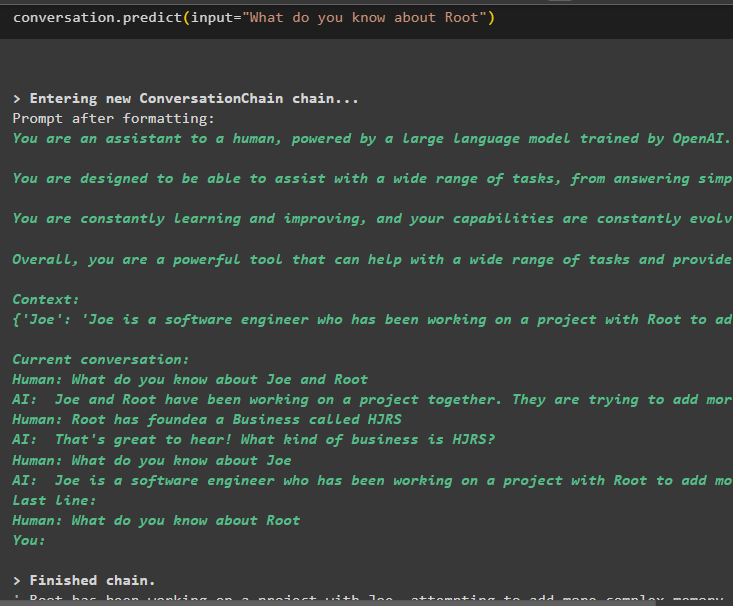

Extrahieren Sie nun Informationen zu einer bestimmten Entität mithilfe der in der Eingabevariablen definierten Abfrage oder Eingabeaufforderung:

Gespräch. vorhersagen ( Eingang = „Was wissen Sie über Root?“ )

Dabei geht es um die Nutzung des Entity-Speichers mithilfe des LangChain-Frameworks.

Abschluss

Um den Entitätsspeicher in LangChain zu nutzen, installieren Sie nach dem Einrichten der OpenAI-Umgebung einfach die erforderlichen Module, um die zum Erstellen von Modellen erforderlichen Bibliotheken zu importieren. Erstellen Sie anschließend das LLM-Modell und speichern Sie Entitäten im Speicher, indem Sie Informationen über die Entitäten bereitstellen. Der Benutzer kann mithilfe dieser Entitäten auch Informationen extrahieren und diese Erinnerungen in den Ketten mit gerührten Informationen über Entitäten aufbauen. In diesem Beitrag wurde der Prozess der Verwendung des Entitätsspeichers in LangChain näher erläutert.