In diesem Blog gehen wir auf zwei Methoden zum Importieren eines vorab trainierten Modells in PyTorch ein.

Wie importiere ich mit Torchvision ein vorab trainiertes Modell in PyTorch?

Der ' Fackelvision Die Bibliothek kann zum Importieren vorab trainierter Modelle in PyTorch verwendet werden. Es ist eine Unterteilung des primären „ Fackel ”-Bibliothek und enthält die Funktionalität zuvor zusammengestellter Datensätze und trainierter Modelle. Diese Bibliothek bietet Benutzern die Möglichkeit, Modelle aufzurufen, die anhand eines großen Datensatzes trainiert wurden. Diese vorab trainierten Modelle können auf neue Daten angewendet werden und gültige Schlussfolgerungen liefern, ohne dass lange und unüberschaubare Trainingsschleifen erforderlich sind.

Befolgen Sie die folgenden Schritte, um zu erfahren, wie Sie mit Torchvision ein vorab trainiertes Modell in PyTorch importieren:

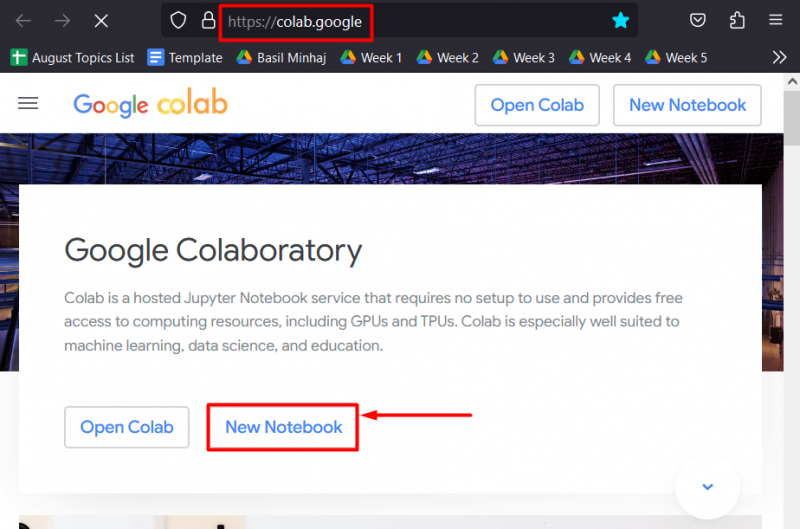

Schritt 1: Öffnen Sie Google Colab

Gehen Sie zum Colaboratory Webseite erstellt von Google und starten Sie ein „ Neues Notizbuch ” um das Projekt zu beginnen:

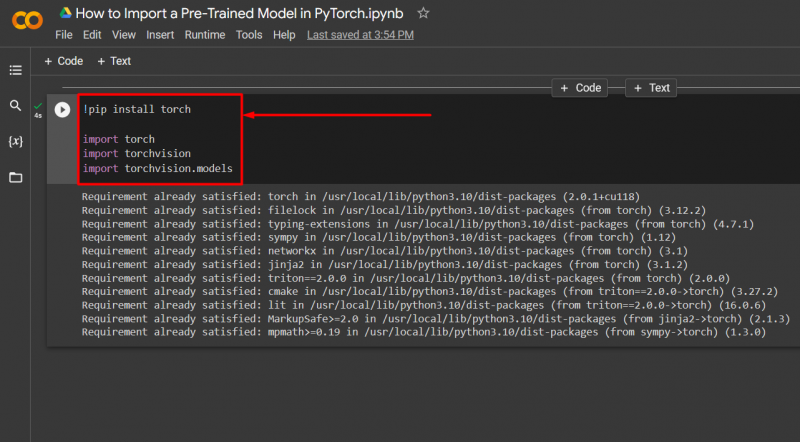

Schritt 2: Erforderliche Bibliotheken importieren

Sobald die Colab-IDE eingerichtet ist, besteht der erste Schritt darin, die im Projekt benötigten Bibliotheken zu installieren und zu importieren:

importieren Fackel

importieren Fackelvision

importieren Fackelvision. Modelle

Der obige Code funktioniert wie folgt:

- Der ' Pip ”-Paketinstallationsprogramm für Python wird verwendet, um das „ Fackel ' Bibliothek.

- Als nächstes wird das „ importieren Der Befehl „wird zum Importieren der Bibliothek in das Colab-Projekt verwendet.

- Dann ist die ' Fackelvision Die Bibliothek wird in das Projekt importiert. Darin sind Funktionen für Datensätze und Modelle enthalten.

- Der ' Torchvision.Modell „Das Modul enthält eine Auswahl vorab trainierter Modelle wie die des Residual Neural Network“ ResNet ”:

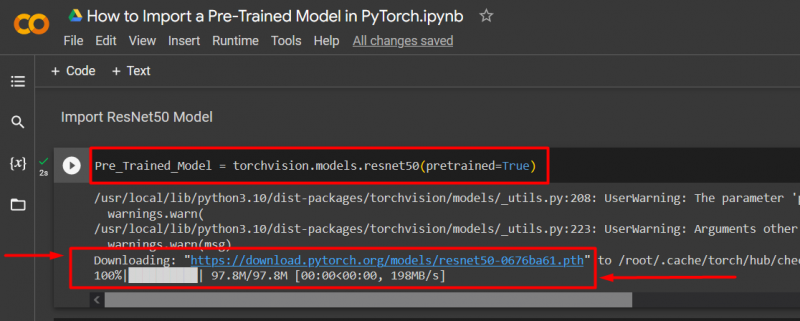

Schritt 3: Vorab trainiertes Modell importieren

Importieren Sie ein vorab trainiertes Modell, das im Paket „torchvision.models“ gespeichert ist, mit der folgenden Codezeile:

Die obige Codezeile funktioniert wie folgt:

- Definieren Sie eine Variable und geben Sie ihr einen geeigneten Namen als Referenz, z „Pre_Trained_Model“ .

- Benutzen Sie die „torchvision.models“ Modul zum Hinzufügen des „ ResNet ' Modell.

- Ergänzen Sie die ' ernst50 ”-Modell und stellen Sie das „ vortrainiert=Wahr ” als Argument:

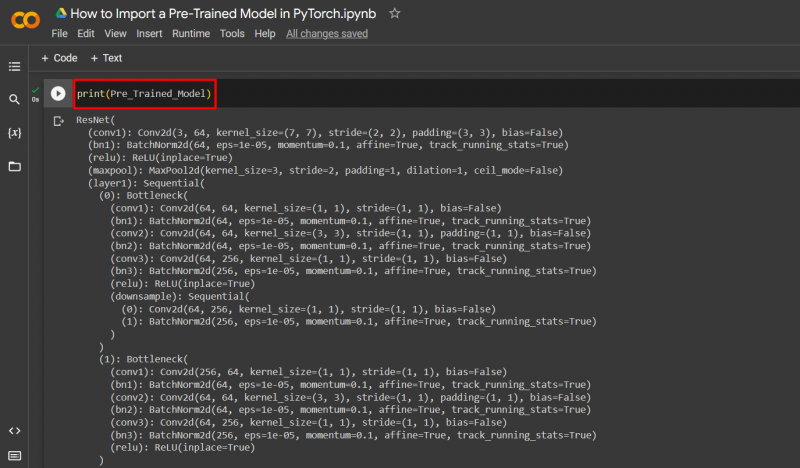

Betrachten Sie als Nächstes das vorab trainierte Modell als Ausgabe mit der Methode „print()“:

drucken ( Vorab trainiertes_Modell )

Notiz : Hier können Sie auf unser Colab-Notizbuch zugreifen, das den Import eines vorab trainierten PyTorch-Modells mit Torchvision detailliert beschreibt Verknüpfung .

Wie importiere ich ein vorab trainiertes PyTorch-Modell aus der Hugging Face-Datenbank?

Eine andere Methode zum Importieren eines vorab trainierten Modells besteht darin, es von der Hugging Face-Plattform abzurufen. Hugging Face ist eine der beliebtesten Online-Datenbanken für vorab trainierte Modelle und große Datensätze, die Datenwissenschaftlern und Programmierern zur Verfügung steht.

Führen Sie die folgenden Schritte aus, um ein vorab trainiertes PyTorch-Modell aus dem Hugging Face-Datensatz zu importieren:

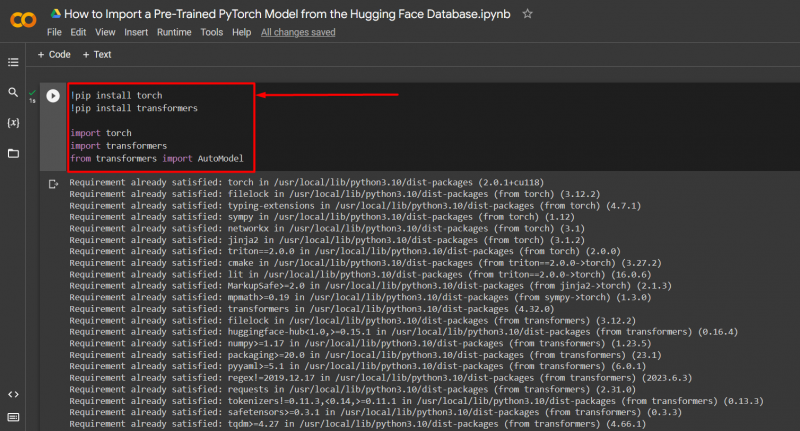

Schritt 1: Starten Sie ein Colab-Notebook und installieren und importieren Sie die erforderlichen Bibliotheken

Der erste Schritt besteht darin, ein Notebook in der Colab-IDE zu starten und Bibliotheken mit dem Befehl „ Pip ”-Paketinstallationsprogramm und importieren Sie sie mit dem „ importieren ' Befehl:

! Pip-Transformatoren installieren

importieren Fackel

importieren Transformer

von Transformatoren importieren AutoModell

Die folgenden Bibliotheken werden in diesem Projekt benötigt

- Der ' Fackel „Bibliothek ist die wesentliche PyTorch-Bibliothek.

- Der ' Transformer Die Bibliothek enthält die Funktionalität von Hugging Face, seine Modelle und seine Datensätze:

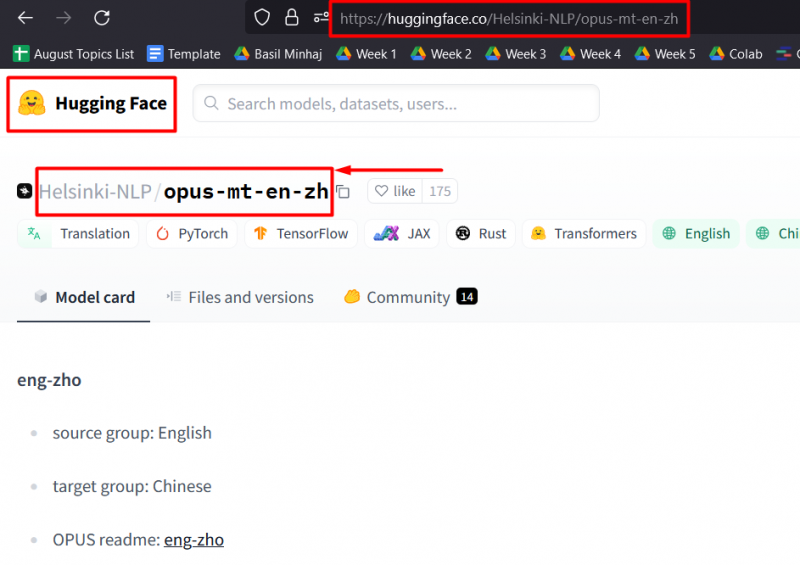

Schritt 2: Importieren Sie das Modell aus Hugging Face

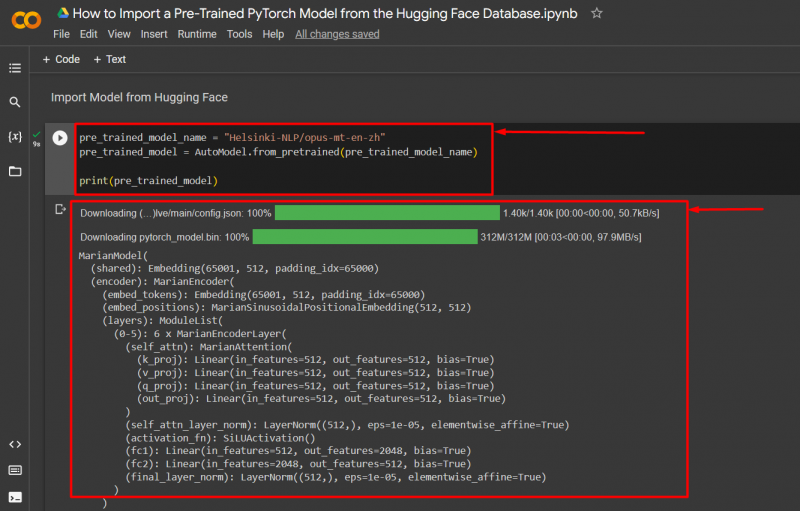

In diesem Beispiel ist das zu importierende Modell aus der „ Umarmendes Gesicht Die Datenbank ist hier verfügbar Verknüpfung . Benutzen Sie die „ AutoModel.from_pretrained() ”-Methode zum Importieren eines vorab trainierten Modells aus Hugging Face, wie unten gezeigt:

pre_trained_model = AutoModell. from_pretrained ( pre_trained_model_name )

drucken ( pre_trained_model )

Der obige Code funktioniert wie folgt:

- Kopieren Sie den Modellnamen von seiner Website auf der Hugging Face-Plattform und weisen Sie ihn dem „ pre_trained_model_name ”-Variable in Colab.

- Verwenden Sie dann die „ AutoModel.from_pretrained() ”-Methode und geben Sie die Modellnamenvariable als Argument ein.

- Zuletzt verwenden Sie die 'drucken() ”-Methode, um das importierte Modell in der Ausgabe anzuzeigen.

Das aus Hugging Face importierte vorab trainierte Modell zeigt die folgende Ausgabe:

Notiz : Hier können Sie auf unser Colab-Notizbuch zugreifen, in dem detailliert beschrieben wird, wie Sie ein vorab trainiertes Modell aus Hugging Face importieren Verknüpfung .

Profi-Tipp

Hugging Face ist eine wertvolle Sammlung großer Datensätze und komplexer Modelle, die jeder kostenlos in Deep-Learning-Projekten verwenden kann. Sie können auch Ihre eigenen Datensätze hochladen, damit andere sie nutzen können. Die Plattform ist auf die Zusammenarbeit zwischen Datenwissenschaftlern und Entwicklern auf der ganzen Welt abgestimmt.

Erfolg! Wir haben gezeigt, wie man ein vorab trainiertes PyTorch-Modell mithilfe der Torchvision-Bibliothek oder aus der Hugging Face-Datenbank mithilfe der Transformers-Bibliothek importiert.

Abschluss

Um ein vorab trainiertes Modell in PyTorch zu importieren, können Benutzer entweder die Torchvision-Bibliothek oder die Online-Datenbank Hugging Face mithilfe der Transformers-Bibliothek in Google Colab verwenden. Diese vorab trainierten Modelle werden verwendet, um zu vermeiden, dass wertvolle Zeit und Hardwareressourcen für das Training aufgewendet werden, und um direkt mit dem Testen neuer Daten auf glaubwürdige Schlussfolgerungen fortzufahren. In diesem Blog haben wir zwei Methoden zum Importieren vorab trainierter Modelle in PyTorch gezeigt.