Dieser Leitfaden veranschaulicht den Prozess der Verwendung des Konversationswissensgraphen in LangChain.

Wie verwende ich den Conversation Knowledge Graph in LangChain?

Der KonversationKGMemory Die Bibliothek kann verwendet werden, um den Speicher wiederherzustellen, der zum Abrufen des Kontexts der Interaktion verwendet werden kann. Um den Prozess der Verwendung des Konversationswissensdiagramms in LangChain zu erlernen, führen Sie einfach die aufgeführten Schritte aus:

Schritt 1: Module installieren

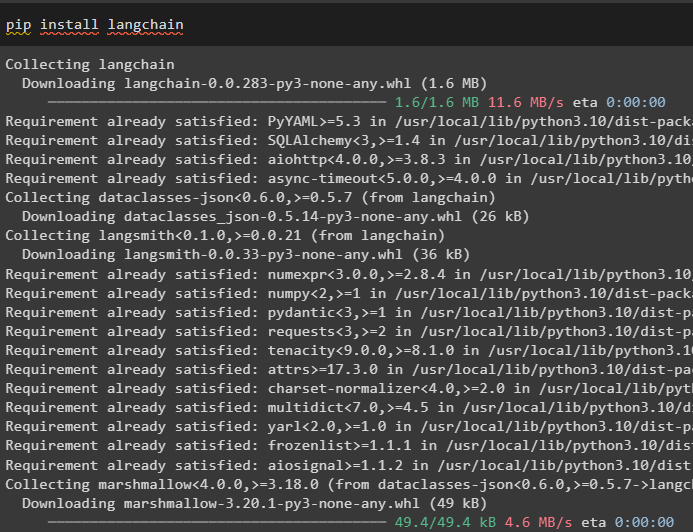

Beginnen Sie zunächst mit der Verwendung des Konversationswissensgraphen, indem Sie das LangChain-Modul installieren:

pip langchain installieren

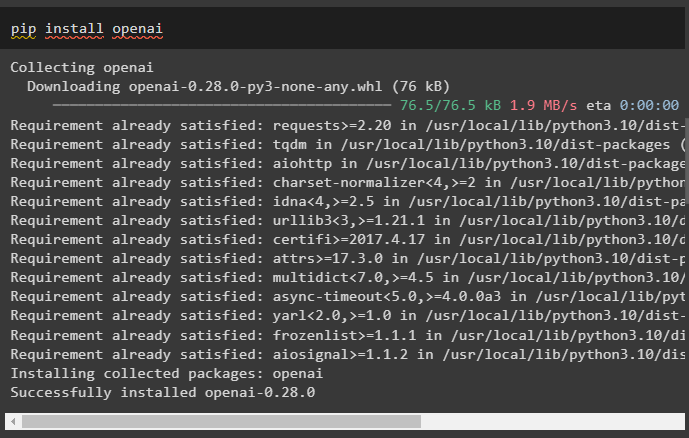

Installieren Sie das OpenAI-Modul, das mit dem Befehl pip installiert werden kann, um seine Bibliotheken zum Erstellen großer Sprachmodelle abzurufen:

pip openai installieren

Jetzt, Umgebung einrichten unter Verwendung des OpenAI-API-Schlüssels, der von seinem Konto generiert werden kann:

importieren Du

importieren getpass

Du . etwa [ „OPENAI_API_KEY“ ] = getpass . getpass ( „OpenAI-API-Schlüssel:“ )

Schritt 2: Speicher mit LLMs nutzen

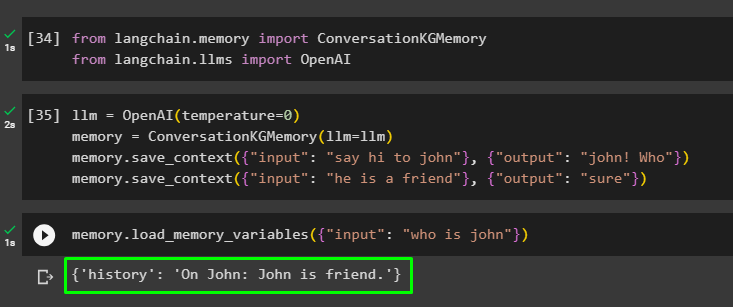

Sobald die Module installiert sind, beginnen Sie mit der Nutzung des Speichers mit LLM, indem Sie die erforderlichen Bibliotheken aus dem LangChain-Modul importieren:

aus langchain. Erinnerung importieren KonversationKGMemoryaus langchain. lms importieren OpenAI

Erstellen Sie das LLM mit der OpenAI()-Methode und konfigurieren Sie den Speicher mit der KonversationKGMemory () Methode. Speichern Sie anschließend die Eingabeaufforderungsvorlagen unter Verwendung mehrerer Eingaben mit ihrer jeweiligen Antwort, um das Modell anhand dieser Daten zu trainieren:

llm = OpenAI ( Temperatur = 0 )Erinnerung = KonversationKGMemory ( llm = llm )

Erinnerung. save_context ( { 'Eingang' : „Sag Hallo zu John“ } , { 'Ausgabe' : „John! Wer?“ } )

Erinnerung. save_context ( { 'Eingang' : 'Er ist ein Freund' } , { 'Ausgabe' : 'Sicher' } )

Testen Sie den Speicher, indem Sie die Datei laden Speichervariablen ()-Methode unter Verwendung der Abfrage, die sich auf die oben genannten Daten bezieht:

Erinnerung. Load_memory_variables ( { 'Eingang' : 'Wer ist John' } )

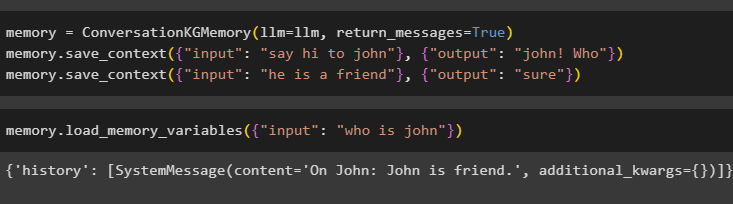

Konfigurieren Sie den Speicher mithilfe der Methode ConversationKGMemory() mit return_messages Argument, um auch den Verlauf der Eingabe abzurufen:

Erinnerung = KonversationKGMemory ( llm = llm , return_messages = WAHR )Erinnerung. save_context ( { 'Eingang' : „Sag Hallo zu John“ } , { 'Ausgabe' : „John! Wer?“ } )

Erinnerung. save_context ( { 'Eingang' : 'Er ist ein Freund' } , { 'Ausgabe' : 'Sicher' } )

Testen Sie einfach den Speicher, indem Sie dem Eingabeargument seinen Wert in Form einer Abfrage bereitstellen:

Erinnerung. Load_memory_variables ( { 'Eingang' : 'Wer ist John' } )

Testen Sie nun das Gedächtnis, indem Sie die Frage stellen, die in den Trainingsdaten nicht erwähnt wird und das Modell keine Ahnung von der Antwort hat:

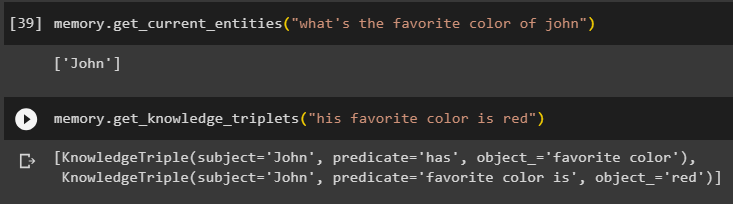

Erinnerung. get_current_entities ( „Was ist Johns Lieblingsfarbe?“ )Benutzen Sie die get_knowledge_triplets ()-Methode durch Beantwortung der zuvor gestellten Abfrage:

Erinnerung. get_knowledge_triplets ( „Seine Lieblingsfarbe ist Rot“ )

Schritt 3: Speicher in der Kette verwenden

Im nächsten Schritt wird der Konversationsspeicher mit den Ketten verwendet, um das LLM-Modell mithilfe der OpenAI()-Methode zu erstellen. Anschließend konfigurieren Sie die Eingabeaufforderungsvorlage mithilfe der Konversationsstruktur. Der Text wird angezeigt, während das Modell die Ausgabe erhält:

llm = OpenAI ( Temperatur = 0 )aus langchain. Aufforderungen . prompt importieren PromptTemplate

aus langchain. Ketten importieren Konversationskette

Vorlage = „“„Dies ist die Vorlage für die Interaktion zwischen Mensch und Maschine

Das System ist ein KI-Modell, das über mehrere Aspekte sprechen oder Informationen daraus extrahieren kann

Wenn es die Frage nicht versteht oder die Antwort nicht hat, sagt es es einfach

Das System extrahiert die im Abschnitt „Spezifisch“ gespeicherten Daten und erzeugt keine Halluzinationen

Spezifisch:

{Geschichte}

Gespräch:

Mensch: {input}

KI:'''

#Konfigurieren Sie die Vorlage oder Struktur, um Eingabeaufforderungen bereitzustellen und Antworten vom KI-System zu erhalten

prompt = PromptTemplate ( Eingabevariablen = [ 'Geschichte' , 'Eingang' ] , Vorlage = Vorlage )

Konversation_mit_kg = Konversationskette (

llm = llm , ausführlich = WAHR , prompt = prompt , Erinnerung = KonversationKGMemory ( llm = llm )

)

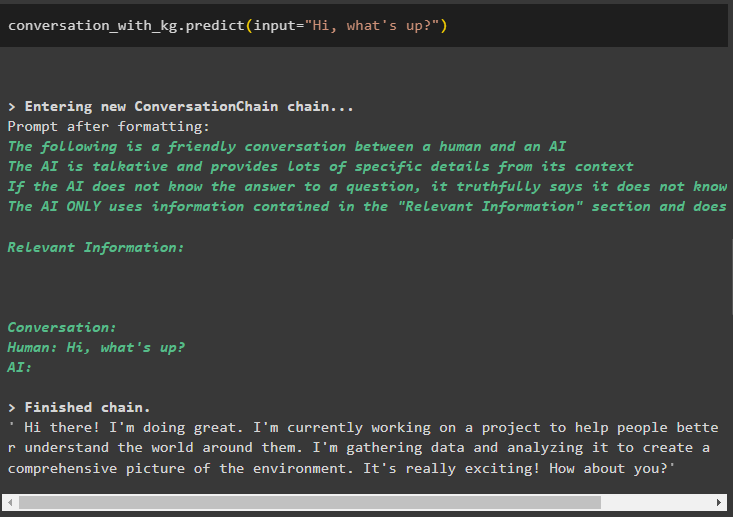

Sobald das Modell erstellt ist, rufen Sie einfach auf Konversation_mit_kg Modell mithilfe der Predict()-Methode mit der vom Benutzer gestellten Abfrage:

Konversation_mit_kg. vorhersagen ( Eingang = 'Hi was geht?' )

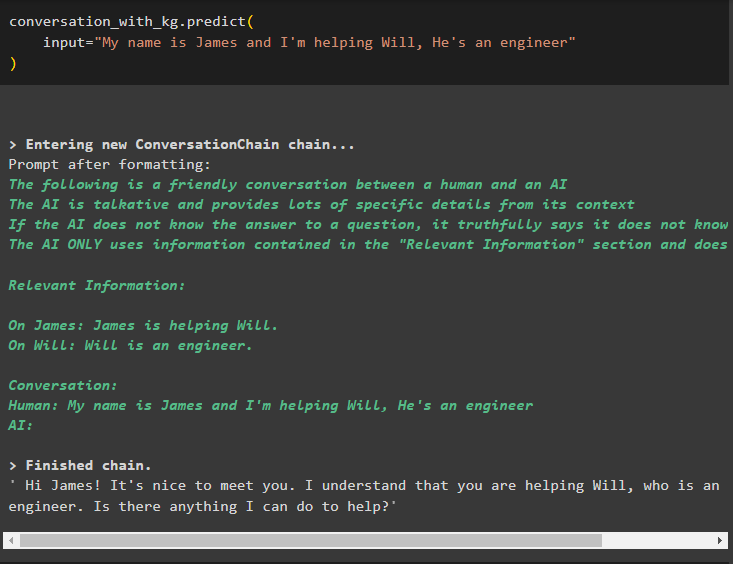

Trainieren Sie nun das Modell mithilfe des Konversationsgedächtnisses, indem Sie die Informationen als Eingabeargument für die Methode angeben:

Konversation_mit_kg. vorhersagen (Eingang = „Mein Name ist James und ich helfe Will, er ist Ingenieur“

)

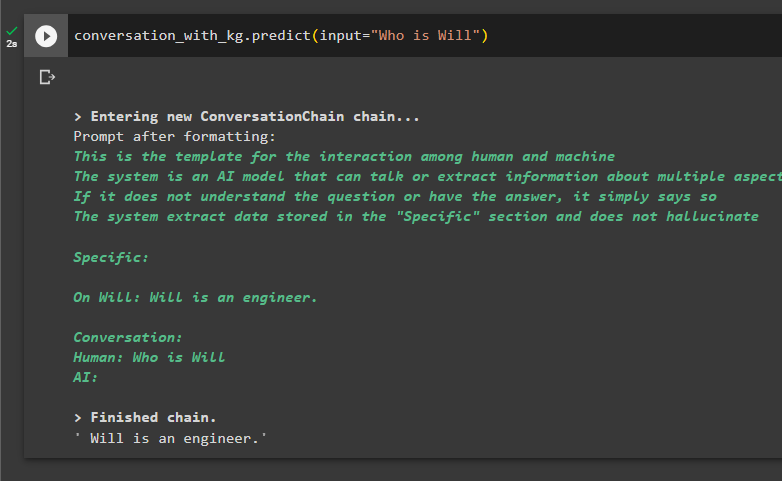

Jetzt ist es an der Zeit, das Modell zu testen, indem Sie die Abfragen auffordern, Informationen aus den Daten zu extrahieren:

Konversation_mit_kg. vorhersagen ( Eingang = „Wer ist Will“ )

Dabei geht es um die Verwendung des Konversationswissensgraphen in LangChain.

Abschluss

Um den Konversationswissensgraphen in LangChain zu verwenden, installieren Sie die Module oder Frameworks, um Bibliotheken für die Verwendung der ConversationKGMemory()-Methode zu importieren. Erstellen Sie anschließend das Modell mithilfe des Speichers, um die Ketten aufzubauen und Informationen aus den in der Konfiguration bereitgestellten Trainingsdaten zu extrahieren. In diesem Leitfaden wurde der Prozess der Verwendung des Konversationswissensdiagramms in LangChain erläutert.