Large Language Models oder LLMs sind leistungsstarke neuronale Netzwerkalgorithmen zum Erstellen von Chatbots, die Daten mithilfe von Befehlen in natürlichen Sprachen abrufen. LLMs ermöglichen es Maschinen/Computern, natürliche Sprache besser zu verstehen und Sprache wie Menschen zu erzeugen. Das LangChain-Modul eignet sich auch zum Erstellen von NLP-Modellen. Allerdings verfügt es nicht über ein eigenes LLM, ermöglicht aber die Interaktion mit vielen verschiedenen LLMs.

In diesem Leitfaden wird der Prozess der Interaktion mit großen Sprachmodellen mithilfe von LangChain erläutert.

Wie interagiere ich mit LLMs mithilfe von LangChain?

Um mit LLMs über LangChain zu interagieren, befolgen Sie einfach diese einfache Schritt-für-Schritt-Anleitung mit Beispielen:

Installieren Sie Module zur Interaktion mit LLMs

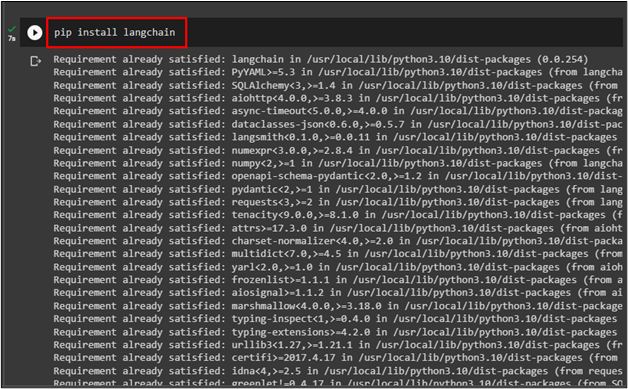

Bevor Sie mit der Interaktion mit LLMs mithilfe von LangChain beginnen, installieren Sie „ langchain ”-Modul mit dem folgenden Code:

Pip Installieren langchain

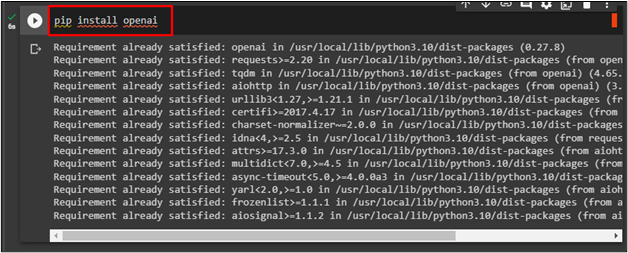

Um das OpenAI-Framework zu installieren, verwenden Sie seinen API-Schlüssel für die Interaktion mit LLMs über den folgenden Code:

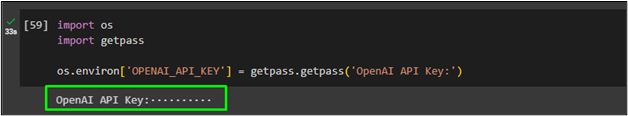

Importieren Sie nun „ Du ' Und ' getpass ” um den OpenAI-API-Schlüssel nach der Ausführung des Codes zu verwenden:

Importieren Sie uns

getpass importieren

os.environ [ 'OPENAI_API_KEY' ] = getpass.getpass ( „OpenAI-API-Schlüssel:“ )

Ich rufe LLM an

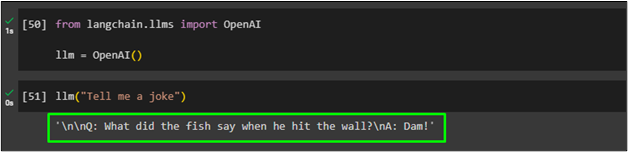

Importieren Sie die OpenAI-Bibliothek aus dem LangChain-Modul, um ihre Funktion dem „zuzuweisen“ llm ” Variable:

aus langchain.llms OpenAI importierenllm = OpenAI ( )

Rufen Sie danach einfach „ llm ”-Funktion und die Eingabeaufforderungsabfrage als Parameter:

Generieren Sie mehrere Texte mithilfe von LLMs

Verwenden Sie die Methode „generate()“ mit mehreren Eingabeaufforderungen in natürlicher Sprache, um den Text aus LLM zu generieren und ihn im „ llm_result ” Variable:

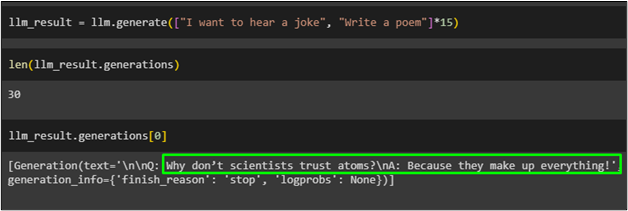

llm_result = llm.generate ( [ „Ich möchte einen Witz hören“ , 'Ein Gedicht schreiben' ] * fünfzehn )

Ermitteln Sie die Länge der im „ llm_result ” Variable mit der Funktion „generate()“:

Rufen Sie einfach die Variable mit der Indexnummer der Objekte auf:

Der folgende Screenshot zeigt den im Ordner „ llm_result ”-Variable an ihrem 0-Index, die den Witz erzeugt:

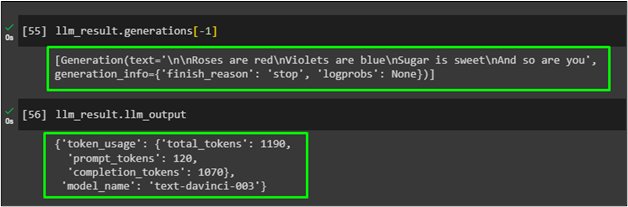

Verwenden Sie die Methode generations() mit dem Indexparameter -1, um das in der Variablen llm_result platzierte Gedicht zu generieren:

Zeigen Sie einfach die generierte Ausgabe in der Ergebnisvariablen an, um die anbieterspezifischen Informationen zu erhalten, die im vorherigen LLM mithilfe der generierten Funktion generiert wurden:

Dabei geht es um die Interaktion mit LLMs unter Verwendung des LangChain-Frameworks zur Generierung natürlicher Sprache.

Abschluss

Um mit großen Sprachmodellen mithilfe von LangChain zu interagieren, installieren Sie einfach Frameworks wie LangChain und OpenAI, um Bibliotheken für LLMs zu importieren. Geben Sie anschließend den OpenAI-API-Schlüssel an, der als LLMs zum Verstehen oder Generieren der natürlichen Sprache verwendet werden soll. Verwenden Sie das LLM für die Eingabeaufforderung in natürlicher Sprache und rufen Sie es dann auf, um Text basierend auf dem Befehl zu generieren. In diesem Leitfaden wurde der Prozess der Interaktion mit den großen Sprachmodellen mithilfe von LangChain-Modulen erläutert.