Kurzer Überblick

In diesem Beitrag wird Folgendes demonstriert:

- So greifen Sie auf die Zwischenschritte eines Agenten in LangChain zu

- Frameworks installieren

- Einrichten der OpenAI-Umgebung

- Bibliotheken importieren

- Aufbau von LLM und Agent

- Verwendung des Agenten

- Methode 1: Standardrückgabetyp für den Zugriff auf die Zwischenschritte

- Methode 2: Verwenden von „Dumps“ für den Zugriff auf die Zwischenschritte

- Abschluss

Wie greife ich auf die Zwischenschritte eines Agenten in LangChain zu?

Um den Agenten in LangChain zu erstellen, muss der Benutzer seine Tools und die Struktur der Vorlage konfigurieren, um die Anzahl der im Modell enthaltenen Schritte zu ermitteln. Der Agent ist für die Automatisierung der Zwischenschritte wie Gedanken, Handlungen, Beobachtungen usw. verantwortlich. Um zu erfahren, wie Sie auf die Zwischenschritte eines Agenten in der LangChain zugreifen, befolgen Sie einfach die aufgeführten Schritte:

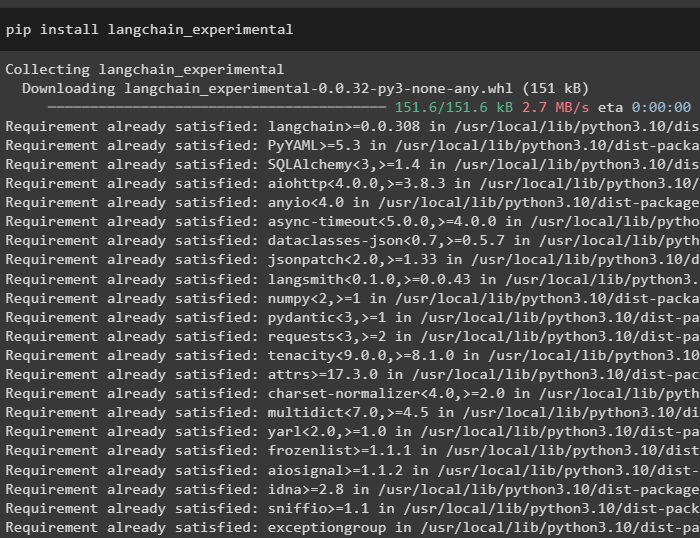

Schritt 1: Frameworks installieren

Installieren Sie zunächst einfach die Abhängigkeiten der LangChain, indem Sie den folgenden Code im Python Notebook ausführen:

pip install langchain_experimental

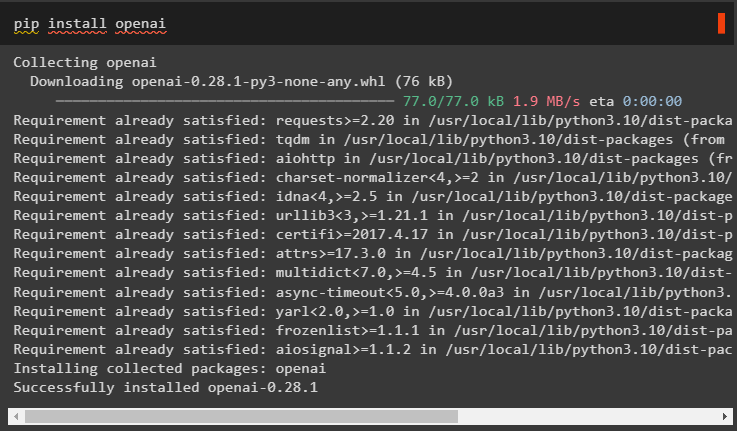

Installieren Sie das OpenAI-Modul, um seine Abhängigkeiten mithilfe von abzurufen Pip Befehl und verwenden Sie sie, um das Sprachmodell zu erstellen:

pip openai installieren

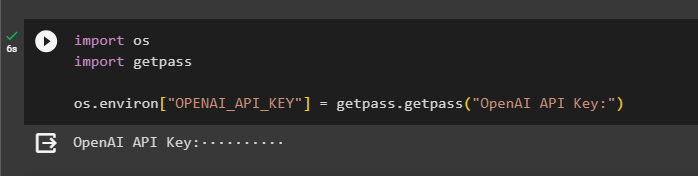

Schritt 2: OpenAI-Umgebung einrichten

Sobald die Module installiert sind, richten Sie die ein OpenAI-Umgebung Verwenden des von seinem Konto generierten API-Schlüssels:

importieren Du

importieren getpass

Du. etwa [ „OPENAI_API_KEY“ ] = getpass. getpass ( „OpenAI-API-Schlüssel:“ )

Schritt 3: Bibliotheken importieren

Nachdem wir nun die Abhängigkeiten installiert haben, verwenden Sie sie, um Bibliotheken aus der LangChain zu importieren:

von langchain. Agenten importieren Load_toolsvon langchain. Agenten importieren initialize_agent

von langchain. Agenten importieren AgentType

von langchain. lms importieren OpenAI

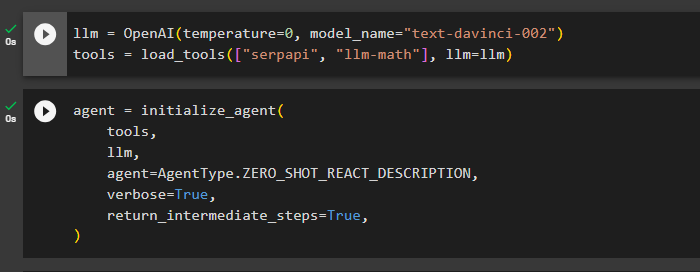

Schritt 4: LLM und Agent erstellen

Sobald die Bibliotheken importiert sind, ist es an der Zeit, sie zum Erstellen des Sprachmodells und der Tools für den Agenten zu verwenden. Definieren Sie die Variable llm und weisen Sie sie mit der Methode OpenAI() zu, die die Argumente Temperatur und Modellname enthält. Der ' Werkzeuge Die Variable „enthält die Methode „load_tools()“ mit den Tools „SerpAPi“ und „llm-math“ sowie das Sprachmodell in ihrem Argument:

llm = OpenAI ( Temperatur = 0 , Modellname = „text-davinci-002“ )Werkzeuge = Load_tools ( [ „Serpapi“ , „llm-math“ ] , llm = llm )

Sobald das Sprachmodell und die Tools konfiguriert sind, entwerfen Sie einfach den Agenten, um die Zwischenschritte mithilfe der Tools im Sprachmodell auszuführen:

Agent = initialize_agent (Werkzeuge ,

llm ,

Agent = AgentType. ZERO_SHOT_REACT_DESCRIPTION ,

ausführlich = WAHR ,

return_intermediate_steps = WAHR ,

)

Schritt 5: Verwendung des Agenten

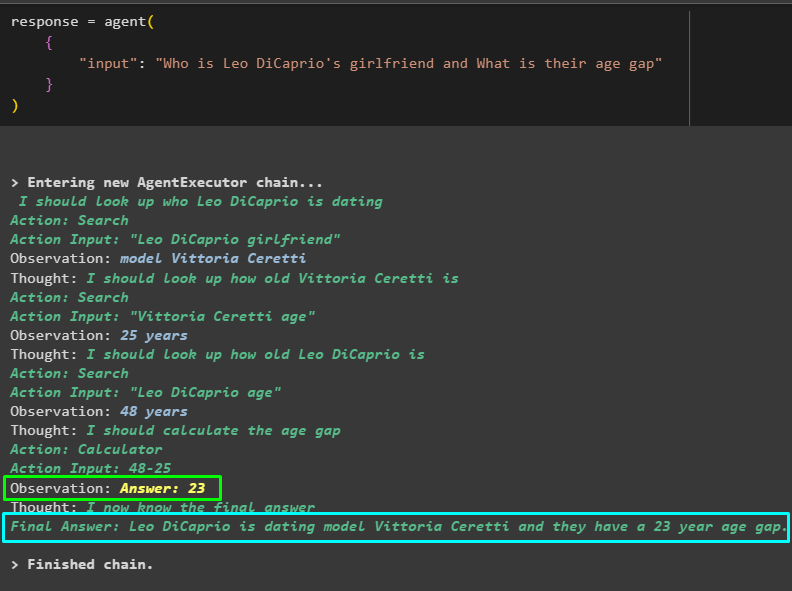

Stellen Sie nun den Agenten auf die Probe, indem Sie in der Eingabe der Methode agent() eine Frage stellen und diese ausführen:

Antwort = Agent ({

'Eingang' : „Wer ist Leo DiCaprios Freundin und wie groß ist ihr Altersunterschied?“

}

)

Das Model hat effizient daran gearbeitet, den Namen von Leo DiCaprios Freundin, ihr Alter, das Alter von Leo DiCaprio und den Unterschied zwischen ihnen herauszufinden. Der folgende Screenshot zeigt mehrere Fragen und Antworten, nach denen der Agent gesucht hat, um zur endgültigen Antwort zu gelangen:

Der obige Screenshot zeigt nicht die Arbeitsweise des Agenten und wie er dazu gelangt, alle Antworten zu finden. Fahren wir mit dem nächsten Abschnitt fort, um die Schritte zu finden:

Methode 1: Standardrückgabetyp für den Zugriff auf die Zwischenschritte

Die erste Methode, um auf den Zwischenschritt zuzugreifen, besteht darin, den von LangChain angebotenen Standardrückgabetyp mit dem folgenden Code zu verwenden:

drucken ( Antwort [ „intermediate_steps“ ] )Das folgende GIF zeigt die Zwischenschritte in einer einzigen Zeile an, was hinsichtlich der Lesbarkeit nicht ganz gut ist:

Methode 2: Verwenden von „Dumps“ für den Zugriff auf die Zwischenschritte

Die nächste Methode erläutert eine weitere Möglichkeit, die Zwischenschritte mithilfe der Dump-Bibliothek aus dem LangChain-Framework abzurufen. Verwenden Sie die dumps()-Methode mit dem hübschen Argument, um die Ausgabe strukturierter und leichter lesbar zu machen:

von langchain. Belastung . entsorgen importieren Mülldeponiendrucken ( Mülldeponien ( Antwort [ „intermediate_steps“ ] , hübsch = WAHR ) )

Jetzt haben wir die Ausgabe in einer strukturierteren Form, die für den Benutzer leicht lesbar ist. Außerdem ist es aus Gründen der Übersichtlichkeit in mehrere Abschnitte unterteilt und jeder Abschnitt enthält die Schritte, um Antworten auf die Fragen zu finden:

Dabei geht es um den Zugriff auf die Zwischenschritte eines Agenten in LangChain.

Abschluss

Um auf die Zwischenschritte eines Agenten in LangChain zuzugreifen, installieren Sie die Module zum Importieren von Bibliotheken zum Erstellen von Sprachmodellen. Anschließend richten Sie Tools ein, um den Agenten mithilfe der Tools, des LLM und des Agententyps zu initialisieren, der die Fragen beantworten kann. Sobald der Agent konfiguriert ist, testen Sie ihn, um die Antworten zu erhalten, und verwenden Sie dann den Standardtyp oder die Dumps-Bibliothek, um auf die Zwischenschritte zuzugreifen. In diesem Leitfaden wurde der Prozess des Zugriffs auf die Zwischenschritte eines Agenten in LangChain erläutert.