Dieser Leitfaden veranschaulicht den Prozess der Ausführung von LLMChains in LangChain.

Wie führt man LLMChains in LangChain aus?

LangChain bietet die Funktionen oder Abhängigkeiten zum Erstellen von LLMChains mithilfe der LLMs/Chatbots und Eingabeaufforderungsvorlagen. Um den Prozess zum Erstellen und Ausführen der LLMChains in LangChain zu erlernen, folgen Sie einfach der folgenden Schritt-für-Schritt-Anleitung:

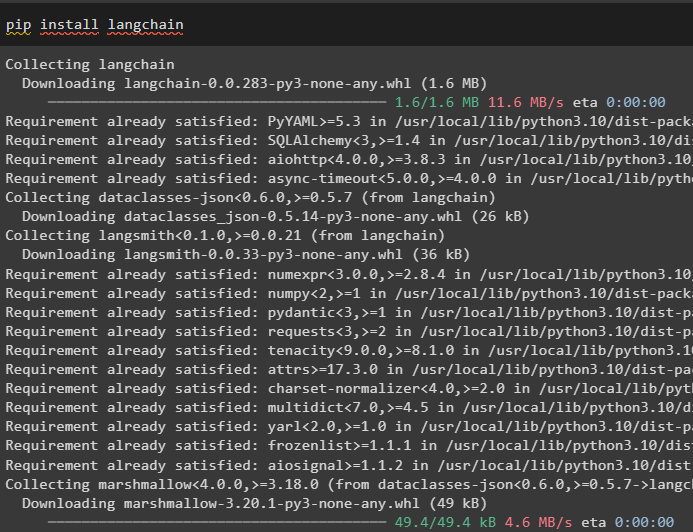

Schritt 1: Pakete installieren

Beginnen Sie zunächst mit dem Prozess, indem Sie das LangChain-Modul installieren, um seine Abhängigkeiten zum Erstellen und Ausführen von LLMChains zu erhalten:

pip langchain installieren

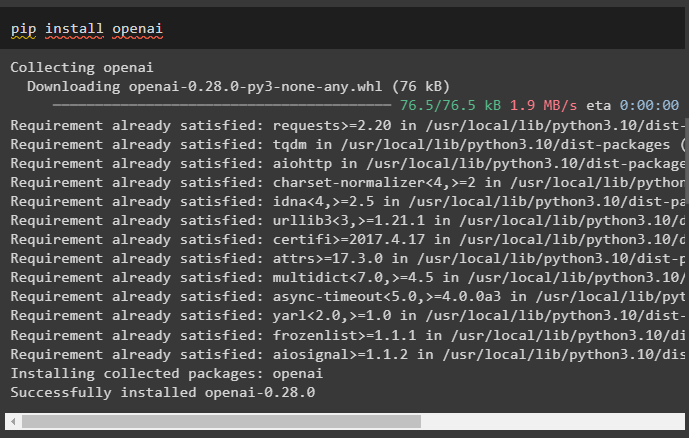

Installieren Sie das OpenAI-Framework mit dem Befehl pip, um die Bibliotheken dazu zu bringen, die OpenAI()-Funktion zum Erstellen von LLMs zu verwenden:

pip openai installieren

Nach der Installation der Module einfach Umgebung einrichten Variablen mithilfe des API-Schlüssels aus dem OpenAI-Konto:

importieren Du

importieren getpass

Du . etwa [ „OPENAI_API_KEY“ ] = getpass . getpass ( „OpenAI-API-Schlüssel:“ )

Schritt 2: Bibliotheken importieren

Sobald das Setup abgeschlossen ist und alle erforderlichen Pakete installiert sind, importieren Sie die erforderlichen Bibliotheken zum Erstellen der Eingabeaufforderungsvorlage. Anschließend erstellen Sie einfach das LLM mit der OpenAI()-Methode und konfigurieren die LLMChain mithilfe der LLMs und der Eingabeaufforderungsvorlage:

aus langchain importieren PromptTemplateaus langchain importieren OpenAI

aus langchain importieren LLMChain

prompt_template = „Geben Sie mir einen guten Titel für das Unternehmen, das {Produkt} herstellt?“

llm = OpenAI ( Temperatur = 0 )

llm_chain = LLMChain (

llm = llm ,

prompt = PromptTemplate. von Vorlage ( prompt_template )

)

llm_chain ( 'farbenfrohe Kleider' )

Schritt 3: Ketten laufen lassen

Rufen Sie die Eingabeliste mit den verschiedenen vom Unternehmen hergestellten Produkten ab und führen Sie die Kette aus, um die Liste auf dem Bildschirm anzuzeigen:

Eingabeliste = [{ 'Produkt' : „Socken“ } ,

{ 'Produkt' : 'Computer' } ,

{ 'Produkt' : 'Schuhe' }

]

llm_chain. anwenden ( Eingabeliste )

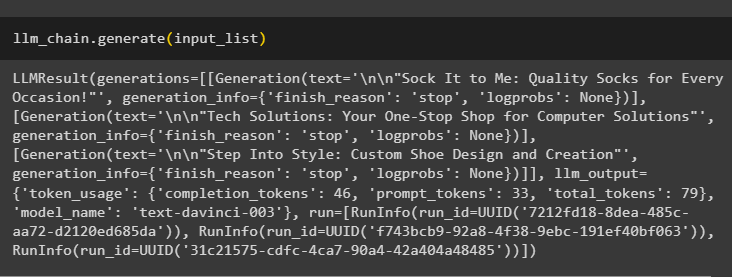

Führen Sie die Methode „generate()“ mit dem aus Eingabeliste mit LLMChains, um die Ausgabe im Zusammenhang mit der vom Modell generierten Konversation zu erhalten:

llm_chain. generieren ( Eingabeliste )

Schritt 4: Einzeleingabe verwenden

Fügen Sie ein weiteres Produkt hinzu, um die LLMChains mit nur einer einzigen Eingabe auszuführen, und sagen Sie dann die LLMChain voraus, um die Ausgabe zu generieren:

llm_chain. vorhersagen ( Produkt = „bunte Socken“ )Schritt 5: Mehrere Eingaben verwenden

Erstellen Sie nun die Vorlage für die Verwendung mehrerer Eingaben zur Bereitstellung des Befehls für das Modell, bevor Sie die Kette ausführen:

Vorlage = „Erzähl mir einen {Adjektiv}-Witz über {Thema}.““prompt = PromptTemplate ( Vorlage = Vorlage , Eingabevariablen = [ 'Adjektiv' , 'Thema' ] )

llm_chain = LLMChain ( prompt = prompt , llm = OpenAI ( Temperatur = 0 ) )

llm_chain. vorhersagen ( Adjektiv = 'traurig' , Thema = 'Enten' )

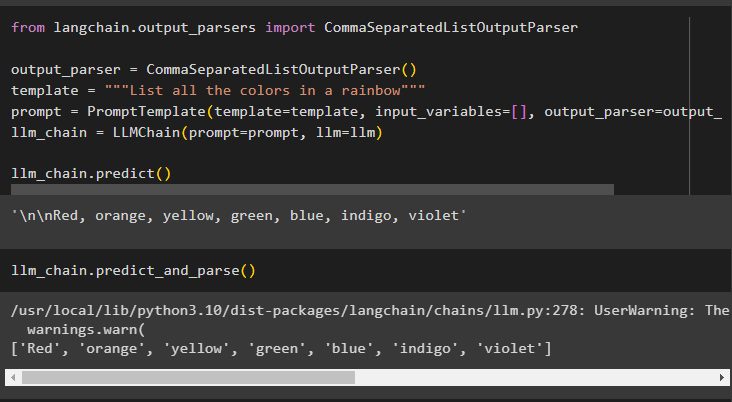

Schritt 6: Verwenden des Ausgabeparsers

In diesem Schritt wird die Ausgabeparser-Methode verwendet, um LLMChain auszuführen und die Ausgabe basierend auf der Eingabeaufforderung zu erhalten:

aus langchain. Ausgabeparser importieren CommaSeparatedListOutputParserAusgabeparser = CommaSeparatedListOutputParser ( )

Vorlage = „Listen Sie alle Farben eines Regenbogens auf“

prompt = PromptTemplate ( Vorlage = Vorlage , Eingabevariablen = [ ] , Ausgabeparser = Ausgabeparser )

llm_chain = LLMChain ( prompt = prompt , llm = llm )

llm_chain. vorhersagen ( )

Wenn Sie die Methode parse() verwenden, um die Ausgabe zu erhalten, wird eine durch Kommas getrennte Liste aller Farben im Regenbogen generiert:

llm_chain. vorhersagen_und_parsen ( )

Schritt 7: Initialisierung aus Strings

In diesem Schritt wird der Prozess der Verwendung einer Zeichenfolge als Eingabeaufforderung zum Ausführen von LLMChain mithilfe des LLM-Modells und der LLM-Vorlage erläutert:

Vorlage = „Erzähl mir einen {Adjektiv}-Witz über {Thema}““llm_chain = LLMChain. from_string ( llm = llm , Vorlage = Vorlage )

Geben Sie die Werte der Variablen in der Zeichenfolgenaufforderung an, um die Ausgabe des Modells durch Ausführen von LLMChain zu erhalten:

llm_chain. vorhersagen ( Adjektiv = 'traurig' , Thema = 'Enten' )Dabei geht es darum, die LLMChains mithilfe des LangChain-Frameworks auszuführen.

Abschluss

Um die LLMChains in LangChain zu erstellen und auszuführen, installieren Sie die Voraussetzungen wie Pakete und richten Sie die Umgebung mit dem API-Schlüssel von OpenAI ein. Anschließend importieren Sie die erforderlichen Bibliotheken zum Konfigurieren der Eingabeaufforderungsvorlage und des Modells für die Ausführung von LLMChain mithilfe der LangChain-Abhängigkeiten. Der Benutzer kann Ausgabeparser und Zeichenfolgenbefehle verwenden, um LLMChains auszuführen, wie im Handbuch gezeigt. In diesem Leitfaden wurde der gesamte Prozess der Ausführung der LLMChains in LangChain erläutert.