Syntax:

Da wir mit ChatGPT vertraut sind, wissen wir, dass diese Plattform der Open AI-Community gehört und Tools, Architekturen, APIs und verschiedene Frameworks bereitstellt, die wir bei der Bereitstellung unserer Anwendungen und der Modelle zur Verarbeitung natürlicher Sprache verwenden können. Open AI bietet die APIs, über die wir alle vorab trainierten KI- und NLP-Modelle der Open AI-Plattform verwenden und sie für unsere Anwendungen nutzen können, beispielsweise um Vorhersagen zu Echtzeitdaten zu treffen. Ebenso bietet GPT4All seinen Benutzern die Möglichkeit, seine vorab trainierten KI-Modelle in verschiedene Anwendungen zu integrieren.

Das GPT4All-Modell wird im Vergleich zu ChatGPT auf begrenzten Daten trainiert. Es weist im Vergleich zu ChatGPT auch einige Leistungseinschränkungen auf, ermöglicht dem Benutzer jedoch die Verwendung seines privaten GPT auf seiner lokalen Hardware und erfordert keine Netzwerkverbindungen. Mithilfe dieses Artikels erfahren wir, wie wir die GPT4All-Modelle im Python-Skript verwenden können, da GPT4All über die offiziellen Bindungen mit Python verfügt, was bedeutet, dass wir die GPT4All-Modelle auch über das Python-Skript verwenden und integrieren können.

Um GPT4All für die Python-IDE zu installieren, ist ein Online-Befehl erforderlich. Dann können wir möglicherweise so viele KI-Modelle wie unsere Anwendungen integrieren. Der Befehl zum Installieren von GPT4All in Python lautet wie folgt:

$ pip gpt4all installieren

Beispiel 1:

Um mit diesem Beispiel zu beginnen, müssen wir Python herunterladen und in unseren Systemen installieren. Die empfohlenen Versionen von Python sind „Version 3.7“ oder diejenigen, die nach dieser Version kamen. Eine andere Möglichkeit, mit Python zu arbeiten und den langen Prozess der Installation des „Python-Setups“ auf unseren Systemen zu vermeiden, ist die Verwendung von „Google Colab“, einer cloudbasierten Umgebung für Python. Wir können diese Umgebung in jedem Webbrowser ausführen und die KI- und maschinellen Lernmodelle erstellen. Die Beispiele, die wir hier implementieren werden, werden im Google Colab ausgeführt.

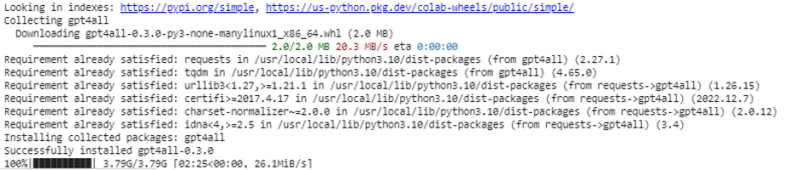

Dieses Beispiel behandelt die Methode zur Installation von GPT4All in Python und die Verwendung seiner vorab trainierten Modelle. Wir beginnen mit der Installation von GPT4All. Dazu wird der zuvor erwähnte Befehl ausgeführt. Mit der Ausführung des Befehls wird GPT4All zusammen mit seinen Paketen und Frameworks heruntergeladen und installiert.

Jetzt machen wir weiter. Aus GPT4All importieren wir „GPT4All“. Dadurch werden alle vorab trainierten Modelle von GPT4All zum Projekt hinzugefügt. Jetzt können wir jedes einzelne Modell verwenden und es die Vorhersagen für unsere Anwendung machen lassen. Sobald wir das GPT4All-Paket importiert haben, ist es nun an der Zeit, diese Funktion aufzurufen und das GPT4All-Modell zu verwenden, das die Ausgabe für den „Chat-Abschluss“ liefert.

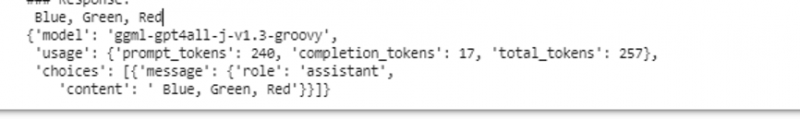

Mit anderen Worten: Wenn wir in der Eingabe etwas von diesem Modell abfragen, gibt es es in der Ausgabe zurück. Das Modell, das wir hier verwenden, ist „ggml-gpt4all-j-v1.3-groovy“. Diese Modelle sind bereits im GPT4All-Cache gespeichert. Wir können diese Modelle über diesen Link erhalten. https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” zum manuellen Herunterladen. Wenn das Modell bereits im GPT4All-Cache vorhanden ist, rufen wir einfach den Namen des Modells auf und geben ihn als Eingabeparameter für die Funktion „GPT4All()“ an. Wenn wir es erfolgreich manuell heruntergeladen haben, übergeben wir den Pfad zu dem Ordner, in dem sich das Modell befindet. Da dieses Modell der Vervollständigung von Nachrichten dient, lautet die Syntax für dieses Modell wie folgt:

$ Chat_completion (Nachrichten)Die Nachrichten sind eine Wörterbuchliste und jedes Wörterbuch sollte einen „Rollen“-Schlüssel mit einem Wert des Benutzers, Systems oder Assistenten sowie den „Schlüssel“-Inhalt enthalten, der den Wert als Zeichenfolge hat. In diesem Beispiel geben wir den Inhalt als „Name drei Farben“ und den Rollenschlüssel als „Benutzer“ an.

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'role': 'user', 'content': 'Name 3 Flowers'}]

Nach dieser Spezifikation rufen wir die Funktion „chat_completion()“ mit dem Modell auf. Der Code hierfür wird in der folgenden Ausgabe angezeigt:

$ !pip gpt4all installierenaus gpt4all GPT4All importieren

model = GPT4All('ggml-gpt4all-j-v1.3-groovy')

message = [{'role': 'user', 'content': 'Nennen Sie drei Farben'}]

model.chat_completion(nachrichten)

Nach der Ausführung dieses Beispiels gibt das Modell drei Farben als Antwort auf die Eingabe zurück.

Beispiel 2:

Wir behandeln ein weiteres Beispiel, in dem wir eine andere Methode zur Verwendung von GPT4All in Python entdecken. Dies kann mithilfe der offiziellen Bindungen für Python erfolgen, die von „Nomic“, einer Open-Source-KI-Community, bereitgestellt werden und GPT4All ausführen. Mit dem folgenden Befehl integrieren wir „nomic“ in unsere Python-Konsole:

$ pip install nomicSobald dies installiert ist, importieren wir das GPT4All aus „nomic.gpt4all“. Nach dem Import von GPT4All initialisieren wir das GPT4All mit der Funktion „open()“. Dann rufen wir die Funktion „prompt()“ auf und übergeben einen Prompt an diese Funktion. Anschließend wird eine Prompt-Antwort basierend auf dem Prompt generiert, den wir als Eingabe für das Prompt-Modell angegeben haben.

!pip install nomicaus nomic.gpt4all GPT4All importieren

# Initialisieren Sie das GPT4All-Modell

initiieren = GPT4All()

initial.open()

# Generieren einer Antwort basierend auf der Eingabeaufforderung

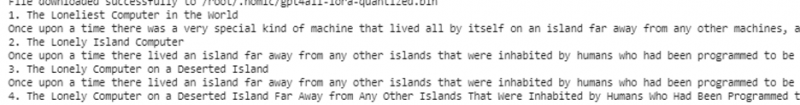

model_response = initiate.prompt('eine Kurzgeschichte über einen Computer schreiben)

# Anzeige der generierten Antwort

print(model_response)

Die Ausgabe zeigt die prompte Antwort des Modells, das wir mit dem vorab trainierten GPT4All-Modell in Python generiert haben. Wenn wir mehr über die Modelle erfahren möchten und wissen möchten, wie wir diese Modelle zum Generieren der Antworten verwenden können, oder einfach ausgedrückt, wenn wir Kenntnisse über die Syntax zum Generieren der Antworten aus diesen Modellen erlangen möchten, können wir weitere Hilfe von der erhalten GPT4Alle technischen Dokumentationsdetails.

Abschluss

GPT4All ist weiterhin bestrebt, Leistungsgenauigkeit zu erreichen. Es wird von der nomic AI-Plattform betrieben, deren Ziel es ist, ihren Benutzern künstlich intelligente Chatbots auf Verbraucher-CPUs bereitzustellen, da GPT4All ohne Netzwerkverbindung und GPUs funktioniert. Dieser Artikel zeigt uns, wie wir PyGPT4All in einer Python-Umgebung kompetent nutzen und eine Interaktion zwischen unseren Anwendungen und den vorab trainierten GPT4All-KI-Modellen herstellen können. In diesem Handbuch haben wir zwei verschiedene Methoden zur Installation von GPT4All in Python behandelt.