In dieser Ära sind Transformer die leistungsstärksten Modelle, die bei mehreren NLP-Operationen (Natural Language Processing) die besten Ergebnisse geliefert haben. Ursprünglich wurde es für Sprachmodellierungsaufgaben verwendet, darunter Textgenerierung und -klassifizierung, maschinelle Übersetzung und vieles mehr. Mittlerweile wird es aber auch zur Objekterkennung, Bildklassifizierung und vielen anderen Computer-Vision-Aufgaben verwendet.

In diesem Tutorial stellen wir das Verfahren zur Durchführung der Textklassifizierung mithilfe von Transformern bereit.

Wie führe ich eine Textklassifizierung mithilfe von Transformatoren durch?

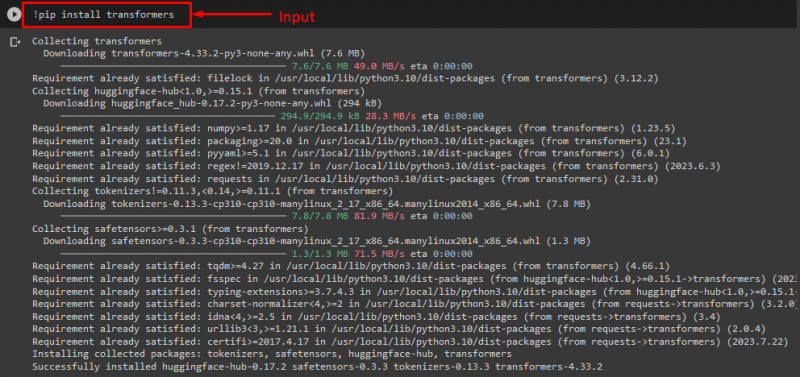

Um die Textklassifizierung mit Transformers durchzuführen, installieren Sie zunächst das „ Transformer ”-Bibliothek durch Ausführen des bereitgestellten Befehls:

! Pip Installieren Transformer

Wie Sie sehen, wurde die angegebene Bibliothek erfolgreich installiert:

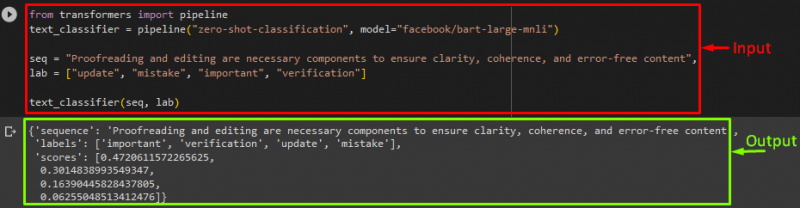

Importieren Sie dann „ Pipeline ' von dem ' Transformer ' Bibliothek:

aus der Transformatoren-Importpipeline

Hier das ' Pipeline „enthält die NLP-Aufgabe, die wir ausführen müssen, und das gewünschte Transformatormodell für diesen Vorgang zusammen mit dem Tokenizer.

Notiz: Der Tokenizer wird verwendet, um eine Verarbeitung des Texts durchzuführen, der als Eingabe für das Modell bereitgestellt werden soll, indem er den Text in Token aufteilt.

Verwenden Sie danach die Funktion „ Pipeline() ”-Funktion und übergeben Sie ihr die „ Null-Schuss-Klassifizierung “ als Argument. Als nächstes übergeben Sie einen weiteren Parameter, der unser Modell ist. Wir nutzen Facebooks „ BART ” Transformatormodell. Hier verwenden wir den Tokenizer nicht, da er vom angegebenen Modell automatisch abgeleitet werden kann:

text_classifier = Pipeline ( „Zero-Shot-Klassifizierung“ , Modell = „facebook/bart-large-mnli“ )

Erklären Sie nun „ seq „Variable, die unseren Eingabetext enthält, der klassifiziert werden muss. Anschließend geben wir die Kategorien an, in die wir den Text klassifizieren möchten, und speichern ihn im „ Labor ” was als Etiketten bekannt ist:

lab = [ 'aktualisieren' , 'Fehler' , 'wichtig' , 'Überprüfung' ]

Führen Sie abschließend die Pipeline zusammen mit der Eingabe aus:

Wie Sie sehen können, hat das Modell nach der Ausführung der Pipeline die Klassifizierung unserer bereitgestellten Sequenz vorhergesagt:

Weitere Informationen: Wenn Sie die Leistung des Modells beschleunigen möchten, müssen Sie die GPU verwenden. Wenn ja, können Sie zu diesem Zweck ein Geräteargument für die Pipeline angeben und es auf „ 0 ” um die GPU zu nutzen.

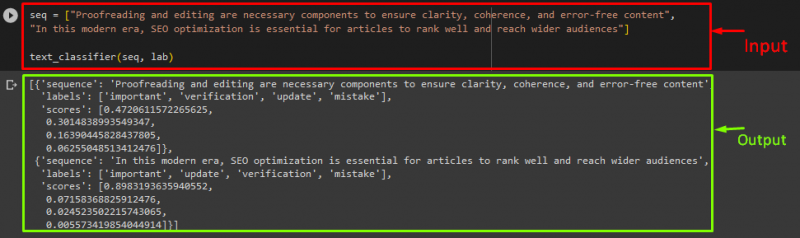

Wenn Sie den Text in mehr als einer Sequenz-/Eingabetextanweisung klassifizieren möchten, können Sie diese einer Liste hinzufügen und als Eingabe an die Pipelines übergeben. Schauen Sie sich zu diesem Zweck das Code-Snippet an:

seq = [ „Korrekturlesen und Lektorat sind notwendige Komponenten, um Klarheit, Kohärenz und fehlerfreie Inhalte sicherzustellen.“ ,„In dieser modernen Zeit ist SEO-Optimierung unerlässlich, damit Artikel ein gutes Ranking erzielen und ein breiteres Publikum erreichen.“ ]

text_classifier ( seq , Labor )

Ausgabe

Das ist es! Wir haben den einfachsten Weg zur Textklassifizierung mit Transformers zusammengestellt.

Abschluss

Transformatoren werden verwendet, um Sprachmodellierungsaufgaben wie Textgenerierung, Textklassifizierung und maschinelle Übersetzung sowie Computer-Vision-Aufgaben einschließlich Objekterkennung und Bildklassifizierung auszuführen. In diesem Tutorial haben wir den Prozess zur Durchführung der Textklassifizierung mithilfe von Transformers veranschaulicht.