Syntax:

Es gibt eine Vielzahl von Diensten, die Hugging Face anbietet, aber einer der am häufigsten verwendeten Dienste ist „API“. Die API ermöglicht die Interaktion der vorab trainierten KI und großen Sprachmodelle mit verschiedenen Anwendungen. Hugging Face stellt die APIs für verschiedene Modelle bereit, wie im Folgenden aufgeführt:

- Modelle zur Textgenerierung

- Übersetzungsmodelle

- Modelle zur Analyse der Gefühle

- Modelle zur Entwicklung virtueller Agenten (intelligente Chatbots)

- Klassifikation und die Regressionsmodelle

Lassen Sie uns nun die Methode entdecken, um unsere personalisierte Inferenz-API von Hugging Face zu erhalten. Dazu müssen wir uns zunächst auf der offiziellen Website von Hugging Face registrieren. Treten Sie dieser Community von Hugging Face bei, indem Sie sich mit Ihren Zugangsdaten auf dieser Website anmelden.

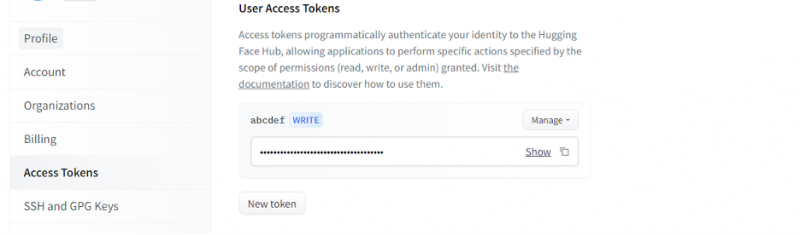

Sobald wir ein Konto bei Hugging Face erhalten, müssen wir nun die Inferenz-API anfordern. Um die API anzufordern, gehen Sie zu den Kontoeinstellungen und wählen Sie das „Zugriffstoken“ aus. Es öffnet sich ein neues Fenster. Wählen Sie die Option „Neues Token“ und generieren Sie dann das Token, indem Sie zunächst den Namen des Tokens und seine Rolle als „WRITE“ angeben. Ein neuer Token wird generiert. Jetzt müssen wir dieses Token speichern. Bis zu diesem Zeitpunkt haben wir unser Zeichen vom Hugging Face. Im nächsten Beispiel werden wir sehen, wie wir dieses Token verwenden können, um eine Inferenz-API zu erhalten.

Beispiel 1: So erstellen Sie Prototypen mit der Hugging Face Inference API

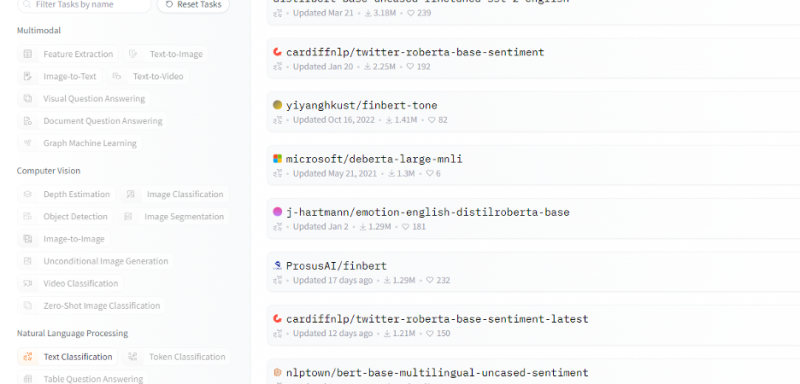

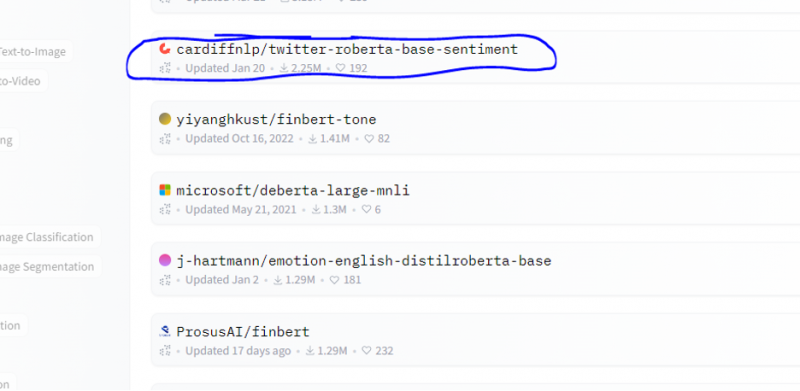

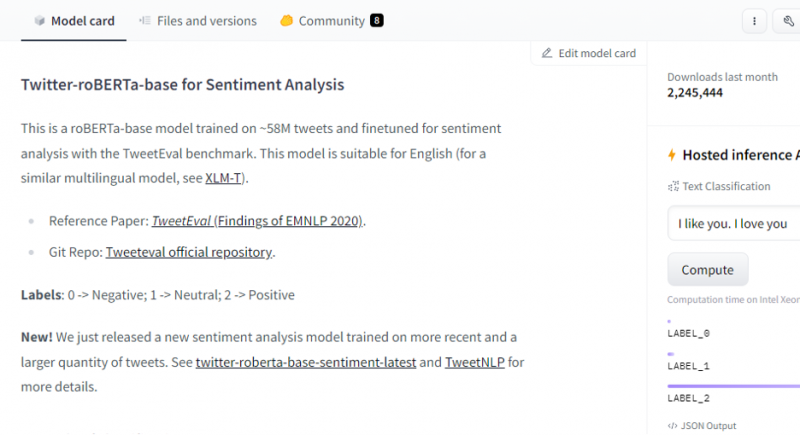

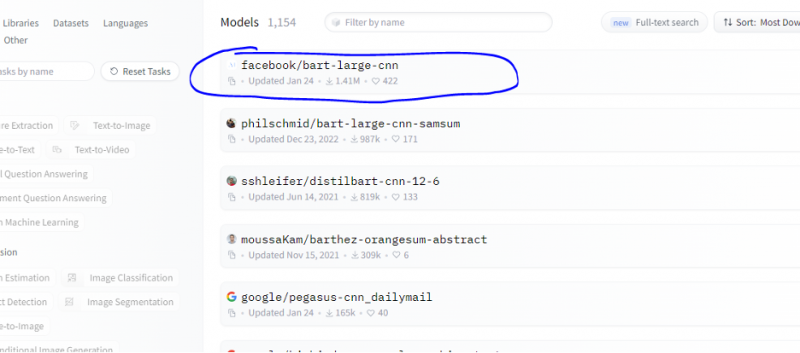

Bisher haben wir die Methode für den Einstieg in Hugging Face besprochen und einen Token von Hugging Face initialisiert. Dieses Beispiel zeigt, wie wir dieses neu generierte Token verwenden können, um eine Inferenz-API für ein bestimmtes Modell (maschinelles Lernen) zu erhalten und damit Vorhersagen zu treffen. Wählen Sie auf der Homepage von Hugging Face ein beliebiges Modell aus, mit dem Sie arbeiten möchten und das für Ihr Problem relevant ist. Nehmen wir an, wir möchten mit der Textklassifizierung oder dem Stimmungsanalysemodell arbeiten, wie im folgenden Ausschnitt aus der Liste dieser Modelle gezeigt:

Aus diesem Modell wählen wir das Stimmungsanalysemodell.

Nach Auswahl des Modells erscheint dessen Modellkarte. Diese Modellkarte enthält Informationen zu den Trainingsdetails des Modells und zu den Eigenschaften des Modells. Unser Modell ist ein roBERTa-basiertes Modell, das auf den 58 Millionen Tweets zur Stimmungsanalyse trainiert wird. Dieses Modell verfügt über drei Hauptklassenbezeichnungen und kategorisiert jede Eingabe in ihre relevanten Klassenbezeichnungen.

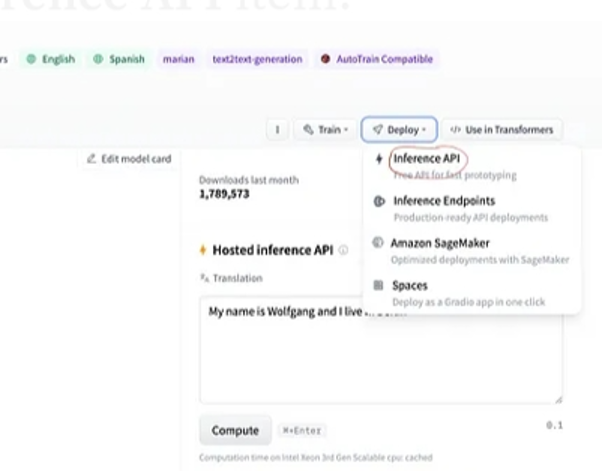

Wenn wir nach der Auswahl des Modells die Bereitstellungsschaltfläche in der oberen rechten Ecke des Fensters auswählen, wird ein Dropdown-Menü geöffnet. In diesem Menü müssen wir die Option „Inferenz-API“ auswählen.

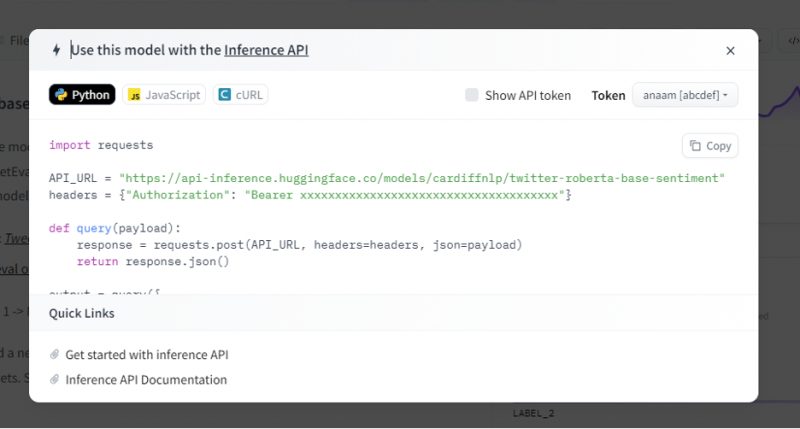

Die Inferenz-API liefert dann eine vollständige Erklärung, wie dieses spezifische Modell mit dieser Inferenz verwendet wird, und ermöglicht uns die schnelle Erstellung des Prototyps für das KI-Modell. Das Inferenz-API-Fenster zeigt den Code an, der im Python-Skript geschrieben ist.

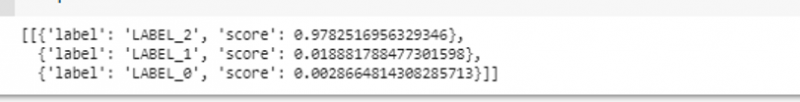

Wir kopieren diesen Code und führen ihn in einer beliebigen Python-IDE aus. Wir nutzen hierfür Google Colab. Nach der Ausführung dieses Codes in der Python-Shell wird eine Ausgabe zurückgegeben, die den Score und die Label-Vorhersage enthält. Diese Bezeichnung und Bewertung werden entsprechend unserer Eingabe vergeben, da wir das Modell „Text-Sentiment-Analyse“ gewählt haben. Dann ist die Eingabe, die wir dem Modell geben, ein positiver Satz und das Modell wurde vorab auf drei Label-Klassen trainiert: Label 0 impliziert negativ, Label1 impliziert neutral und Label 2 ist auf positiv gesetzt. Da es sich bei unserer Eingabe um einen positiven Satz handelt, ist die Bewertungsvorhersage des Modells höher als die der anderen beiden Bezeichnungen, was bedeutet, dass das Modell den Satz als „positiv“ vorhergesagt hat.

importieren AnfragenAPI_URL = „https://api-inference.huggingface.co/models/cardiffnlp/twitter-roberta-base-sentiment“

Kopfzeilen = { 'Genehmigung' : „Träger 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“ }

def Anfrage ( Nutzlast ) :

Antwort = Anfragen. Post ( API_URL , Kopfzeilen = Kopfzeilen , json = Nutzlast )

zurückkehren Antwort. json ( )

Ausgang = Anfrage ( {

„Eingaben“ : „Ich fühle mich gut, wenn du bei mir bist“ ,

} )

Ausgang:

Beispiel 2: Zusammenfassungsmodell durch Inferenz

Wir folgen den gleichen Schritten wie im vorherigen Beispiel und erstellen einen Prototypen des Zusammenfassungsmodellbusses mithilfe seiner Inferenz-API von Hugging Face. Das Zusammenfassungsmodell ist ein vorab trainiertes Modell, das den gesamten Text zusammenfasst, den wir ihm als Eingabe geben. Gehen Sie zum Hugging Face-Konto, klicken Sie in der oberen Menüleiste auf das Modell, wählen Sie dann das für die Zusammenfassung relevante Modell aus, wählen Sie es aus und lesen Sie die Modellkarte sorgfältig durch.

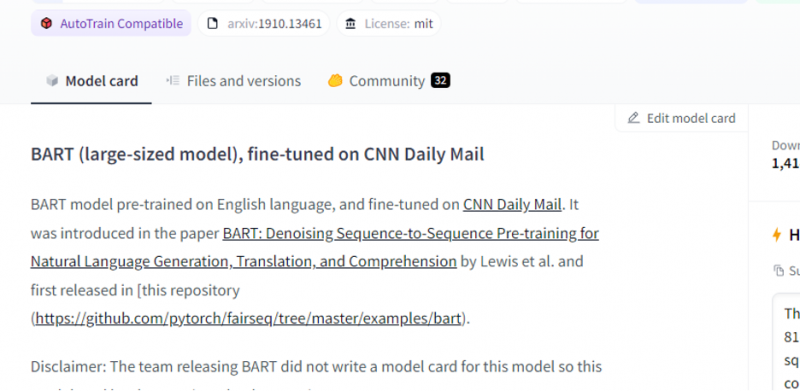

Das von uns gewählte Modell ist ein vorab trainiertes BART-Modell und ist genau auf den CNN-Dailmail-Datensatz abgestimmt. BART ist ein Modell, das dem BERT-Modell am ähnlichsten ist, das über einen Encoder und Decoder verfügt. Dieses Modell ist effektiv, wenn es für Verständnis-, Zusammenfassungs-, Übersetzungs- und Textgenerierungsaufgaben genau abgestimmt ist.

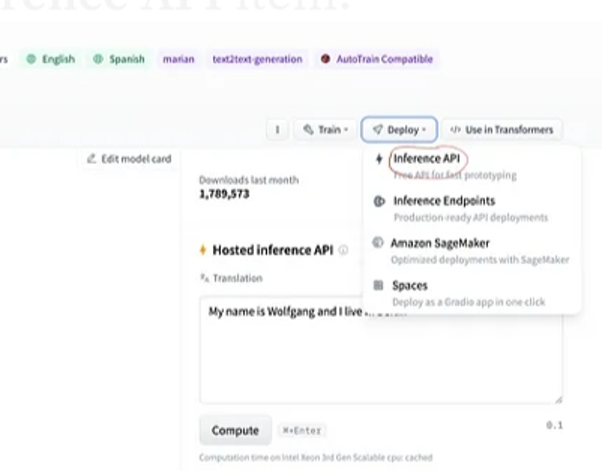

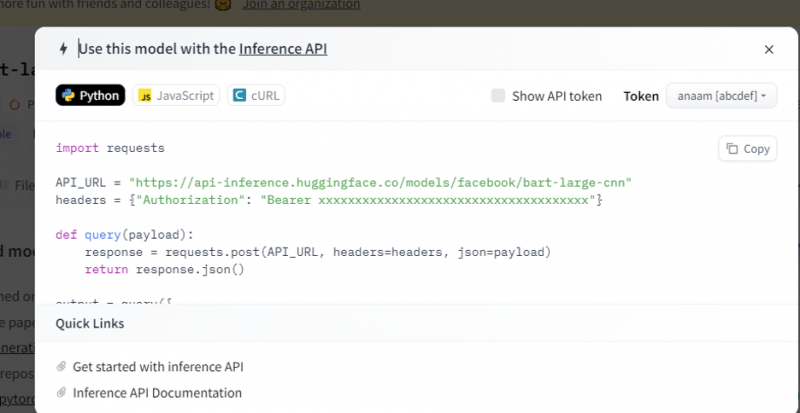

Wählen Sie dann die Schaltfläche „Bereitstellung“ in der oberen rechten Ecke und wählen Sie die Inferenz-API aus dem Dropdown-Menü aus. Die Inferenz-API öffnet ein weiteres Fenster, das den Code und die Anweisungen zur Verwendung dieses Modells mit dieser Inferenz enthält.

Kopieren Sie diesen Code und führen Sie ihn in einer Python-Shell aus.

Das Modell gibt den Output zurück, der die Zusammenfassung des Inputs ist, den wir ihm zugeführt haben.

Abschluss

Wir haben an der Hugging Face Inference API gearbeitet und gelernt, wie wir die programmierbare Schnittstelle dieser Anwendung verwenden können, um mit den vorab trainierten Sprachmodellen zu arbeiten. Die beiden Beispiele, die wir in dem Artikel gemacht haben, basierten hauptsächlich auf den NLP-Modellen. Die Hugging Face API kann Wunder bewirken, wenn wir einen schnellen Prototyp entwickeln möchten, indem sie die schnelle Integration von KI-Modellen in unsere Anwendungen ermöglicht. Kurz gesagt, Hugging Face bietet Lösungen für alle Ihre Probleme, vom Reinforcement Learning bis hin zum Computer Vision.