Die Funktion „pipeline()“ ist ein integraler Bestandteil der Transformer-Bibliothek. Es sind mehrere Eingaben erforderlich, in denen wir eine Inferenzaufgabe, Modelle, einen Tokenisierungsmechanismus usw. definieren können. Eine Pipeline()-Funktion wird hauptsächlich verwendet, um NLP-Aufgaben für einen oder mehrere Texte auszuführen. Es führt eine Vorverarbeitung der Eingabe und eine Nachverarbeitung basierend auf dem Modell durch, um eine für Menschen lesbare Ausgabe und genaue Vorhersagen mit maximaler Genauigkeit zu generieren.

Dieser Artikel behandelt die folgenden Aspekte:

- Was ist die Hugging Face-Datensatzbibliothek?

- Wie wende ich Pipelines auf einen Datensatz in Hugging Face an?

Was ist die Hugging Face-Datensatzbibliothek?

Eine Hugging Face-Datensatzbibliothek ist eine API, die mehrere öffentliche Datensätze enthält und eine einfache Möglichkeit bietet, diese herunterzuladen. Diese Bibliothek kann mit dem Befehl „ importiert und in die Anwendung installiert werden. Pip ' Befehl. Eine praktische Demonstration zum Herunterladen und Installieren von Datensätzen der Hugging Face-Bibliothek finden Sie hier Google Colab-Link. Sie können mehrere Datensätze von herunterladen Hugging Face-Datensatz-Hub.

Erfahren Sie mehr über die Funktionsweise der Funktion „pipeline()“ in diesem Artikel „ Wie verwende ich die Funktion Pipeline() in Transformers? “.

Wie wende ich Pipelines auf einen Datensatz in Hugging Face an?

Hugging Face bietet mehrere verschiedene öffentliche Datensätze, die einfach mithilfe von einzeiligem Code installiert werden können. In diesem Artikel sehen wir eine praktische Demonstration der Anwendung von Pipelines auf diese Datensätze. Es gibt zwei Möglichkeiten, Pipelines im Datensatz zu implementieren.

Methode 1: Verwendung der Iterationsmethode

Die Funktion „pipeline()“ kann auch über einen Datensatz und ein Modell iteriert werden. Befolgen Sie dazu die unten aufgeführten Schritte:

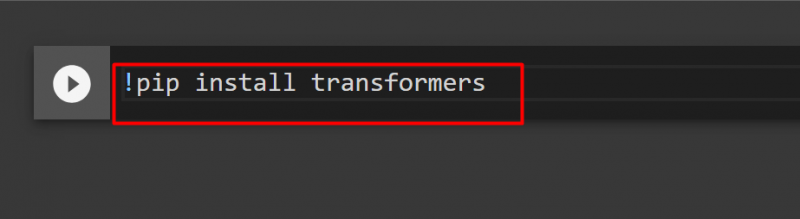

Schritt 1: Transformer-Bibliothek installieren

Geben Sie zum Installieren der Transformer-Bibliothek den folgenden Befehl ein:

!pip Transformatoren installieren

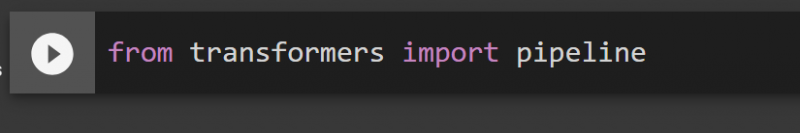

Schritt 2: Pipelines importieren

Wir können die Pipeline aus der Transformer-Bibliothek importieren. Geben Sie zu diesem Zweck den folgenden Befehl ein:

aus der Transformatoren-Importpipeline

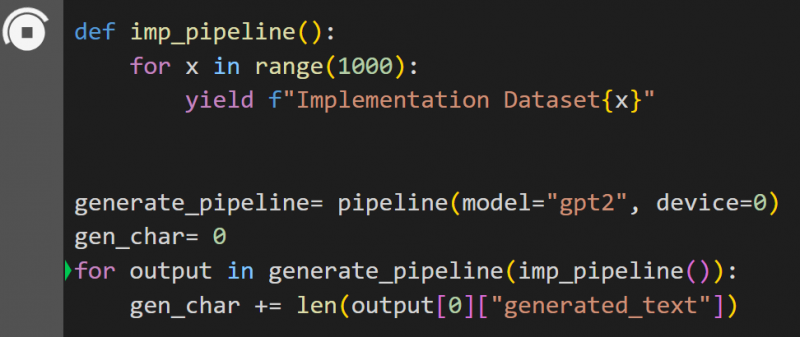

Schritt 3: Pipeline implementieren

Hier wird die Funktion „pipeline()“ auf dem Modell implementiert „ gpt2 “. Sie können Modelle von herunterladen Model-Hub „Umarmendes Gesicht“:

def imp_pipeline():für x im Bereich(1000):

yield f'Implementation Dataset{x}'

generate_pipeline=pipeline(model='gpt2', device=0)

gen_char= 0

für die Ausgabe in generic_pipeline(imp_pipeline()):

gen_char += len(output[0]['generated_text'])

In diesem Code ist das „ generieren_pipeline „ ist eine Variable, die die Funktion „pipeline()“ mit dem Modell „ enthält. gpt2 “. Beim Aufruf mit „ imp_pipeline() ”-Funktion erkennt es automatisch die Daten, die mit dem angegebenen Bereich auf 1000 erhöht werden:

Das Training wird einige Zeit in Anspruch nehmen. Der Link zum Google Co ist auch gegeben.

Methode 2: Verwenden der Datensatzbibliothek

In dieser Methode demonstrieren wir die Implementierung der Pipeline mithilfe der „Datasets“-Bibliothek:

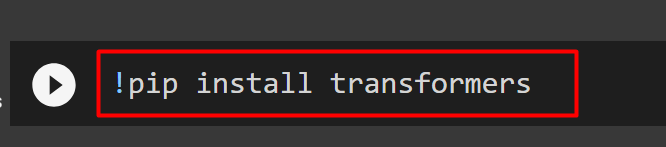

Schritt 1: Transformer installieren

Geben Sie zum Installieren der Transformer-Bibliothek den folgenden Befehl ein:

!pip Transformatoren installieren

Schritt 2: Installieren Sie die Datensatzbibliothek

Als die ' Datensätze „Die Bibliothek enthält alle öffentlichen Datensätze. Wir können sie mit dem folgenden Befehl installieren. Durch die Installation des „ Datensätze „Bibliothek können wir jeden Datensatz direkt importieren, indem wir seinen Namen angeben:

!pip Datensätze installieren

Schritt 3: Datensatz-Pipeline

Verwenden Sie den folgenden Code, um eine Pipeline für den Datensatz zu erstellen. KeyDataset ist eine Funktion, die nur die Werte ausgibt, die den Benutzer interessieren:

aus Transformers.pipelines.pt_utils KeyDataset importierenaus der Transformatoren-Importpipeline

aus Datensätzen import load_dataset

gen_pipeline = Pipeline(model='hf-internal-testing/tiny-random-wav2vec2', Gerät=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')für die Ausgabe in gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('Ausgabe jetzt drucken')

drucken ('----------------')

drucken (Ausgabe)

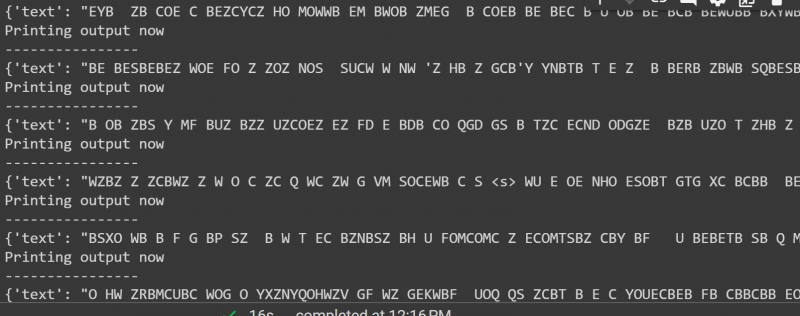

Die Ausgabe des obigen Codes ist unten angegeben:

Das ist alles aus diesem Leitfaden. Der Link zum Google Co wird auch in diesem Artikel erwähnt

Abschluss

Um Pipelines auf den Datensatz anzuwenden, können wir entweder mit der Funktion „pipeline()“ über einen Datensatz iterieren oder die Funktion „ Datensätze ' Bibliothek. Hugging Face stellt seinen Benutzern den GitHub-Repository-Link für Datensätze und Modelle zur Verfügung, die je nach Anforderungen verwendet werden können. Dieser Artikel bietet eine umfassende Anleitung zum Anwenden von Pipelines auf einen Datensatz in Transformers.