Bereinigen der Daten mit Python und Pandas

Daten sind heute so etwas wie die Bausteine der Entscheidungsfindung. Aber stellen Sie sich vor, Sie hätten eine Gruppe von Blöcken unterschiedlicher Form und Größe aus dieser Kollektion; Es ist schwierig, etwas Sinnvolles aufzubauen. Hier kommt die Datenbereinigung ins Spiel.

In diesem Leitfaden wird erläutert, wie Sie die Daten mithilfe des Python-Frameworks Pandas bereinigen, um eine bessere Entscheidungsfindung zu ermöglichen. Auch die Datenbereinigung ist unerlässlich, wenn man bedenkt, dass wir mit einer Liste von Verkaufsunterlagen für ein Geschäft arbeiten. Möglicherweise bemerken wir fehlende Zahlen, seltsame Daten und wiederholte Elemente ohne Grund in der Liste. Wenn wir die Berechnungen oder Aufzeichnungen auf der Grundlage dieser Informationen durchführen, können diese Probleme unsere Berechnungen und Vorhersagen durcheinander bringen. Die Datenbereinigung hilft, diese Probleme zu beheben und stellt sicher, dass unsere Daten korrekt und einsatzbereit sind.

Die Datenbereinigung umfasst den Umgang mit den fehlenden Daten und die Vorgehensweise bei fehlenden Daten, das Entfernen von Duplikaten, das Entfernen kopierter Inhalte, das Korrigieren der Datentypen, das Sicherstellen, dass alles im richtigen Format vorliegt, sowie den Umgang mit Ausreißern oder den Umgang mit Zahlen die nicht hineinpassen. Durch diese Fehler sehen die Daten gleich aus und standardisieren die Darstellung der Daten.

Stellen Sie zunächst sicher, dass Python und Pandas installiert sind. Wir können dies tun, indem wir die Befehle in das Terminal oder die Eingabeaufforderung unseres Computers eingeben. Um die in diesem Handbuch erwähnten Codes zu implementieren, können wir die Python Pycharm IDE verwenden, die auf unserem System installiert ist, oder die Online-Python-Plattform „Google Colab“ und die „pip“-Befehle installieren, um die wichtigen Bibliotheken zu installieren.

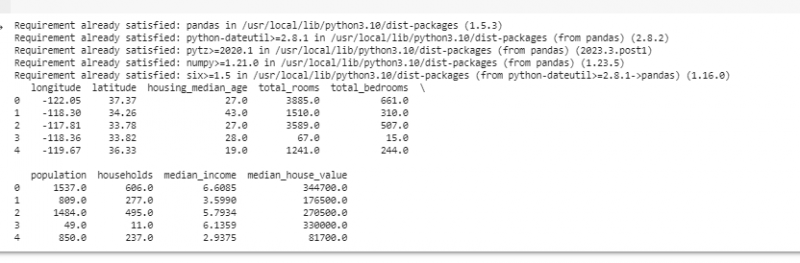

Jetzt importieren wir Pandas und laden unsere Beispieldaten. In diesem Beispiel verwenden wir Google Colab, um die Codes auszuführen. Daher importieren wir zunächst Pandas, indem wir den folgenden Befehl eingeben:

! Pip Pandas installieren

importieren Pandas als pd

importieren Numpy als z.B.

Anschließend laden wir den Datensatz, den wir anzeigen möchten, mit der Methode pd.read(), die den Dateipfad als Eingabeparameter verwendet.

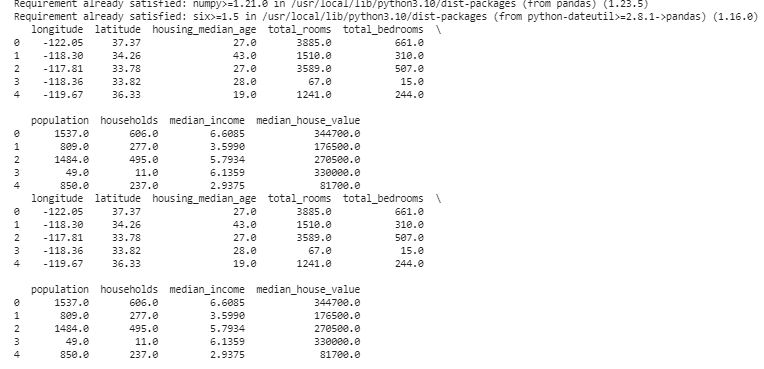

# Laden Sie den DatensatzDaten = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Zeigt die ersten Zeilen an

drucken ( Daten. Kopf ( ) )

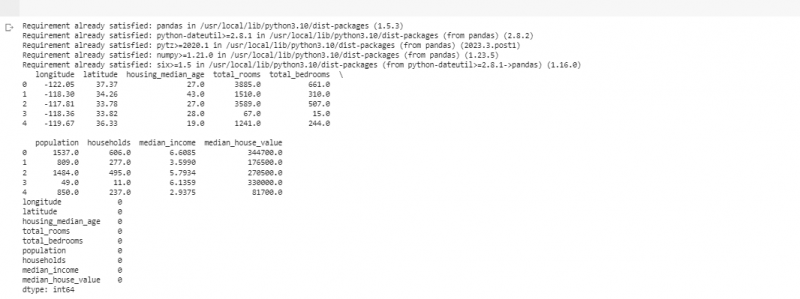

Im nächsten Beispiel verwenden wir die Daten über Verkäufe in einem kleinen Laden. Um mit den fehlenden Daten umzugehen, fehlen in unseren Daten manchmal die Informationen. Wir nennen diese fehlenden Teile „NaN“ (was „keine Zahl“ bedeutet). Um diese fehlenden Werte im Python-Skript zu finden, laden wir zunächst den Datensatz wie im vorherigen Beispiel. Anschließend suchen wir mit der Funktion „missing_values = data.isnull().sum()“ nach fehlenden Werten im Datensatz. Diese Funktion findet alle fehlenden Werte im Datensatz. Anschließend zeigen wir sie mit der Funktion print() an.

! Pip Pandas installierenimportieren Pandas als pd

importieren Numpy als z.B.

# Laden Sie den Datensatz

Daten = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Zeigt die ersten Zeilen an

drucken ( Daten. Kopf ( ) )

# Auf fehlende Werte prüfen

fehlende Werte = Daten. ist Null ( ) . Summe ( )

# Anzahl der fehlenden Werte nach Spalte anzeigen

drucken ( fehlende Werte )

Nachdem wir fehlende Daten in einer Zeile gefunden haben, in der der zuvor erwähnte Code ausgeführt wird, können wir diese Zeilen entfernen, da diese Zeilen nicht viele nützliche Daten enthalten. Wir können diese fehlenden Werte sogar erraten und die Lücken mit fundierten Vermutungen füllen, indem wir die zeitbasierten Daten basierend auf nahegelegenen Punkten schätzen.

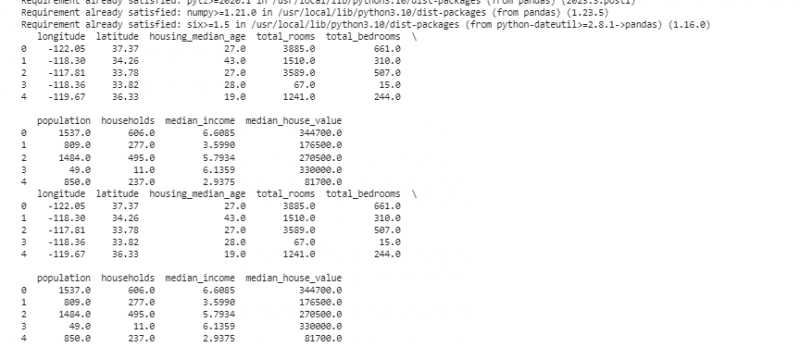

Jetzt entfernen wir die Duplikate, die Kopien desselben Dings sind, da sie unsere Analyse verwirren können. Um die doppelten Werte im Datensatz zu finden, verwenden wir die Funktion „duplicate_rows = data[data.duplicated()]“. Um diese doppelten Werte zu löschen, rufen wir die Funktion data.drop_duplicates() auf. Wir können sie mit dem folgenden Code finden und entfernen:

! Pip Pandas installierenimportieren Pandas als pd

importieren Numpy als z.B.

# Laden Sie den Datensatz

Daten = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Zeigt die ersten Zeilen an

drucken ( Daten. Kopf ( ) )

# Auf doppelte Zeilen prüfen

doppelte_Zeilen = Daten [ Daten. dupliziert ( ) ]

# Duplikate entfernen

Daten = Daten. drop_duplicates ( )

# Zeigt die ersten paar Zeilen an, nachdem Duplikate entfernt wurden

drucken ( Daten. Kopf ( ) )

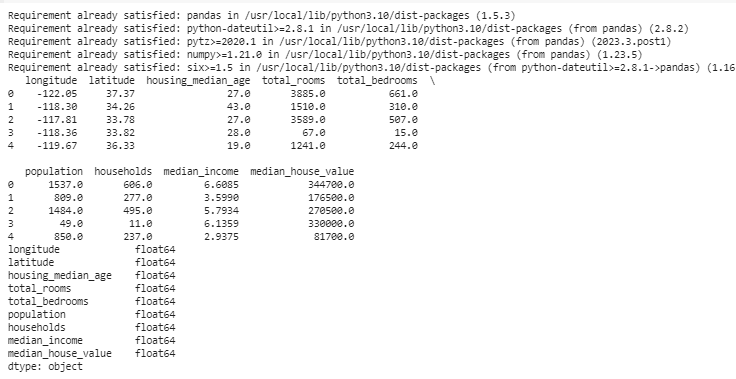

Datentypen entscheiden, welche Daten gespeichert werden können, um die Datentypen festzulegen. Es ist wichtig, für jede Art von Daten den richtigen Typ zu haben. Datumsangaben sollten beispielsweise den Datentyp „Datum/Uhrzeit“ haben und Zahlen sollten Datentypen wie int, float usw. haben. Um die Datentypen unserer Daten zu überprüfen, verwenden wir die Funktion „data.dtypes“. Diese Funktion kann auf folgende Weise genutzt werden:

! Pip Pandas installierenimportieren Pandas als pd

importieren Numpy als z.B.

# Laden Sie den Datensatz

Daten = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Zeigt die ersten Zeilen an

drucken ( Daten. Kopf ( ) )

# Überprüfen Sie die Datentypen jeder Spalte

Datentypen = Daten. dtypes

# Datentypen anzeigen

drucken ( Datentypen )

Wenn wir Probleme feststellen, können wir den Datentyp mithilfe von Pandas ändern. Beispielsweise können wir Datumsangaben in ein Datumsformat umwandeln. Das „dtypes“-Attribut eines DataFrame liefert Informationen über die Datentypen jeder Spalte. Wenn wir feststellen, dass der Datentyp nicht übereinstimmt, können wir die Funktion astype() von Pandas verwenden, um die Spalten in die gewünschten Typen zu konvertieren.

Nach den Datentypen stoßen wir manchmal auf Ausreißer, also Werte, die sich stark von den anderen unterscheiden. Sie können unsere Berechnungen durcheinander bringen. Um mit Ausreißern umzugehen, definieren wir eine Funktion, die die Z-Score-Funktion „np.abs(stats.zscore(data))“ verwendet, die die in unseren Daten vorhandenen Werte mit dem Schwellenwert vergleicht. Jeder Wert außerhalb des Bereichs dieses Schwellenwerts wird als Ausreißer betrachtet . Sehen wir uns an, wie man die Ausreißer findet und behandelt:

! Pip Pandas installierenimportieren Pandas als pd

importieren Numpy als z.B.

# Laden Sie den Datensatz

Daten = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Zeigt die ersten Zeilen an

drucken ( Daten. Kopf ( ) )

aus scipy importieren Statistiken

def discover_outliers ( Daten ) :

z_scores = z.B. Abs ( Statistiken. zscore ( Daten ) )

zurückkehren z.B. Wo ( z_scores > 3 )

# Ausreißer in der Spalte „Umsätze“ erkennen und behandeln

Ausreißer = discover_outliers ( Daten [ 'Längengrad' ] )

Daten [ 'Längengrad' ] . Ort [ Ausreißer ] = Daten [ 'Längengrad' ] . Median ( )

# Ausreißer in der Spalte „Verkaufte Einheiten“ erkennen und behandeln

Ausreißer = discover_outliers ( Daten [ 'Breite' ] )

Daten [ 'Breite' ] . Ort [ Ausreißer ] = Daten [ 'Breite' ] . Median ( )

# Zeigt die ersten Zeilen nach der Behandlung von Ausreißern an

drucken ( Daten. Kopf ( ) )

Wir verwenden eine einfache Methode, um die Ausreißer im vorherigen Code zu finden und zu beheben. Dabei werden die Extremwerte durch den Mittelwert der Daten ersetzt. Dieser Code verwendet die Z-Score-Methode, um die Ausreißer in den Spalten „Längengrad“ und „Breitengrad“ unseres Datensatzes zu erkennen. Ausreißer werden durch die Medianwerte ihrer jeweiligen Spalten ersetzt.

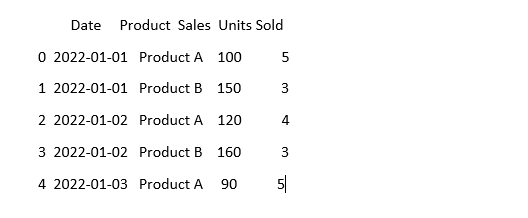

Damit die Daten gleich aussehen, können die Daten manchmal unterschiedlich aussehen, auch wenn sie dasselbe bedeuten. Beispielsweise können die Daten in verschiedenen Formaten geschrieben werden. Bei der Standardisierung geht es darum, ein konsistentes Datenformat und eine konsistente Datendarstellung sicherzustellen. Dies kann das Formatieren der Datumsangaben, das Konvertieren des Textes in Kleinbuchstaben oder das Normalisieren der numerischen Werte umfassen. Lassen Sie uns die Spalte „Datum“ in unserem Datensatz standardisieren und sicherstellen, dass unsere Daten gleich aussehen:

importieren Pandas als pdimportieren Numpy als z.B. # Numpy importieren

# Laden Sie die Daten

Daten = pd. read_csv ( 'sales_data.csv' )

# Sorgen Sie dafür, dass die Spalte „Datum“ konsistent aussieht

Daten [ 'Datum' ] = pd. to_datetime ( Daten [ 'Datum' ] )

# Sehen Sie, wie es jetzt aussieht

drucken ( Daten. Kopf ( ) )

In diesem Beispiel standardisieren wir das Datumsformat in unserem Datensatz mithilfe der Funktion „pd.to_datetime(data[‚Date‘])“ auf das Datums-/Uhrzeitformat von Python. Durch die Konvertierung der Spalte „Datum“ in das gleiche Format erleichtern wir die Arbeit mit diesen Daten. Die Ausgabe zeigt die ersten Zeilen des Datensatzes mit der standardisierten Spalte „Datum“.

Abschluss

Auf unserer Reise durch die Datenbereinigung mit Python und Pandas haben wir gelernt, wie wir unsere Daten für die Analyse verbessern können. Wir begannen damit, zu verstehen, warum die Datenbereinigung so wichtig ist. Es hilft uns, bessere Entscheidungen zu treffen. Wir haben untersucht, wie wir mit fehlenden Daten umgehen, Duplikate entfernen, die Datentypen korrigieren, mit Ausreißern umgehen und dafür sorgen, dass unsere Daten gleich aussehen. Mit diesen Fähigkeiten sind wir besser darauf vorbereitet, chaotische Daten in etwas umzuwandeln, dem wir vertrauen und das wir nutzen können, um wichtige Informationen zu entdecken. Die Datenbereinigung ist ein fortlaufender Prozess, so wie das Aufräumen unseres Zimmers, und macht unsere Datenanalyse erfolgreicher.