Die „Datasets“-Bibliothek von Hugging Face bietet eine bequeme Möglichkeit, mit den Datensätzen für Aufgaben der Verarbeitung natürlicher Sprache zu arbeiten und sie zu bearbeiten. Eine nützliche Funktion, die von der Bibliothek angeboten wird, ist concatenate_datasets(), mit der Sie mehrere Datensätze zu einem einzigen Datensatz verketten können. Im Folgenden finden Sie einen kurzen Überblick über die Funktion concatenate_datasets() und deren Verwendung.

verketten_datasets()

Beschreibung:

Die „Datasets“-Bibliothek von Hugging Face stellt die Funktion concatenate_datasets() bereit. Es wird verwendet, um mehrere Datensätze zu verketten und sie entlang einer bestimmten Achse zu einem einzigen Datensatz zu kombinieren. Diese Funktion ist besonders nützlich, wenn Sie über mehrere Datensätze mit derselben Struktur verfügen und diese zur weiteren Verarbeitung und Analyse zu einem einheitlichen Datensatz zusammenführen möchten.

Syntax:

aus Datensätze importieren verketten_datasets

verketteter_Datensatz = verketten_datasets ( Datensätze , Achse = 0 , die Info = Keiner )

Parameter:

Datensätze (Liste der Datensätze): Eine Liste der Datensätze, die Sie verketten möchten. Diese Datensätze sollten über kompatible Funktionen verfügen, was bedeutet, dass sie dasselbe Schema, dieselben Spaltennamen und dieselben Datentypen aufweisen.

Achse (int, optional, default=0): Die Achse, entlang derer die Verkettung durchgeführt werden soll. Für die meisten NLP-Datensätze wird der Standardwert 0 verwendet, was bedeutet, dass die Datensätze vertikal verkettet sind. Wenn Sie die Achse auf 1 setzen, werden die Datensätze horizontal verkettet, vorausgesetzt, dass sie unterschiedliche Spalten als Features haben.

die Info (datasets.DatasetInfo, optional): Die Informationen zum verketteten Datensatz. Wenn nicht angegeben, werden die Informationen aus dem ersten Datensatz in der Liste abgeleitet.

Kehrt zurück:

verketteter_Datensatz (Datensatz): Der resultierende Datensatz nach der Verkettung aller Eingabedatensätze.

Beispiel:

# Schritt 1: Installieren Sie die Datensatzbibliothek# Sie können es mit pip installieren:

# !pip Datensätze installieren

# Schritt 2: Erforderliche Bibliotheken importieren

aus Datensätze importieren Load_Dataset , verketten_datasets

# Schritt 3: Laden Sie die IMDb-Filmrezensionsdatensätze

# Wir verwenden zwei IMDb-Datensätze, einen für positive Bewertungen

#und noch eins für negative Bewertungen.

# Laden Sie 2500 positive Bewertungen

dataset_pos = Load_Dataset ( „imdb“ , Teilt = „Zug[:2500]“ )

# Laden Sie 2500 negative Bewertungen

dataset_neg = Load_Dataset ( „imdb“ , Teilt = „train[-2500:]“ )

# Schritt 4: Verketten Sie die Datensätze

# Wir verketten beide Datensätze wie bisher entlang der Achse=0

das gleiche Schema ( gleiche Funktionen ) .

verketteter_Datensatz = verketten_datasets ( [ dataset_pos , dataset_neg ] )

# Schritt 5: Analysieren Sie den verketteten Datensatz

# Der Einfachheit halber zählen wir die Anzahl der positiven und negativen Zahlen

# Bewertungen im verketteten Datensatz.

num_positive_reviews = Summe ( 1 für Etikett In

verketteter_Datensatz [ 'Etikett' ] Wenn Etikett == 1 )

num_negative_reviews = Summe ( 1 für Etikett In

verketteter_Datensatz [ 'Etikett' ] Wenn Etikett == 0 )

# Schritt 6: Ergebnisse anzeigen

drucken ( „Anzahl positiver Bewertungen:“ , num_positive_reviews )

drucken ( „Anzahl negativer Bewertungen:“ , num_negative_reviews )

# Schritt 7: Drucken Sie einige Beispielbewertungen aus dem verketteten Datensatz

drucken ( ' \N Einige Beispielrezensionen:' )

für ich In Reichweite ( 5 ) :

drucken ( F „Rezension {i + 1}: {concatenated_dataset['text'][i]}“ )

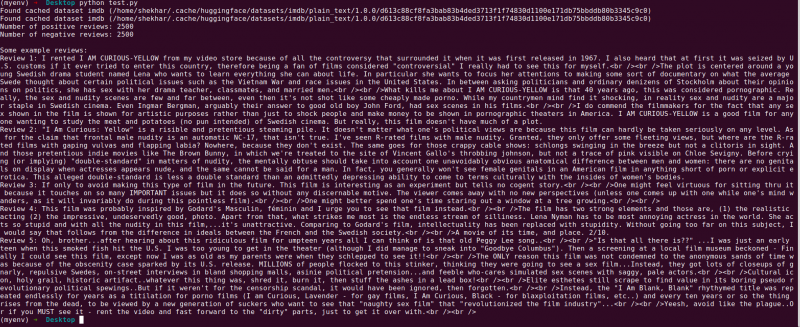

Ausgabe:

Das Folgende ist die Erklärung für das „Datensatz“-Bibliotheksprogramm von Hugging Face, das zwei IMDb-Filmrezensionsdatensätze verkettet. Dies erklärt den Zweck des Programms, seine Verwendung und die im Code enthaltenen Schritte.

Lassen Sie uns die einzelnen Schritte im Code genauer erläutern:

# Schritt 1: Erforderliche Bibliotheken importierenaus Datensätze importieren Load_Dataset , verketten_datasets

In diesem Schritt importieren wir die notwendigen Bibliotheken für das Programm. Wir benötigen die Funktion „load_dataset“, um die IMDb-Filmrezensionsdatensätze zu laden, und die Funktion „concatenate_datasets“, um sie später zu verketten.

# Schritt 2: Laden Sie die IMDb-Filmrezensionsdatensätze# Laden Sie 2500 positive Bewertungen

dataset_pos = Load_Dataset ( „imdb“ , Teilt = „Zug[:2500]“ )

# Laden Sie 2500 negative Bewertungen

dataset_neg = Load_Dataset ( „imdb“ , Teilt = „train[-2500:]“ )

Hier verwenden wir die Funktion „load_dataset“, um zwei Teilmengen des IMDb-Datensatzes abzurufen. Der „dataset_pos“ enthält 2500 positive Bewertungen und der „dataset_neg“ enthält 2500 negative Bewertungen. Mit dem Split-Parameter geben wir den Bereich der zu ladenden Beispiele an, sodass wir eine Teilmenge des gesamten Datensatzes auswählen können.

# Schritt 3: Verketten Sie die Datensätzeverketteter_Datensatz = verketten_datasets ( [ dataset_pos , dataset_neg ] )

In diesem Schritt verketten wir die beiden Teilmengen des IMDb-Datensatzes zu einem einzigen Datensatz mit dem Namen „concatenated_dataset“. Wir verwenden die Funktion „concatenate_datasets“ und übergeben ihr eine Liste, die die beiden zu verkettenden Datensätze enthält. Da beide Datensätze die gleichen Merkmale aufweisen, verketten wir sie entlang der Achse=0, was bedeutet, dass die Zeilen übereinander gestapelt sind.

# Schritt 4: Analysieren Sie den verketteten Datensatznum_positive_reviews = Summe ( 1 für Etikett In

verketteter_Datensatz [ 'Etikett' ] Wenn Etikett == 1 )

num_negative_reviews = Summe ( 1 für Etikett In

verketteter_Datensatz [ 'Etikett' ] Wenn Etikett == 0 )

Hier führen wir eine einfache Analyse des verketteten Datensatzes durch. Wir verwenden die Listenverständnisse zusammen mit der „Summen“-Funktion, um die Anzahl der positiven und negativen Bewertungen zu zählen. Wir iterieren durch die „ label“-Spalte des „concatenated_dataset“ und erhöhen die Anzahl, wann immer wir auf ein positives Label (1) oder ein negatives Label (0) stoßen.

# Schritt 5: Ergebnisse anzeigendrucken ( „Anzahl positiver Bewertungen:“ , num_positive_reviews )

drucken ( „Anzahl negativer Bewertungen:“ , num_negative_reviews )

In diesem Schritt drucken wir die Ergebnisse unserer Analyse aus – die Anzahl der positiven und negativen Bewertungen im verketteten Datensatz.

# Schritt 6: Drucken Sie einige Beispielbewertungen ausdrucken ( ' \N Einige Beispielrezensionen:' )

für ich In Reichweite ( 5 ) :

drucken ( F „Rezension {i + 1}: {concatenated_dataset['text'][i]}“ )

Abschließend präsentieren wir einige Beispielbewertungen aus dem verketteten Datensatz. Wir durchlaufen die ersten fünf Beispiele im Datensatz und drucken ihren Textinhalt mithilfe der Spalte „Text“.

Dieser Code zeigt ein einfaches Beispiel für die Verwendung der „Datensatz“-Bibliothek von Hugging Face zum Laden, Verketten und Analysieren der IMDb-Filmrezensionsdatensätze. Es unterstreicht die Fähigkeit der Bibliothek, die Verarbeitung von NLP-Datensätzen zu optimieren, und zeigt ihr Potenzial für die Entwicklung anspruchsvollerer Modelle und Anwendungen für die Verarbeitung natürlicher Sprache.

Abschluss

Das Python-Programm, das die „Datensatz“-Bibliothek von Hugging Face verwendet, demonstriert erfolgreich die Verkettung zweier IMDb-Filmkritikdatensätze. Durch das Laden der Teilmengen positiver und negativer Bewertungen kombiniert das Programm diese mithilfe der Funktion „concatenate_datasets()“ zu einem einzigen Datensatz. Anschließend wird eine einfache Analyse durchgeführt, indem die Anzahl der positiven und negativen Bewertungen im kombinierten Datensatz gezählt wird.

Die „Datensatz“-Bibliothek vereinfacht den Prozess der Handhabung und Bearbeitung der NLP-Datensätze und macht sie zu einem leistungsstarken Werkzeug für Forscher, Entwickler und NLP-Praktiker. Mit ihrer benutzerfreundlichen Oberfläche und umfangreichen Funktionalitäten ermöglicht die Bibliothek eine mühelose Datenvorverarbeitung, -exploration und -transformation. Das in dieser Dokumentation vorgestellte Programm dient als praktisches Beispiel dafür, wie die Bibliothek genutzt werden kann, um die Datenverkettung und Analyseaufgaben zu optimieren.

In realen Szenarien kann dieses Programm als Grundlage für komplexere Aufgaben der Verarbeitung natürlicher Sprache wie Stimmungsanalyse, Textklassifizierung und Sprachmodellierung dienen. Mithilfe der „Datasets“-Bibliothek können Forscher und Entwickler die umfangreichen Datensätze effizient verwalten, Experimente erleichtern und die Entwicklung modernster NLP-Modelle beschleunigen. Insgesamt stellt die „Datensatz“-Bibliothek von Hugging Face einen wesentlichen Beitrag zur Weiterentwicklung der Verarbeitung und des Verständnisses natürlicher Sprache dar.