Schwer

Zu den effektivsten und benutzerfreundlichsten Plugins zum Erstellen von Deep-Learning-Algorithmen gehört ein Python-basiertes erweitertes künstliches neuronales Framework namens Keras, das auf bekannten Deep-Learning-Frameworks wie TensorFlow oder CNTK aufgebaut wird. Um eine schnellere Erkundung unter Verwendung tieferer neuronaler Netze zu ermöglichen, ist es benutzerfreundlich, erweiterbar und anpassbar. Es verarbeitet sowohl Feedforward- als auch Retractable Networks separat sowie in Kombination. Es verwendet das Backend-Paket, um kleine Operationen zu adressieren, da es sie nicht verwalten kann. In dieser Lektion werden die Bereitstellung von Keras, Grundlagen des Deep Learning, Keras-Strukturen, Keras-Layering, Keras-Pakete und Echtzeitprogrammierung behandelt.

Richten Sie Keras unter Linux ein

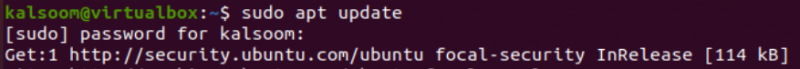

Schritt 01: System aktualisieren

Bevor wir die vollständige Demonstration der Verwendung der „Keras“-Bibliothek von Python haben, müssen wir unsere Linux-Maschine vollständig aktualisieren, um weitere Installationen zu vereinfachen. Zu diesem Zweck müssen wir schnell die Anwendung „Konsole“ aus den integrierten Anwendungen des Systems öffnen. Innerhalb des speziellen Abfragebereichs haben wir die „Update“-Abfrage von Linux mit dem „apt“-Dienstprogramm und dem „sudo“-Privileg hinzugefügt, um das vorhandene System schnell zu aktualisieren. Es hat unser Benutzerpasswort benötigt, um diesen Vorgang fortzusetzen, damit unser System ordnungsgemäß aktualisiert werden kann.

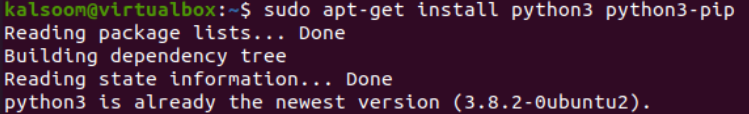

Schritt 02: Installieren Sie Python und Pip

Für die Verwendung von Deep Learning durch Keras und TensorFlow müssen wir die neueste Version von Python auf unserem Computer konfiguriert haben. Daher beginnen wir mit der Installation des aktualisierten Python-Pakets zusammen mit dem erforderlichen „pip“-Dienstprogramm auf unserem System. Dazu müssen wir erneut das „apt“-Dienstprogramm des Ubuntu 20.04-Linux-Systems in der „install“-Abfrage auf der Shell verwenden, gefolgt von den Namen der zu installierenden Pakete, dh Python3 und Python3-pip. Bei der Ausführung dieser einfachen Abfrage im Konsolenbereich beginnt das System, beide Pakete in unserem System zu installieren und zu konfigurieren.

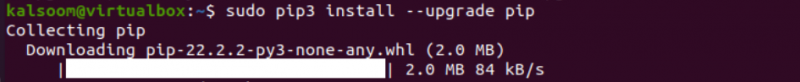

Wenn auf Ihrem System andererseits eine alte Version des Dienstprogramms „pip“ für Python installiert ist, sollten Sie es aktualisieren, bevor Sie fortfahren.

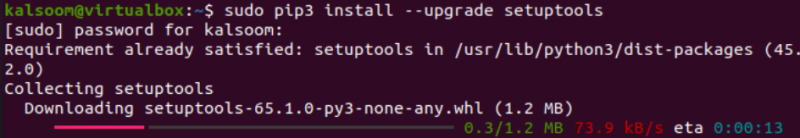

Nach der erfolgreichen Konfiguration von Python und seinem „pip“-Dienstprogramm ist es an der Zeit, die Setuptools für Python zu aktualisieren, um Probleme in naher Zukunft zu vermeiden. Daher haben wir die Installationsabfrage mit dem Dienstprogramm „pip3“ und der Option –upgrade ausprobiert, um das Upgrade der Setuptools, d. H. Setup-Tools, zu installieren. Es fragt nach dem aktuellen Passwort, das wir für unser System haben, und wir haben es hinzugefügt.

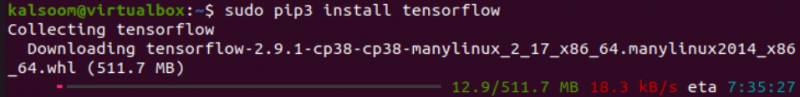

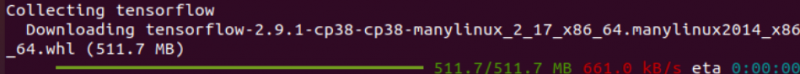

Schritt 03: Installieren Sie TensorFlow

Zum Erstellen von maschinellem Lernen und überwachten neuronalen Modellen ist TensorFlow das bekannteste symbolische Mathematikpaket. Nachdem wir die Installationen durchlaufen haben, haben wir dieselbe „pip3“-Installationsabfrage gefolgt vom „Tensorflow“-Paketnamen ausgeführt.

Andere TensorFlow-bezogene Dienstprogramme müssen vollständig auf dem System installiert sein. Diese Dienstprogramme werden zusammen mit TensorFlow installiert und es kann bis zu 10 Minuten oder länger dauern.

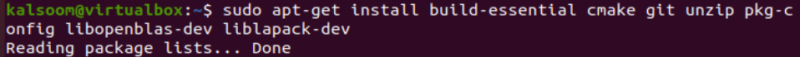

Schritt 04: Installieren Sie wichtige Pakete

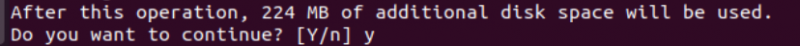

Nach der erfolgreichen Konfiguration von TensorFlow im Ubuntu 20.04-System müssen wir auch einige Build-Pakete zusammen mit einigen anderen Dienstprogrammen wie „git“ und „cmake“ konfigurieren. Indem wir dasselbe „apt“-Tool ausprobiert haben, haben wir viele der erforderlichen Pakete installiert, wie unten gezeigt:

Dieser Schritt nimmt unsere größte Aufmerksamkeit in Anspruch, indem wir diese Installation bestätigen. Tippen Sie auf „y“ und fahren Sie fort.

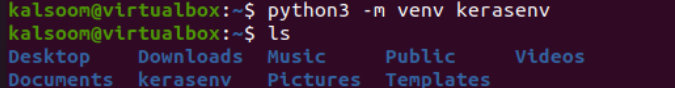

Schritt 05: Virtuelle Umgebung erstellen

Nach den notwendigen Installationen ist es an der Zeit, eine virtuelle Umgebung zu erstellen. Daher müssen wir das Python3-Dienstprogramm mit der Option „-m“ verwenden, um die virtuelle Umgebung „kerasenv“ über die Variable „venv“ zu erstellen. Die „ls“-Abfrage zeigt, dass die Umgebung erstellt wurde.

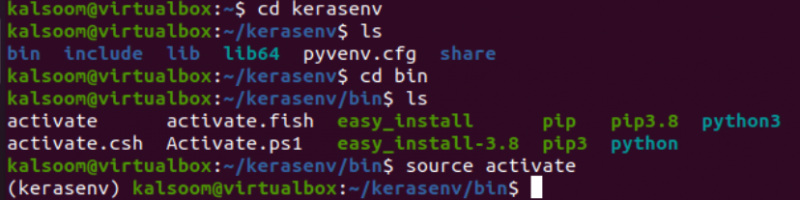

Jetzt müssen wir uns in der virtuellen Umgebung des Keras-Ordners bewegen. Wir haben also die „cd“-Anweisung zusammen mit dem Namen eines virtuellen Umgebungsordners verwendet. Danach haben wir uns innerhalb des „bin“-Ordners dieser virtuellen Umgebung bewegt und dessen Sub aufgelistet. Um diese Python-Umgebung zu aktivieren, haben wir die „source“-Anweisung in ihrem Abfragebereich zusammen mit der „activate“-Datei ausprobiert. Die virtuelle Umgebung wird mit dem Namen „kerasenv“ aktiviert.

Schritt 06: Python-Bibliotheken installieren

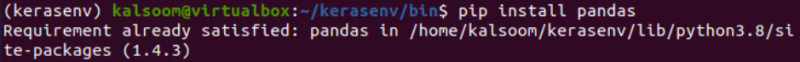

Nachdem Sie die virtuelle Python-Umgebung erfolgreich eingerichtet haben, müssen Sie vor der Installation von Keras alle erforderlichen Python-Bibliotheken installieren. Daher haben wir die Bibliothek des Pandas zuerst in derselben virtuellen Umgebung mit dem „pip“-Paket von Python installiert.

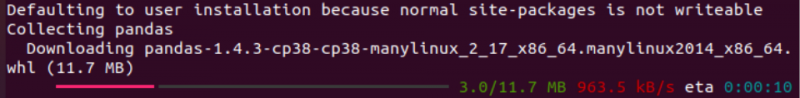

Das System beginnt mit der Konfiguration in der virtuellen Umgebung von Python, wie im Bild gezeigt:

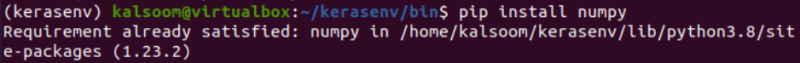

Versuchen Sie nach der Installation der Bibliothek der Pandas, die NumPy-Bibliothek mit der folgenden Methode zu installieren:

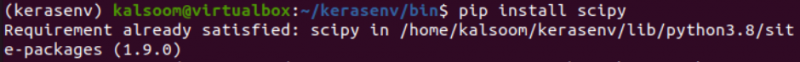

Installieren Sie auf sehr ähnliche Weise die scipy-Bibliothek von Python in derselben Umgebung.

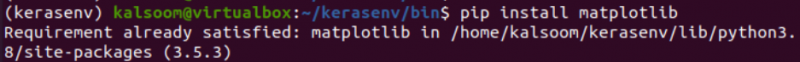

Installieren Sie nun die Matplotlib-Bibliothek von Python in der Umgebung.

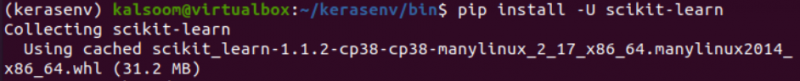

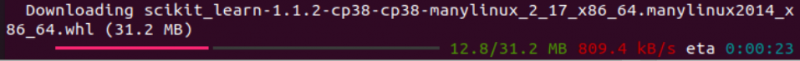

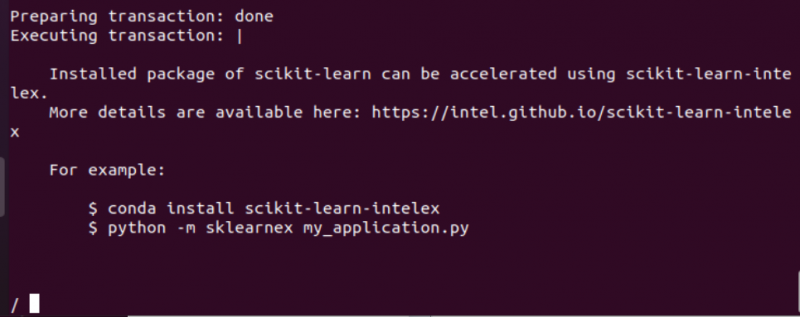

Python verwendet Clustering- und Regressionsalgorithmen beim maschinellen Lernen, um neuronale Netzwerkmodelle auszuführen. Dafür hat es die sci-kit-Learn-Bibliothek, die wir mit dem Dienstprogramm „pip“ zusammen mit der Option „-u“ installieren, um auch die erforderlichen Pakete zu konfigurieren.

Die Verarbeitung der Installation der scikit-Bibliothek wurde unten gezeigt:

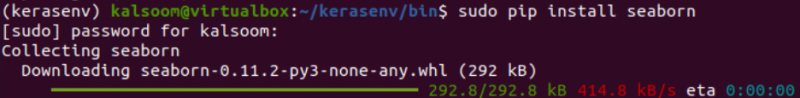

Für die Visualisierung im Deep Learning benötigen wir die installierte Seaborn-Bibliothek von Python. Daher haben wir es in derselben Umgebung mit der Abfrage „install“ installiert.

Schritt 07: Installieren Sie die Keras-Bibliothek

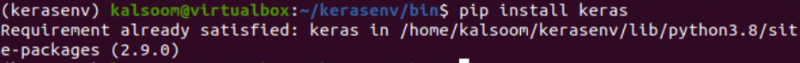

Nach der Installation aller erforderlichen erforderlichen Bibliotheken von Python können wir endlich Keras in der virtuellen Umgebung von Python installieren. Das Dienstprogramm „pip“ wird zu diesem Zweck innerhalb unserer „install“-Abfrage mit dem Modulnamen, d. h. „Keras“, verwendet. Wenn das System anzeigt, dass seine Anforderung bereits erfüllt ist, bedeutet dies, dass es bereits installiert und konfiguriert ist.

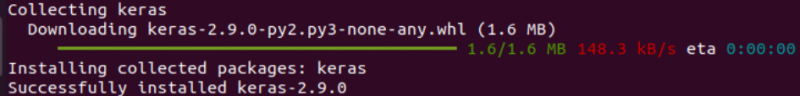

Wenn es noch nicht installiert ist, beginnt diese Abfrage ohne eine Verzögerung von einer Sekunde mit dem Herunterladen und Konfigurieren in der virtuellen Umgebung, und die Verarbeitung wird wie folgt angezeigt:

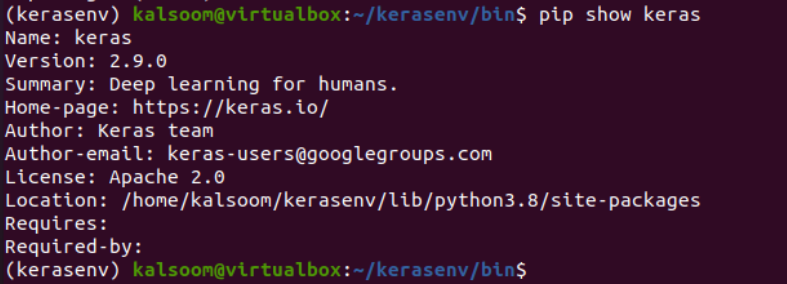

Nach der vollständigen Konfiguration und Installation der „Keras“-Bibliothek in der virtuellen Umgebung ist es an der Zeit, die vollständigen Informationen dazu auf der Shell über die Abfrage „pip show“ anzuzeigen. Die Ausführung dieser „show“-Abfrage hat die Version von Keras präsentiert, die in unserer virtuellen Umgebung von Python installiert ist, seinen Namen, seine Zusammenfassung, seine Web-Homepage, den Autor, die E-Mail-Adresse des Autors, die Lizenz, den Speicherort, den es auf unserem System einnimmt, und vieles mehr mehr wie unten dargestellt:

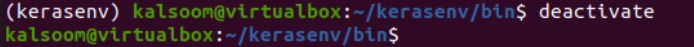

Nach den besten Installationen der Keras- und TensorFlow-Bibliotheken von Python müssen wir die virtuelle Umgebung verlassen. Probieren Sie dazu die Abfrage „Deaktivieren“ auf der Shell aus und beenden Sie sie.

Schritt 08: Installieren Sie Anaconda Cloud

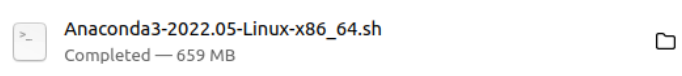

Python hat eine Cloud namens „Anaconda“, die notwendig ist, um Beispiele für neuronale Netzwerke in Python zu erstellen. Daher haben wir seine Ausführungsdatei auf unser System heruntergeladen.

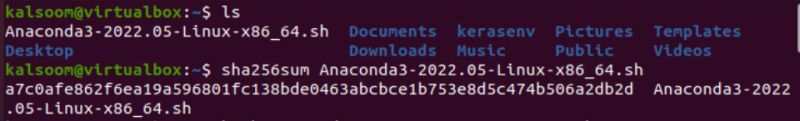

Diese Datei befindet sich gemäß der „ls“-Abfrage im aktuellen Home-Ordner des Linux-Computers. Sie müssen zuerst sicherstellen, dass es sich um eine Prüfsumme handelt, dh ob sie vollständig korrekt ist oder nicht, über die sha256sum-Abfrage.

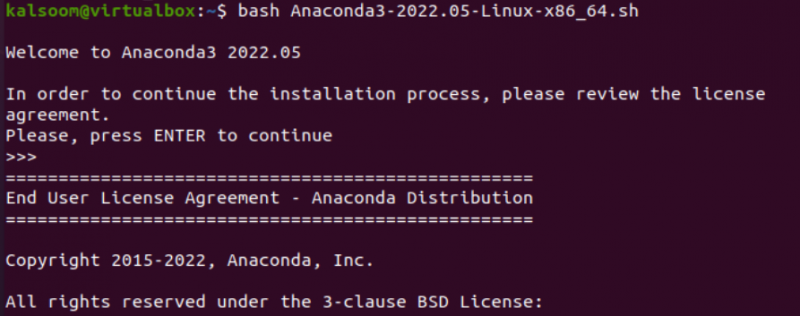

Danach müssen wir die heruntergeladene Bash-Datei von Anaconda in unserem System installieren, indem wir die Anweisung „Bash“ und den Dateinamen auf derselben Konsole verwenden. Es hat uns gebeten, die Lizenzvereinbarung vor der Installation zu überprüfen. Also haben wir auf „Enter“ getippt, um fortzufahren.

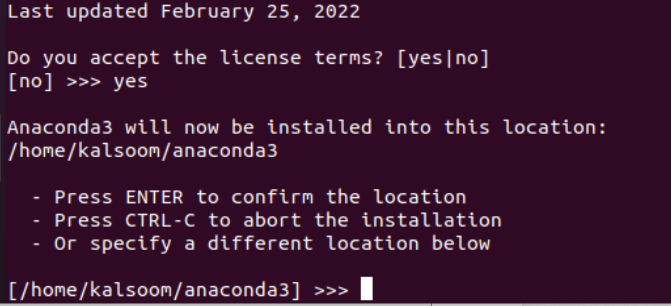

Nachdem wir die Lizenzvereinbarung durchlaufen haben, werden wir aufgefordert, auf „Ja“ zu tippen, wenn wir den Bedingungen zustimmen. Sie müssen die Eingabetaste drücken, um die Installation an derselben Stelle fortzusetzen, oder den Pfad zu dem Verzeichnis eingeben, in dem Sie es installieren möchten. Verwenden Sie andernfalls „Strg-c“, um die Installation abzubrechen.

Es wird die lange Liste der Pakete angezeigt, die in diesem Prozess installiert werden. Nach einigen Transaktionsausführungen beginnt es mit der Installation der Pakete.

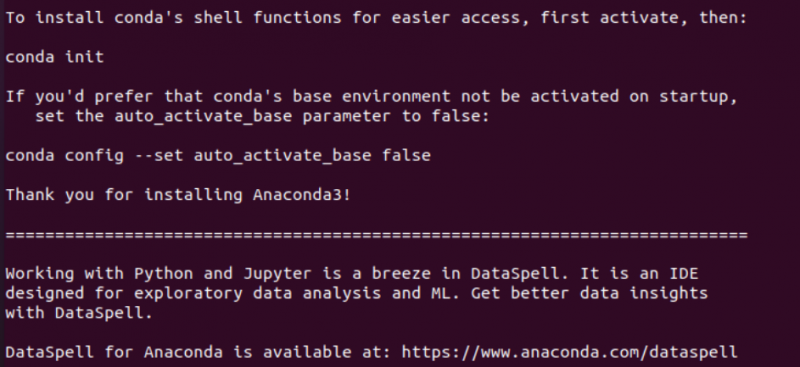

Nach einer Weile wurde Anaconda mit seinen zusätzlichen Paketen erfolgreich installiert.

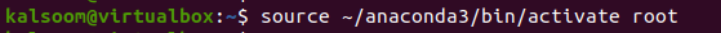

Sie müssen die „activate“-Datei aus dem Anaconda-Ordner über die „source“-Abfrage als Root ausführen.

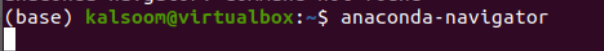

Versuchen Sie, den Anaconda-Navigator mit der folgenden Abfrage zu starten.

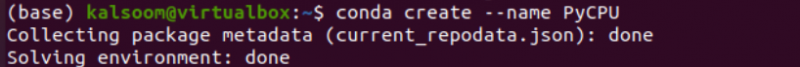

Um die neue Conda-Umgebung zu erstellen und daran zu arbeiten, versuchen Sie die Anweisung „conda create“ mit der Namensoption gefolgt vom neuen Umgebungsnamen, d. h. PyCPU.

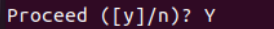

Dieser Prozess erfordert unsere Bestätigung über die Erstellung der neuen Umgebung. Tippen Sie auf „j“.

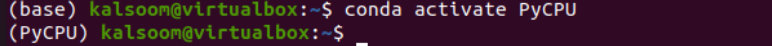

Um die neu erstellte Conda-Umgebung zu aktivieren und auszuführen, verwenden Sie die Abfrage „conda activate“ mit dem Namen Ihrer neuen Umgebung, d. h. die PyCPU-Umgebung ist jetzt aktiviert.

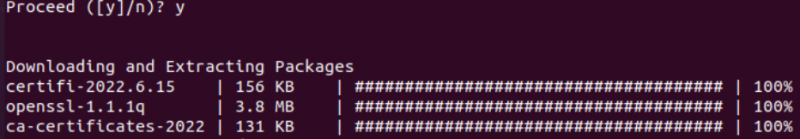

Schritt 09: Installieren Sie Spyder IDE

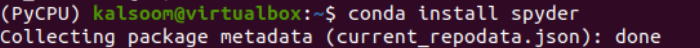

Innerhalb dieser Umgebung muss die Spyder IDE zur Ausführung von Python-Programmen installiert werden. Dazu haben wir die Conda-Installationsabfrage an der PyCPU-Umgebungs-Shell mit dem Schlüsselwort „spyder“ ausprobiert.

Tippen Sie auf „y“, um mit der Installation von Spyder fortzufahren.

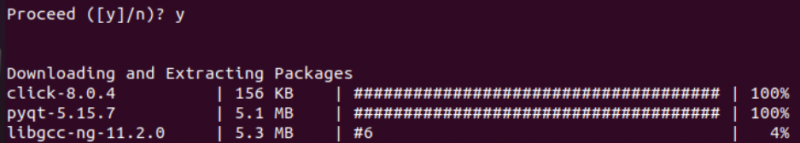

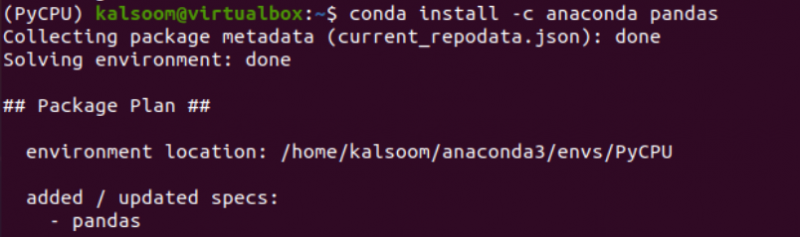

Schritt 10: Installieren Sie die Pandas- und Keras-Bibliothek

Installieren Sie nach der Installation von Spyder die Panda-Bibliothek von Python in einer Anaconda-Umgebung, indem Sie die Conda-Installationsabfrage mit der Option –c verwenden.

Drücken Sie erneut die Schaltfläche „y“, um fortzufahren.

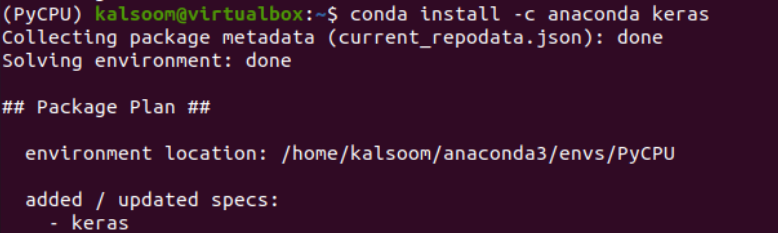

Installieren Sie nach der erfolgreichen Konfiguration von Pandas die Keras-Bibliothek mit der gleichen Abfrage.

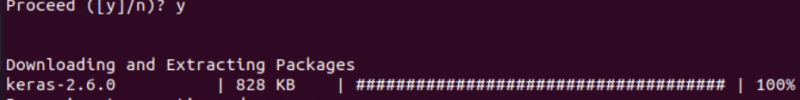

Fahren Sie fort, nachdem Sie auf die Schaltfläche „y“ geklickt haben.

Sie können die Spyder-IDE in der aktuellen Umgebungskonsole von Anaconda wie folgt starten:

Die Spyder-IDE hat sich auf den Start vorbereitet.

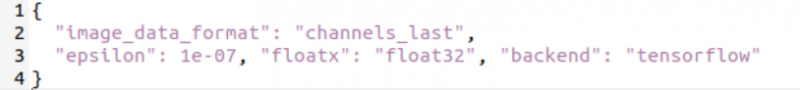

Der versteckte Ordner „.keras“ befindet sich im Home-Verzeichnis. Blenden Sie es ein und öffnen Sie die Datei „keras.json“, um die folgenden Konfigurationen hinzuzufügen.

Richten Sie Keras und TensorFlow unter Windows ein

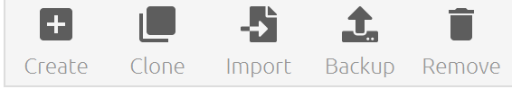

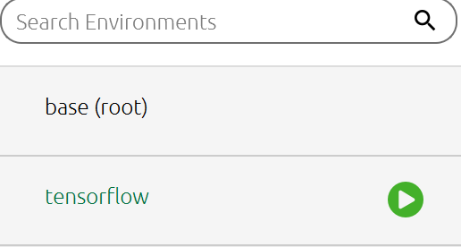

Um Keras und TensorFlow in einer Windows-Umgebung einzurichten, müssen Sie sicherstellen, dass die Python-Sprache zusammen mit ihrer „pip“-Bibliothek und Anaconda Navigator bereits darauf eingerichtet ist. Nachdem Sie es eingerichtet haben, sollten Sie es von Ihrem Suchbereich aus öffnen und sich innerhalb der Registerkarte „Umgebungen“ bewegen. Auf dieser Registerkarte finden Sie den Umgebungsnamen, in dem Sie gerade arbeiten, z. B. base. Im unteren Bereich finden Sie den folgenden Reiter. Tippen Sie auf die Option „Erstellen“.

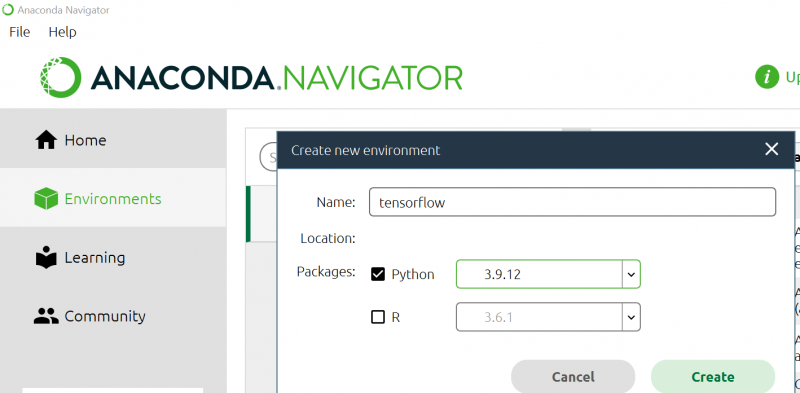

Hier müssen Sie einen neuen Umgebungsnamen „TensorFlow“ erstellen, d. H. Sie befinden sich derzeit in der Basisumgebung. Wählen Sie die neueste Version von Python aus, die verwendet werden soll, und tippen Sie auf die Schaltfläche „Erstellen“, um fortzufahren.

Sie werden sehen, dass das Laden der Umgebung begonnen hat.

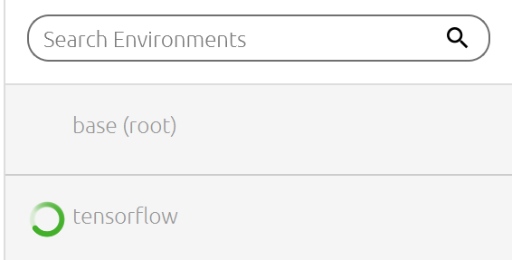

Nach einer Weile wird die TensorFlow-Umgebung vollständig installiert.

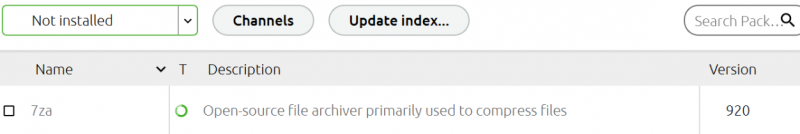

Im Bereich ganz links können Sie alle installierten und verfügbaren Bibliotheken und Module für Python sehen, wie unten dargestellt:

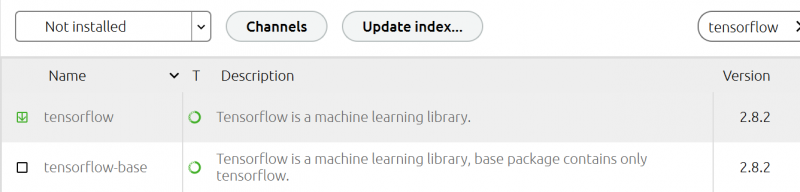

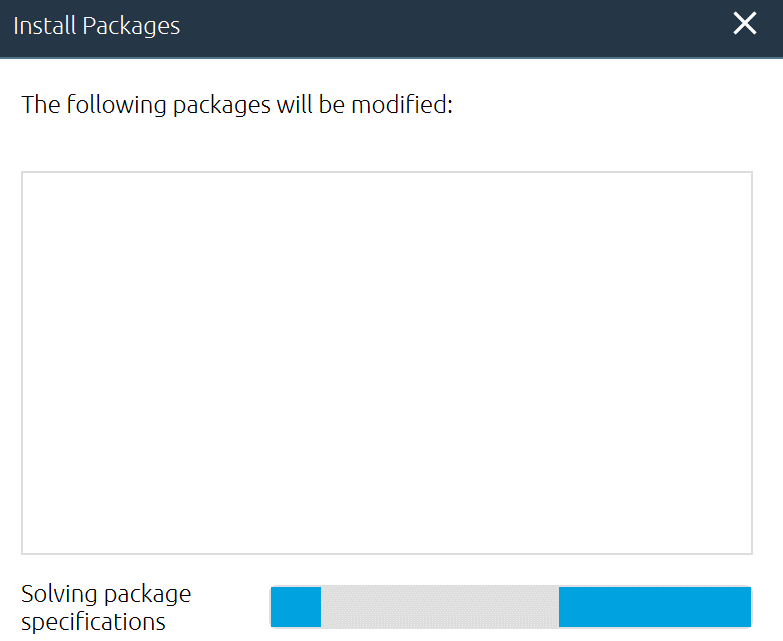

Jetzt müssen wir die TensorFlow-Backend-Bibliothek von Python über diesen Bereich installieren. Schreiben Sie in die Suchleiste „TensorFlow“ und markieren Sie dasselbe Fallpaket aus der angezeigten Liste, um es zu installieren. Tippen Sie auf die Schaltfläche „Übernehmen“, um mit der Installation von TensorFlow zusammen mit seinen Untermodulen wie „Keras“ fortzufahren.

Es hat begonnen zu arbeiten und den TensorFlow in unserer Anaconda-Umgebung zu konfigurieren.

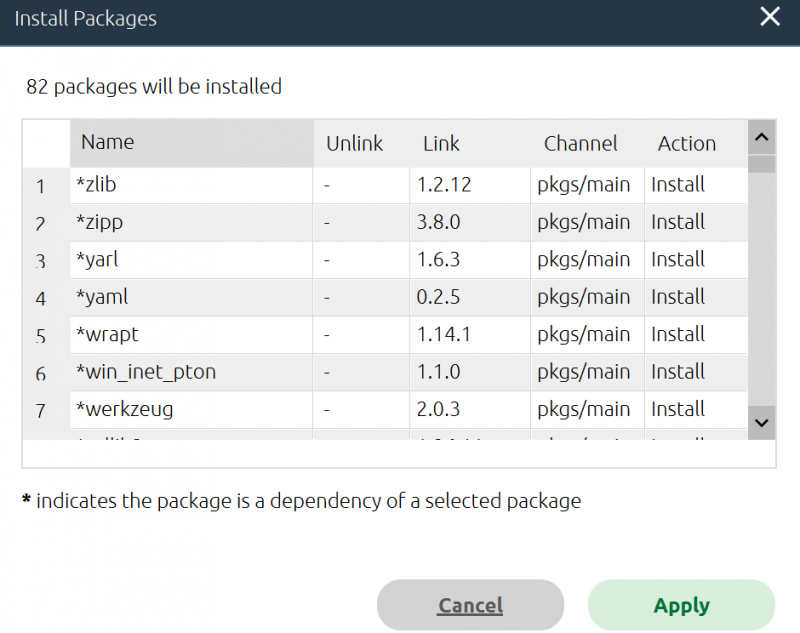

Während der Installation wird die Liste der Unterpakete angezeigt, die in der Anaconda-Umgebung installiert werden. Tippen Sie auf die Schaltfläche „Übernehmen“ und warten Sie eine Weile, bis der Vorgang abgeschlossen ist.

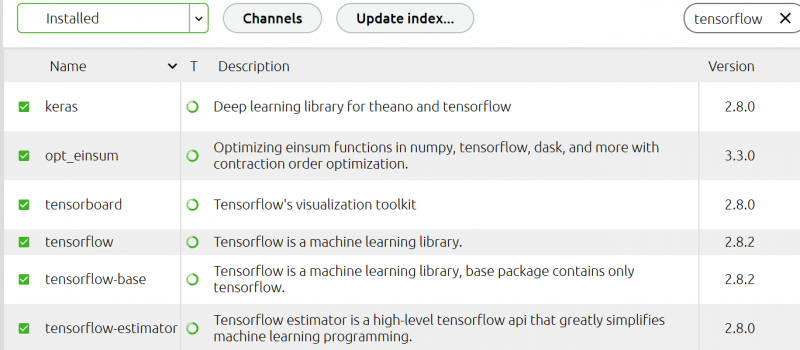

Nach einer Weile finden Sie alle installierten Pakete im selben Modulbereich. Sie können sehen, dass die Keras-Bibliothek mit anderen Paketen installiert wurde und wir sie jetzt nicht installieren müssen.

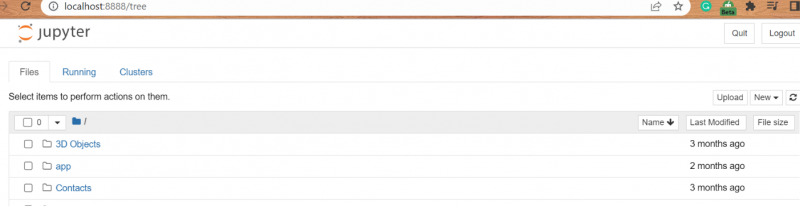

Suchen Sie in der Windows-Suchleiste nach dem Schlüsselwort „Jupyter“. Die Anwendung mit dem Namen „Jupyter Notebook (TensorFlow)“ wird zusammen mit anderen angezeigt. Tippen Sie darauf, um das Jupyter Notebook mit aktiviertem Backend TensorFlow zu starten. Erstellen Sie eine neue Python-Datei und beginnen Sie mit der Arbeit.

Deep Learning über Hard

Deep Learning umfasst eine Schicht-für-Schicht-Analyse der Aufnahme, wobei jede Schicht nach und nach fortgeschrittene Details aus der Eingabe extrahiert. Ein vollständiges Framework wird von Keras bereitgestellt, um jede Art von neuronalem Netzwerk zu bilden. Sowohl kreativ als auch unglaublich einfach zu verstehen, Keras. Es ermöglicht neuronale Netzwerkmodelle, die von den naivsten bis zu den größten und höchsten Komplexen reichen.

Künstliches neuronales Netzwerk (ANN)

Die Methodik des „Artificial Neural Network“ (ANN) scheint die am weitesten verbreitete und grundlegendste Methode des Deep Learning zu sein. Sie orientieren sich am menschlichen Geist, der kompliziertesten natürlichen Komponente unseres Körpers, der ihnen als Modell dient. Über 90 Milliarden mikroskopisch kleine Zellen, sogenannte „Neuronen“, bilden das Gehirn eines Individuums. Axone und Dendriten sind Arten von Nervenfasern, die Neuronen miteinander verbinden. Die Hauptfunktion eines Axons besteht darin, Daten von einem verbundenen Neuron zum nächsten zu senden. Für weitere Informationen suchen Sie bitte in der Google-Suchmaschine.

Keras-Architektur

Die Keras-API-Architektur wurde in die drei unten aufgeführten Hauptteile eingeteilt. Lassen Sie uns einen Blick auf jeden einzelnen werfen.

- Modell

- Schicht

- Kern Module

Hartes Modell

Das Keras-Modell besteht aus genau zwei Typen, nämlich einer sequentiellen und einer funktionalen API.

Sequenzielles Modell

Grundsätzlich ist ein sequentielles Modell eine chronologische Zusammenstellung von Keras-Schichten. Das einfache, vereinfachte sequentielle Modell kann fast alle derzeit verwendeten neuronalen Netze beschreiben. Ein benutzerdefiniertes Modell kann unter Verwendung der Model-Klasse erstellt werden, die das sequentielle Modell offenbart. Der Ansatz der Unterklassifizierung kann verwendet werden, um ein ausgeklügeltes eigenes Modell zu erstellen. Die Demonstration des sequentiellen Modells wurde unten präsentiert.

Ebenen hinzufügen

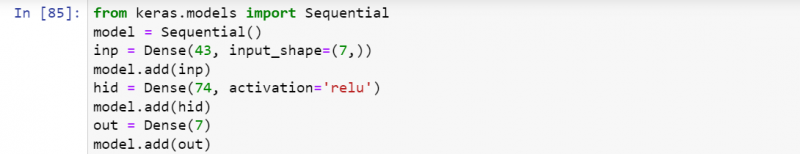

Das Skript wurde vom Import des sequentiellen Modus über die keras.models gestartet und die andere Zeile hat ein sequenzielles Modell erstellt. Danach wird durch das Importieren des dichten Layers ein Eingabelayer erstellt und einem Modell ein Eingabelayer hinzugefügt. Die verborgene dichte Schicht wurde erstellt und dem Modell hinzugefügt, und dasselbe wurde für die dichte Ausgabeschicht durchgeführt.

Greifen Sie auf das Modell zu

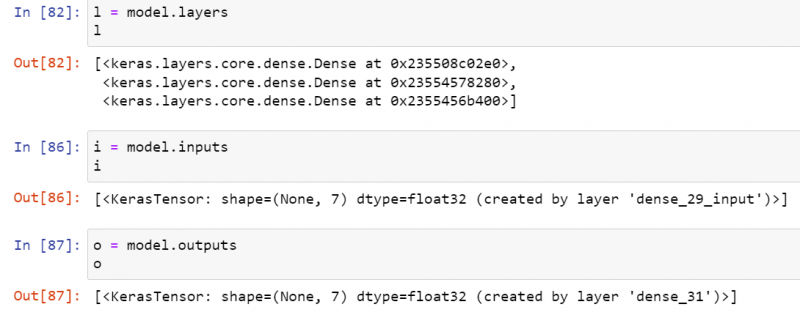

Sie können Informationen zu Ihren Modellebenen, den verwendeten Eingabedaten und den Ausgabedaten abrufen. Mit der Funktion model.layers können Sie auf alle Ebenen zugreifen. Die model.inputs würden Eingabetensoren anzeigen, und model.output zeigt Ausgabetensoren an.

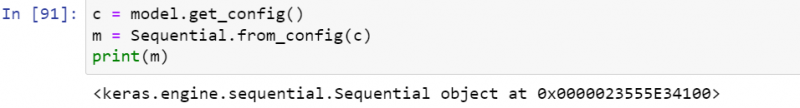

Serialisieren Sie das Modell

Es ist einfach, das im Skript verwendete Modell als Objekt oder JSON zurückzugeben. Beispielsweise liefert die Funktion get_config() das Modell als Entität/Objekt. Die Funktion from_config() erstellt ein neues Modell unter Verwendung des Objekts als parametrischen Wert.

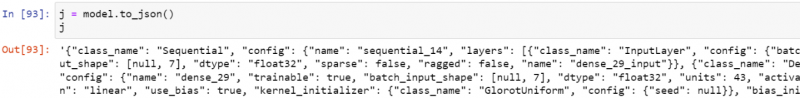

Sie können Ihr Modell auch mithilfe der Funktion to_json() in JSON ändern.

Modellzusammenfassung

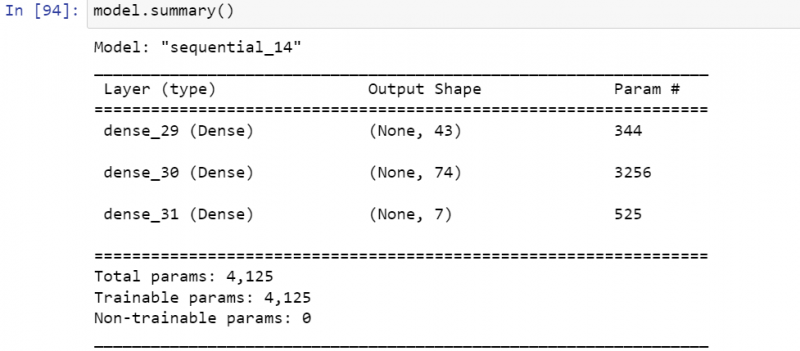

Rufen Sie die Funktion summary() auf, um die vollständige Zusammenfassung der im Modell verwendeten Layer zusammen mit einigen zusätzlichen Informationen zu erhalten.

Modell trainieren und vorhersagen

Um zu trainieren und vorherzusagen, sollten wir in dieser Hinsicht die Kompilierungsfunktion, die Anpassungsfunktion, die Funktion auswerten und die Funktion vorhersagen.

Harte Schichten

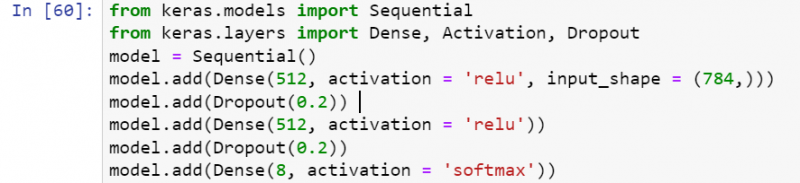

Jede Eingabe-, verdeckte und Ertragsschicht im vorgeschlagenen Modell neuronaler Netze entspricht einer anderen Keras-Schicht im realen Modell. Jedes ausgeklügelte neuronale Netzwerk kann schnell entwickelt werden, indem viele vorgefertigte Schichten der Keras-Bibliothek verwendet werden. Wir haben verschiedene Keras-Schichten, d. h. Kernschichten, Pooling-Schichten, wiederkehrende Schichten und Faltungsschichten. Sie können sie studieren, indem Sie im Internet suchen. Die ersten beiden Zeilen haben den Sequential Mode, Dense, Activation und Dropout Layer importiert.

Wir haben die Sequential()-API ausprobiert, um ein sequenzielles Dropout-Modell zu erstellen. Durch das Ablegen des Aktivierungsmodells „relu“ haben wir über die „Dense“-API eine dichte Schicht geschaffen. Um der Überanpassung der dichten Schicht Rechnung zu tragen, haben wir die Dropout()-API verwendet, d. h. Dropout-Layering über die dropout()-Funktion. Danach verwenden wir hier mit dem Aktivierungsmodell „relu“ eine dichtere Schicht. Um die dichten Schichten durch Überanpassung zu handhaben, müssen wir Dropout-Schichten verwenden. Am Ende haben wir unsere letzten dichten Schichten mit dem Aktivierungsmodell vom Typ „Softmax“ abgeworfen.

Haben Sie schon einmal während des Kochens geschichtet? Wenn ja, dann wäre dieses Konzept für Sie nicht schwer zu verstehen. Das Ergebnis einer Ebene dient als Eingabedaten für die nachfolgende Ebene. Hier sind die grundlegenden Dinge, die zum Erstellen einer ganz neuen Ebene erforderlich sind:

- Form der Eingabedaten

- Gesamtzahl Neuronen/Einheiten in einer Schicht

- Initialisierer

- Regularisierer

- Einschränkungen

- Aktivierungen

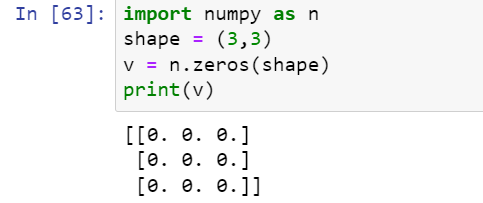

Form der Eingabedaten

Innerhalb der Python-Sprache wurde jede Art von Eingabe in ein Array von Ganzzahlen umgewandelt und dann dem Algorithmusmodell hinzugefügt. Innerhalb von Python müssen wir die Eingabeform angeben, um die Ausgabe gemäß unserer Anforderung zu erhalten. In den folgenden Beispielen haben wir die Eingabeform (3,3) angegeben, also 3 Zeilen und 3 Spalten. Die Ausgabe hat die Matrix angezeigt.

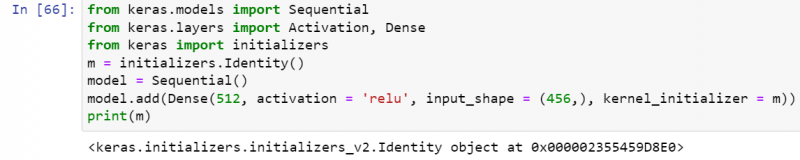

Initialisierer

Das Initializers-Modul von Keras Layers bietet uns viele Funktionen, um ein bestimmtes Gewicht für Eingabedaten festzulegen. Beispielsweise gibt die Funktion zeros() 0 für alle an, die Funktion ones() würde für alle angeben, und die Funktion constant() gibt einen bestimmten konstanten Wert an, der von einem Benutzer für alle und mehr hinzugefügt wird. Zum besseren Verständnis haben wir die Funktion identity() verwendet, um eine Identitätsmatrix zu erzeugen. Die restlichen Funktionen können auch über die Suchmaschine durchsucht werden.

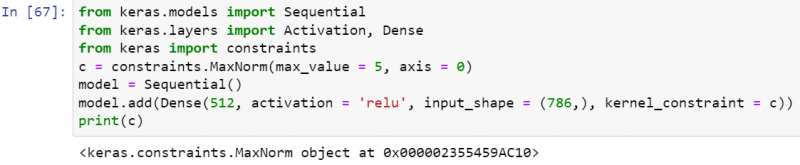

Einschränkungen

Es stehen verschiedene Beschränkungsfunktionen zur Verfügung, um Beschränkungen auf den Parameter „Gewicht“ der Ebene anzuwenden, d. h. nicht negativ, Einheitsnorm, maximale Norm, minmaxnorm und viele mehr. In der folgenden Abbildung haben wir die Einschränkungsnorm kleiner oder gleich der Gewichtung angewendet. Der Parameter „max_value“ ist die Obergrenze der anzuwendenden Einschränkung und die Achse ist die Dimension, auf die die Einschränkung angewendet werden würde, d. h. Dimension 1.

Regularisierer

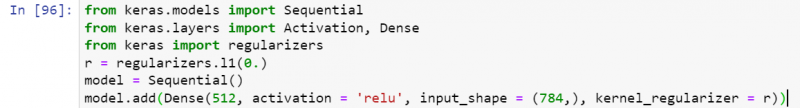

Während der gesamten Optimierung werden der Schichteigenschaft verschiedene Belastungen auferlegt. Es hat auch einige Funktionen dafür entwickelt, d. H. L1-Regulator, L2-Regulator und „LI-und-L2“-Regulator. Hier ist die einfachste Illustration der L1-Regularizer-Funktion:

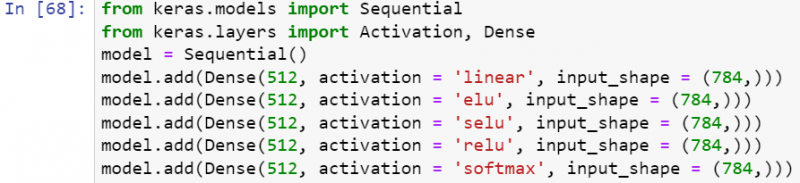

Aktivierungen

Eine einzigartige Funktion, die als Aktivierungsfunktion bezeichnet wird, wird verwendet, um zu bestimmen, ob ein bestimmtes Neuron aktiv ist oder nicht. Die Aktivierungsfunktion wandelt die eingehenden Daten auf komplexe Weise um, was den Neuronen hilft, effektiver zu lernen. Hier sind mehrere Aktivierungsmethoden, die in den folgenden Beispielen vorgestellt werden:

Harte Module

Wie wir wissen, enthalten Programmiermodule normalerweise Funktionen, Klassen und Variablen, die für verschiedene und spezifische Zwecke verwendet werden. Genauso enthält die Keras-Bibliothek von Python viele Module. Alle erforderlichen Kenntnisse zu den Keras-Modulen erhalten Sie im Internet.

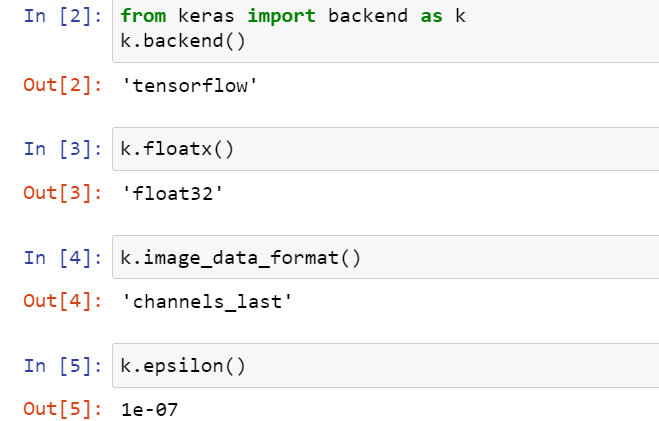

Backend

Eines der bekanntesten und am häufigsten verwendeten Module ist das „Backend“-Modul, das entwickelt wurde, um die Backend-Bibliotheken von Python wie TensorFlow und Theano zu verwenden. Mit dem Backend-Modul können wir so viele Backend-Funktionen wie möglich aus der TensorFlow- und Theano-Bibliothek nutzen. Um das Backend-Bibliotheksmodul zu verwenden, müssen wir die zu verwendende Backend-Bibliothek in der Konfigurationsdatei „keras.json“ angeben, die wir im versteckten Ordner .keras erstellt haben. Standardmäßig wurde das Backend als „TensorFlow“ angegeben, aber Sie können es auch in ein anderes ändern, z. B. Theano oder CNTK.

In unserem Beispiel verwenden wir die TensorFlow-Bibliothek als Backend. Um die Konfigurationen des Backends aus der Datei keras.json des Stammordners „keras“ zu laden, verwenden Sie:

- aus dem Keras-Import-Backend als k

Nach dem erfolgreichen Import des Backends aus der Datei keras.json ist es an der Zeit, die Backend-Informationen mithilfe der Variablen „k“ mit der abzurufenden Variable abzurufen. Zuerst haben wir den Namen eines Backends abgerufen, das wir verwendet und bereits mit der Funktion „backend()“ importiert haben. Es gibt den „Tensorflow“ als seinen Backend-Wert zurück. Um den Float-Wert des Backends zu erhalten, haben wir die floatx()-Funktion über das „k“-Variablenobjekt von Keras aufgerufen. Es zeigt, dass wir den Float32-Wert verwendet haben.

Um das Format der Bilddaten zu erhalten, verwenden Sie die Funktion image_Data_format() mit der Variablen „k“. Bei der Verwendung zeigt sich, dass unser Backend das Bilddatenformat „channels_last“ verwendet hat. Um die Potenz des Exponenten für das Backend zu erhalten, rufen Sie die Funktion epsilon() mit der Variablen „k“ auf. Es gibt zurück, dass das Backend die exponentielle Potenz von „07“ verwendet. Das ist alles über das Abrufen von Backend-Informationen.

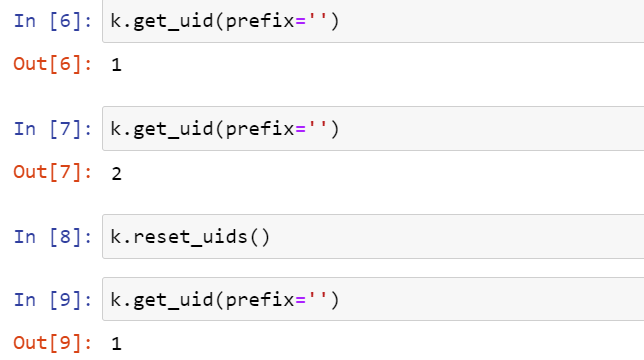

Get_uid()-Funktion

Es ist an der Zeit, sich einige Backend-Funktionen von TensorFlow anzusehen, um seine Funktionsweise zu verstehen. Eine der am häufigsten verwendeten Backend-Funktionen ist die Funktion „get_uid()“, mit der das von uns verwendete Standarddiagramm identifiziert wird. Die Verwendung mit dem Parameter prefix=’’ würde „1“ zurückgeben, d. h. gemäß der Verwendung. Auch hier würde die Verwendung „2“ zurückgeben, da wir es erneut aufgerufen haben und der Wert des Diagramms erhöht wurde. Nach der Verwendung der Funktion „reset_uids“ würde der Benutzer-ID-Wert des Diagramms auf 0 zurückgesetzt. Daher würde die erneute Verwendung der Funktion get_uid() ihn um 1 erhöhen.

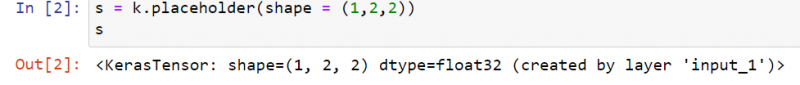

Placeholder()-Funktion

Der Tensor hat die Funktion placeholder() verwendet, um verschiedene dimensionale Formen darin zu halten. In der folgenden Abbildung haben wir es beispielsweise verwendet, um das 3D-Bild über die Keras-Variable „k“ im Tensor zu halten und es in einer anderen Variablen „d“ zu speichern. Die Ausgabe der Variablen „d“ zeigt die Eigenschaften einer Form, die innerhalb des Platzhalters verwendet wird.

Die Funktion „int_shape()“ dient dazu, die Form eines im Platzhalter „d“ gespeicherten Wertes anzuzeigen.

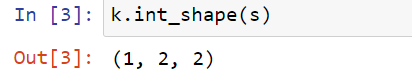

Dot()-Funktion

Hast du schon einmal zwei Vektoren multipliziert? Wenn ja, wird es für Sie keine Herausforderung sein, zwei Tensoren zu multiplizieren. Dafür hat sich die Backend-Bibliothek die „Punkt“-Funktion ausgedacht. Um die beiden unterschiedlichen Formen zu halten, haben wir zunächst die Formwerte in der Funktion placeholder() in den ersten beiden Zeilen verwendet, um zwei Halter „x“ und „y“ zu erstellen. Die Funktion dot() hat die Halter „x“ und „y“ genommen, um beide Tensoren zu multiplizieren und das Ergebnis in einer anderen Variablen „z“ zu speichern. Bei Verwendung des „z“-Tensors zum Drucken wurde die multiplizierte resultierende Tensorform (1, 5) auf dem Bildschirm angezeigt.

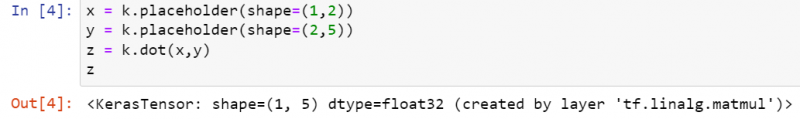

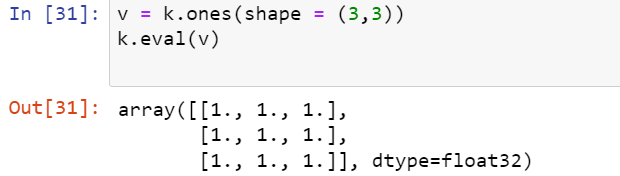

Ones()-Funktion

Die ones()-Funktion des Backend-Moduls ist dafür bekannt, alle Werte einer bestimmten Form auf 1 zu initialisieren. Zum Beispiel haben wir die ones()-Funktion für die Tensorform (3,3) verwendet und das Ergebnis in gespeichert die Variable „v“. Die Funktion eval() wird hier abgeworfen, um den Wert einer Variablen „v“ auszuwerten und in der Python-Umgebung anzuzeigen. Im Gegenzug hat es die Form (3,3) in eine Array-Matrix aus lauter Einsen mit dem Datentyp float32 konvertiert.

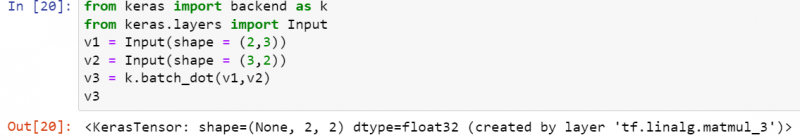

Batch_dot()-Funktion

Der Tensor-Batch würde die Gesamtzahl der zu sortierenden Stichproben angeben, bevor ein Modell aktualisiert wird. Die Funktion batch_dot() des TensorFlow-Backends wird hauptsächlich verwendet, um das Multiplikationsergebnis zweier verschiedener Batch-Daten herauszufinden. Daher haben wir zwei Tensorvariablen v1 und v2 erstellt und die Funktion Input() verwendet, um sie in v1 und v2 als Eingabe zu speichern. Danach haben wir die Funktion batch_dot() für beide Tensorvariablen v1 und v2 ausprobiert, und der resultierende Wert wurde in einer anderen Variablen „v3“ gespeichert. Beim Drucken der Variablen v3 haben wir im Gegenzug die resultierende Form (2,2) gefunden.

Variable Funktion

Wenn Sie jemals mit einer anderen Sprache gearbeitet haben, haben Sie vielleicht viele Variablen mit dem Schlüsselwort „var“ oder ohne es initialisiert. Häufig haben Sie die Variablen möglicherweise mit ihren Datentypen wie Integer, Zeichenfolge oder Zeichen initialisiert. Innerhalb der Python-Keras-Bibliothek können wir jede Variable mit der Funktion variable() für einige Tensordaten in Form von Beispielen erstellen.

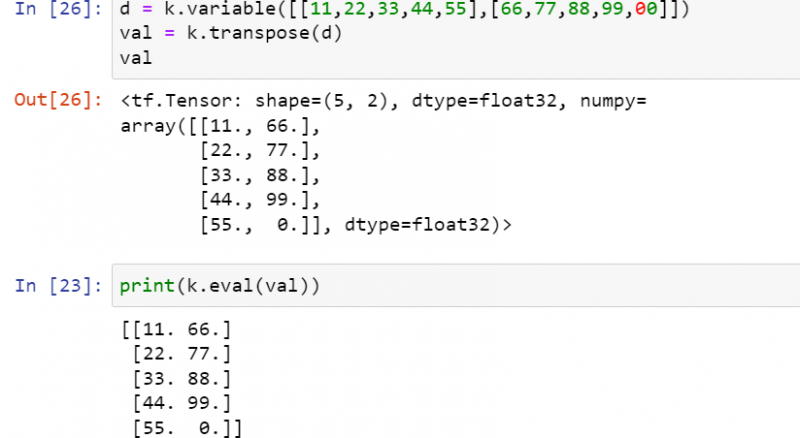

In der folgenden Abbildung haben wir eine Variable „d“ erstellt, indem wir die zwei Beispiellistendaten in eine variable()-Funktion mit dem Keras-Objekt „k“ eingefügt haben. Nachdem wir diese Variable hinzugefügt haben, haben wir die transpose()-Funktion für diese Variable „d“ aufgerufen, um die Transponierung von darin enthaltenen Sample-Daten über das Keras-Objekt „k“ herauszufinden. Die resultierende Transponierung würde in einer Variablen „val“ gespeichert. Die print-Anweisung der Python-Sprache wurde hier verwendet, um den Wert der resultierenden Variablen „val“ zu drucken. Die print-Anweisung zeigt die Wahl der Funktion, die wir auf die Variable „d“ angewendet haben, und die Gesamtzahl der Elemente in jeder Liste.

Danach haben wir die „eval“-Funktion für die „val“-Variable ausprobiert, um die Transponierung der Samples zu erhalten, die der Variablen „d“ hinzugefügt wurden, und die Druckfunktion zeigte sie an. Sie können die Transponierung von zwei Listen in der Ausgabe sehen.

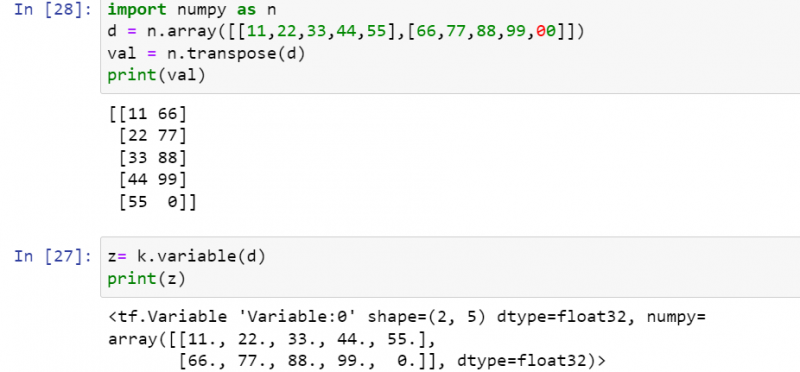

Die vorherige Codedarstellung wurde durch die Verwendung einfacher Python-Funktionen erreicht, ohne eine bestimmte Python-Bibliothek zu importieren. Die „Transponierung“ zweier Datensätze kann mit den NumPy-Arrays ermittelt werden. Dazu müssen wir zu Beginn die NumPy-Bibliothek als „n“ importieren. Das grundlegende Format ist dasselbe, aber wir müssen den Shape-Datensatz mit dem Schlüsselwort „array“ initialisieren, anstatt das Schlüsselwort „variable“ zu verwenden. Das Beispiel-NumPy-Array sollte auf die Variable „d“ zurückgehalten werden. Dasselbe NumPy-Objekt „n“ wird verwendet, um die Funktion transpose() für die Variable „d“ aufzurufen und ihr Ergebnis in der Variablen „val“ zu speichern.

Die print-Anweisung hat die darin enthaltene „val“-Variable aufgerufen, um ihren Transponierungstensor anzuzeigen. Sie sehen, um den resultierenden transponierten Wert der „val“-Variablen anzuzeigen, brauchen wir hier die „eval“-Funktion nicht. Nun haben wir die Variablenfunktion mit dem Argument „d“ verwendet und das Ergebnis in der Variablen „z“ gespeichert. Nachdem Sie die print-Anweisung durch Hinzufügen des Argumentwerts „z“ ausprobiert hatten, wurde die Ausgabe im gleichen vorherigen Format angezeigt, das wir im obigen Variablenbeispiel ausprobiert haben.

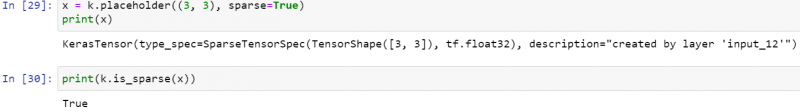

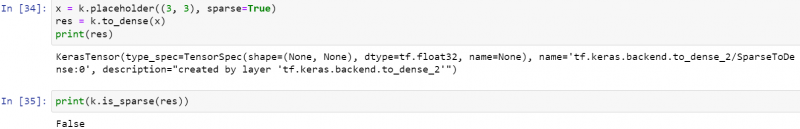

Is_sparse()-Funktion

Das Wort „spärlich“ in Tensor wird für einen spärlichen Tensor verwendet, der hauptsächlich Einträge mit Nullen enthält. In diesem Beispiel verwenden wir die Funktion is_sparse() des Backend-Moduls, um zu prüfen, ob der Tensor die meisten Nullen enthält oder nicht.

Zuerst haben wir die Funktion placeholder() aufgerufen, um die Tensorform (3,3) zusammen mit dem auf true gesetzten Argument Sparse zu halten. Dieser Platzhalterwert würde auf dem veränderlichen „x“ gehalten und angezeigt. Die Ausgabe hat die Informationen bezüglich der Platzhaltervariablen „x“ angezeigt.

Beispielsweise werden ihr Datentyp, ihre Form und ihre Funktion darauf angewendet. Danach haben wir die print-Anweisung noch einmal ausprobiert, indem wir die Funktion is_Sparse() darin aufgerufen haben. Diese Funktion hat die Variable „x“ als Argument verwendet, um anzuzeigen, ob der „x“-Tensor spärlich ist oder nicht. Die Ausgabe zeigt „true“ an.

To_dense() Funktion

Der dichte Tensor soll derjenige sein, der den chronologischen Speicherblock verwendet hat, um die Informationen auf angrenzende Weise zu speichern und auch die Informationswerte darzustellen. Die Funktion „to_dense()“ des Backend-Moduls lässt uns den Sparse-Tensor in einen Dense-Tensor umwandeln. Daher verwenden wir dieselbe Platzhalterfunktion, um den Tensor zur Variablen „x“ hinzuzufügen, und dieser Tensor wurde auf „spärlich“ gesetzt.

Die Funktion „to_dense()“ wird auf die Dense-Tensor-Variable „x“ angewendet, d. h. um sie in einen Dense-Tensor umzuwandeln und in einer anderen Variablen „res“ zu speichern. Nun, das „res“ ist selbst ein dichter Tensor. Die print-Anweisung wurde verworfen, um die „res“-Variable auszugeben. Die Verwendung von Druckanweisungen für die Variable „res“ zeigte die Informationen bezüglich der konvertierten Variable „res“ an, d.

Dann wird eine weitere Druckfunktion aufgerufen, indem die darin enthaltene Funktion is_sparse() verwendet wird, um zu prüfen, ob die Variable „res“ dünn besetzt ist oder nicht. Die Ausgabe hat gezeigt, dass die Variable „res“ nicht spärlich ist, d. h. wir haben sie bereits in einen „dichten“ Tensor umgewandelt.

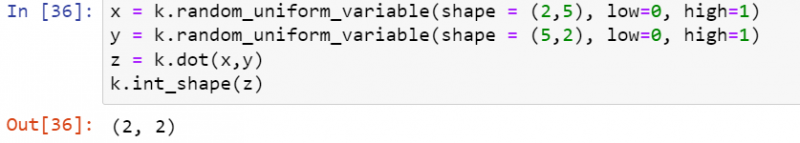

Random_uniform_variable() Funktion

Die Funktion random_uniform_variable() im Backend-Modul von Keras ist speziell für die Initialisierung eines Tensors über die Gleichverteilung ausgelegt. Es braucht insgesamt drei Argumente. Das allererste Argument „Form“ wird verwendet, um die Zeilen und Spalten der Form innerhalb des Tupelformulars zu definieren. Wenn Sie sich mit Mathematik beschäftigt haben, haben Sie vielleicht das Konzept von Mittelwert und Standardabweichung gelernt.

In der Methode random_uniform_variable() sind die nächsten beiden Argumente der Mittelwert und die typische Abweichung von einer Gleichverteilung. In dieser Abbildung haben wir zwei Tensoren „x“ und „y“ unter Verwendung der standardmäßigen Gleichverteilung über die Funktion random_uniform_variable() initialisiert. Beide Tensoren enthalten unterschiedliche Formformate, d. h. Zeilen und Spalten mit demselben Mittelwert und derselben Standardabweichung, d. h. niedrig=0 und hoch=1.

Danach werfen wir die „Punkt“-Funktion ab und nehmen die „x“- und „y“-Tensoren darin zur Multiplikation. Das Ergebnis dieser Multiplikation würde in der Variablen „z“ gespeichert. Letztendlich ist int_shape() ein Muss, um die Form eines resultierenden Tensors „z“ anzuzeigen. Die Ausgabe zeigt den Tensor (2,2).

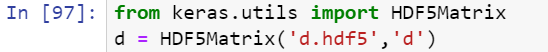

Dienstprogramme

Wenn Sie einige der sehr nützlichen Funktionen aus dem Deep-Learning-Konzept von Python nutzen möchten, müssen Sie das utils-Modul der Keras-Bibliothek in Ihren Skripten verwenden. Wenn Sie beispielsweise Ihre Daten im HDF5Matrix-Format anzeigen möchten, müssen Sie die HDF5Matrix-Klasse importieren und ihre HDF5Matrix-Funktion im Skript verwenden.

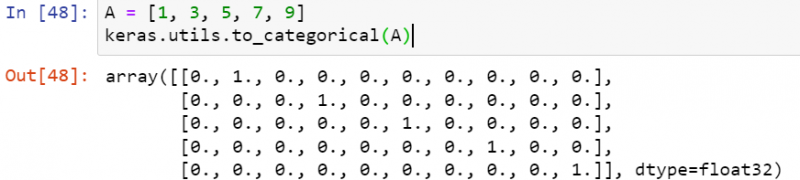

To_categorical() Funktion

Mit dieser Funktion können Sie einen Klassenvektor in eine Matrix umwandeln, d. h. in eine binäre Klassenmatrix. Nehmen wir an, wir haben die Funktion to_categorical() aus dem utils-Modul importiert und einen Vektor „A“ initialisiert. Der Vektor „A“ wurde an die Funktion to_categorical() übergeben. Die binäre Matrix für diesen Klassenvektor 'A' wurde angezeigt.

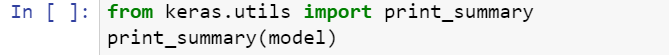

print_summary() Funktion

Um die Zusammenfassung eines Modells auszudrucken, das wir in unserer Umgebung abgelegt haben, wurde die Funktion print_summary verwendet.

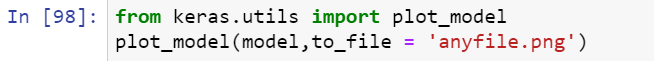

plot_model() Funktion

Die Funktion plot_model() kennzeichnet das Modell in einem Punktformat und ermöglicht es Ihnen, es in einem Dokument zu speichern.

Fazit

Zusammenfassend können wir sagen, dass die Python-Sprache eine notwendige Sprache für die heutige Zeit ist, da alles schnell wird und sich die Technologie so wahnsinnig schnell entwickelt hat. In dieser Lernrichtlinie haben wir uns mit der Verwendung der Keras-Bibliothek von Python in Deep Learning und künstlichen neuronalen Netzen beschäftigt. Dazu sind wir auch die Bedeutung und Verwendung seiner Backend-Bibliothek „TensorFlow“ durchgegangen, um ein klares Verständnis zu bekommen. Darüber hinaus haben wir jede Konfiguration besprochen und erklärt, die zum Einrichten der Keras- und Anaconda-Umgebung in Python innerhalb des Linux-Betriebssystems Ubuntu 20.04 erforderlich ist. Danach haben wir die Keras-Modelle, -Ebenen und -Module zusammen mit ihren am häufigsten verwendeten Funktionen ausführlich besprochen. Die Demonstration des Funktions-API-Modells finden Sie in der offiziellen Dokumentation.